iPAS AI應用規劃師 考試重點

L23202 常見機器學習演算法

主題分類

1

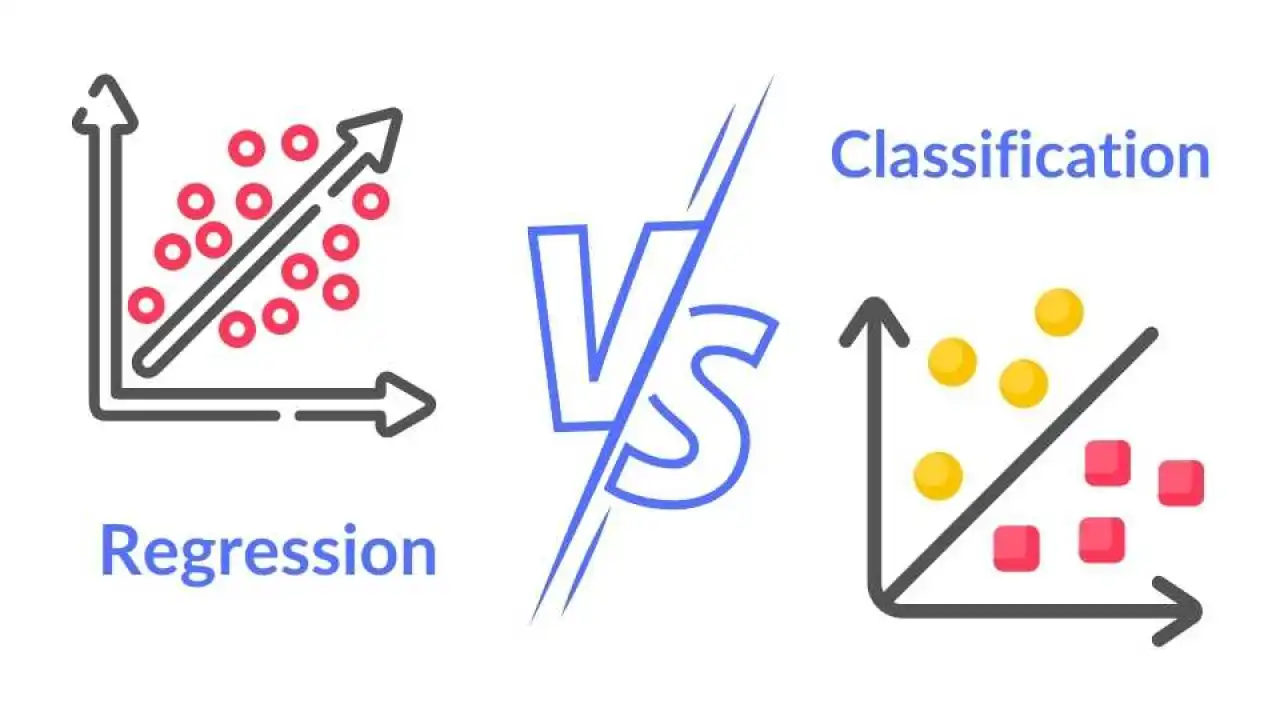

監督式學習 - 迴歸演算法

2

監督式學習 - 分類演算法

3

非監督式學習演算法

4

強化學習基本概念

5

集成學習方法

6

深度學習演算法概覽

7

演算法選擇考量

8

演算法評估簡介

#1

★★★★

線性迴歸 (Linear Regression)

演算法原理與應用 (參考樣題 Q8, Q9)

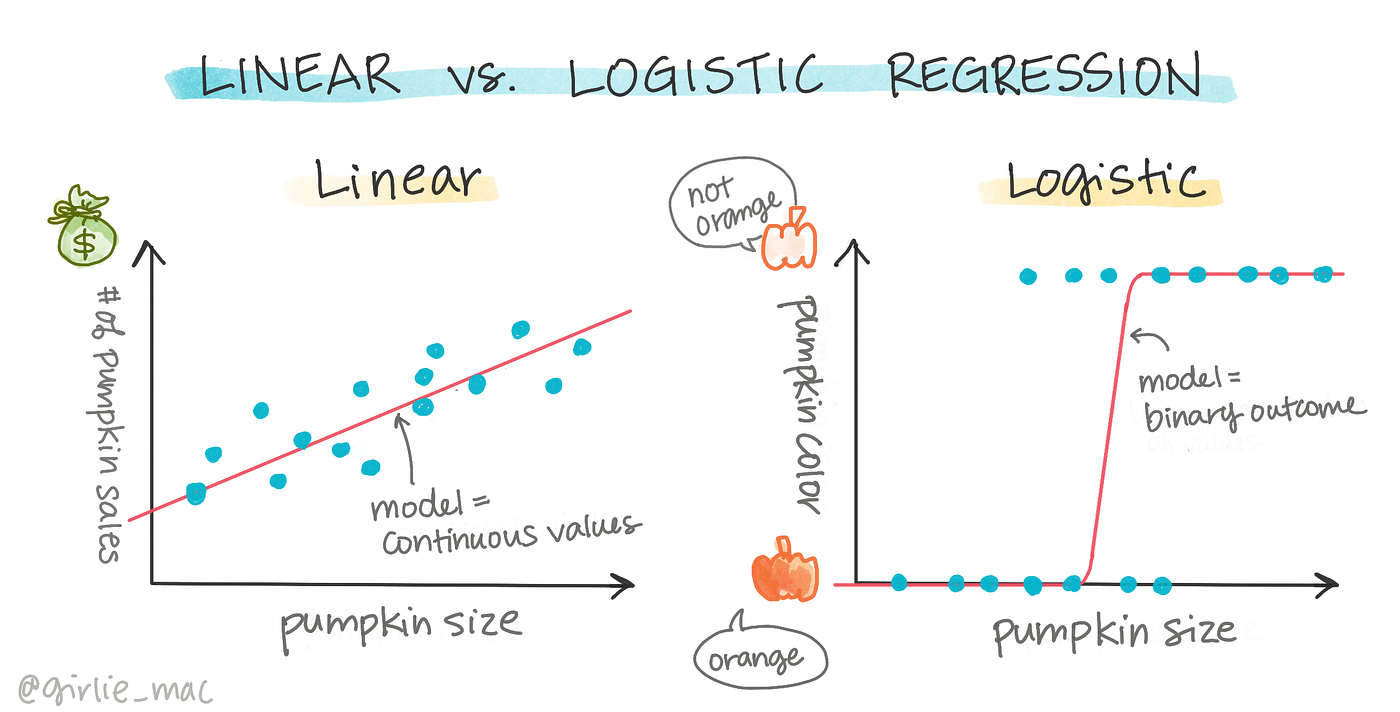

線性迴歸 是一種監督式學習演算法,用於預測連續數值的輸出。它假設輸入特徵與輸出之間存在線性關係。

目標:找到一條最佳擬合直線(或超平面)來描述數據。

應用:銷售額預測 (樣題 Q8)、房價預測、經濟預測等。

樣題 Q9 提到其模型是線性的。

目標:找到一條最佳擬合直線(或超平面)來描述數據。

應用:銷售額預測 (樣題 Q8)、房價預測、經濟預測等。

樣題 Q9 提到其模型是線性的。

#2

★★★

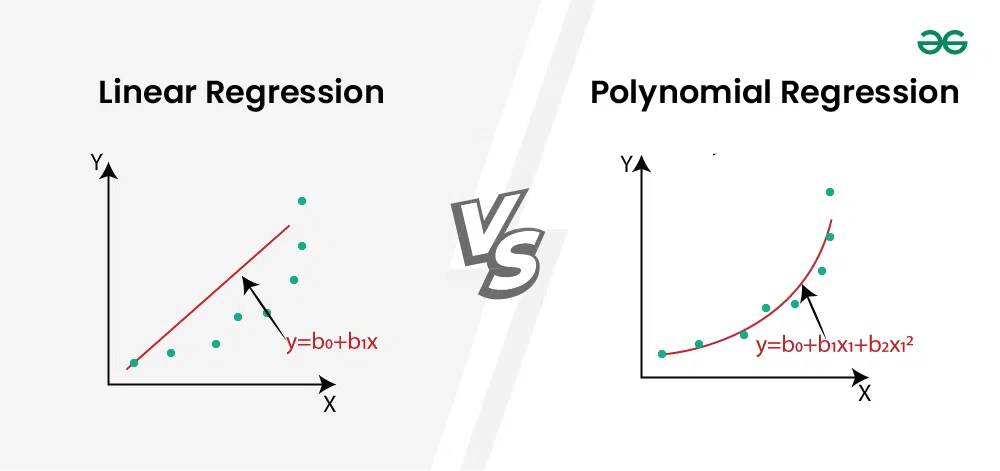

多項式迴歸 (Polynomial Regression)

演算法原理與應用

線性迴歸的一種擴展,允許模型擬合非線性的數據關係。它透過創建輸入特徵的多項式組合(如平方、立方、交互項)作為新的特徵,然後應用線性迴歸。需要注意選擇合適的階數以避免過擬合。

#3

★★★

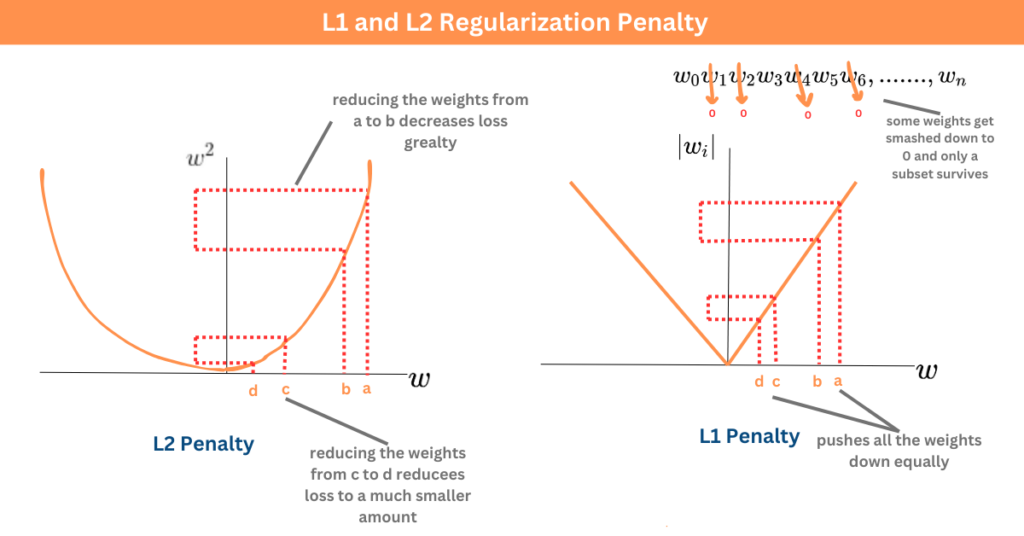

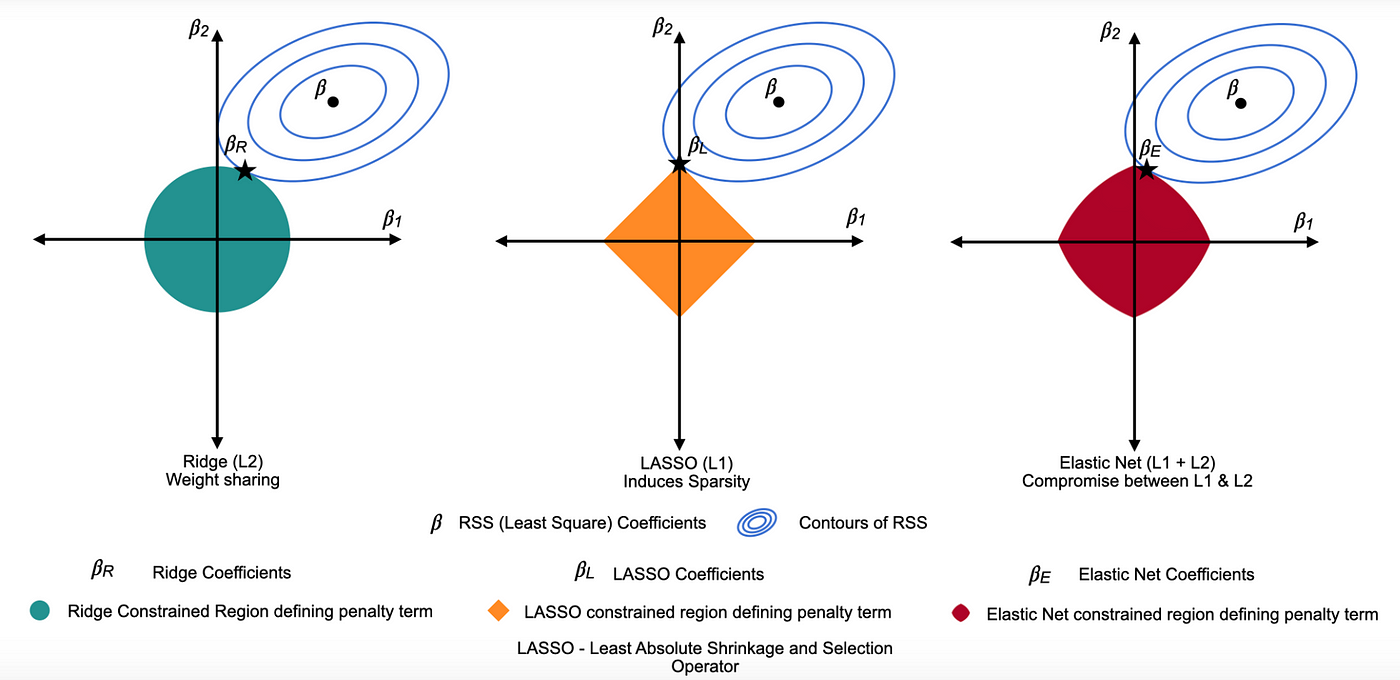

嶺迴歸 (Ridge Regression) - L2 正則化

正則化迴歸

在線性迴歸的損失函數中加入L2 正則化項(權重平方和)。目的是懲罰過大的權重,防止模型過擬合,特別是在處理共線性(特徵高度相關)問題時效果較好。權重會變小但通常不為零。

#4

★★★

Lasso 迴歸 (Lasso Regression) - L1 正則化

正則化迴歸

在線性迴歸的損失函數中加入L1 正則化項(權重絕對值之和)。除了防止過擬合,Lasso 的一個重要特性是能夠將某些不重要特徵的權重縮減至零,從而實現自動特徵選擇。

#5

★★

彈性網路迴歸 (Elastic Net Regression)

正則化迴歸

結合了 L1 和 L2 正則化的迴歸模型。試圖同時獲得 Lasso 的稀疏性和 Ridge 的穩定性,尤其適用於特徵數量多於樣本數量或特徵間存在高度相關性的情況。

#6

★★★★

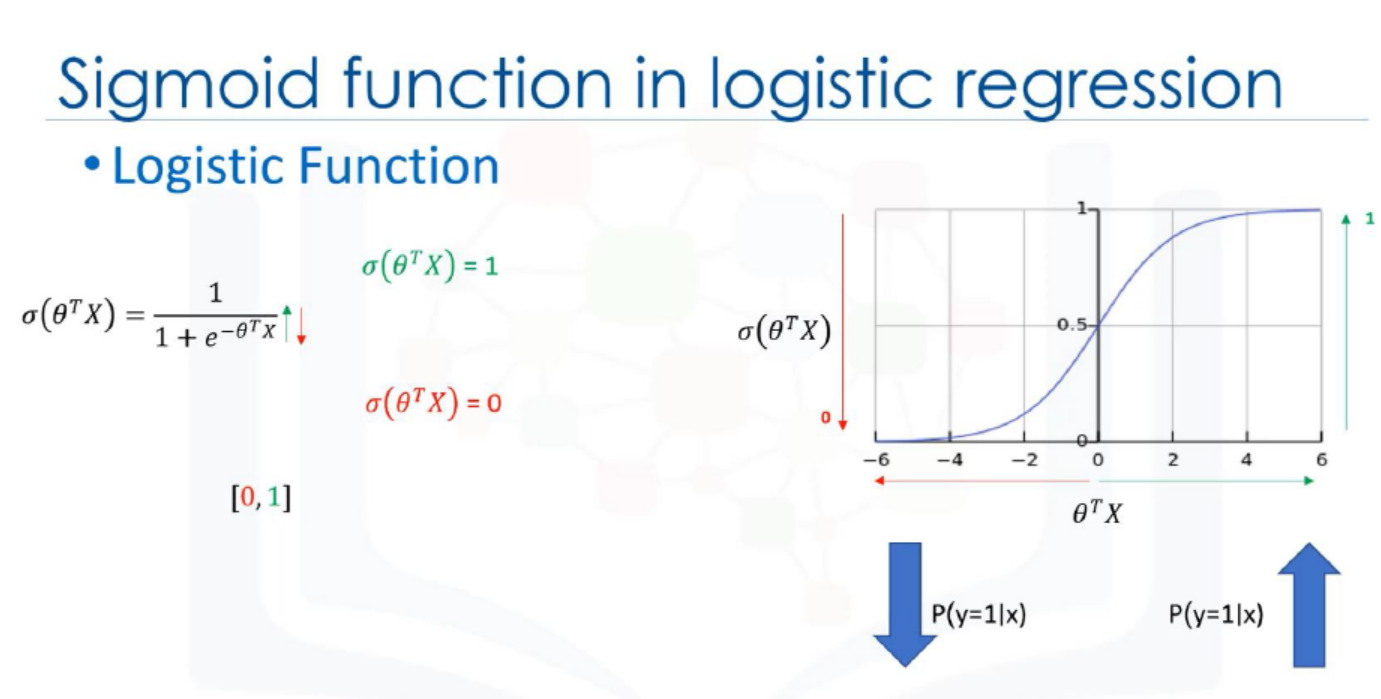

邏輯迴歸 (Logistic Regression)

演算法原理與應用

雖然名為「迴歸」,但邏輯迴歸是一種常用的監督式學習的分類演算法。它使用 Sigmoid 函數將線性組合的輸出映射到 (0, 1) 之間,表示屬於某個類別的機率。

常用於二元分類問題(如判斷郵件是否為垃圾郵件、客戶是否會流失)。也可以擴展到多元分類。

常用於二元分類問題(如判斷郵件是否為垃圾郵件、客戶是否會流失)。也可以擴展到多元分類。

#7

★★★★

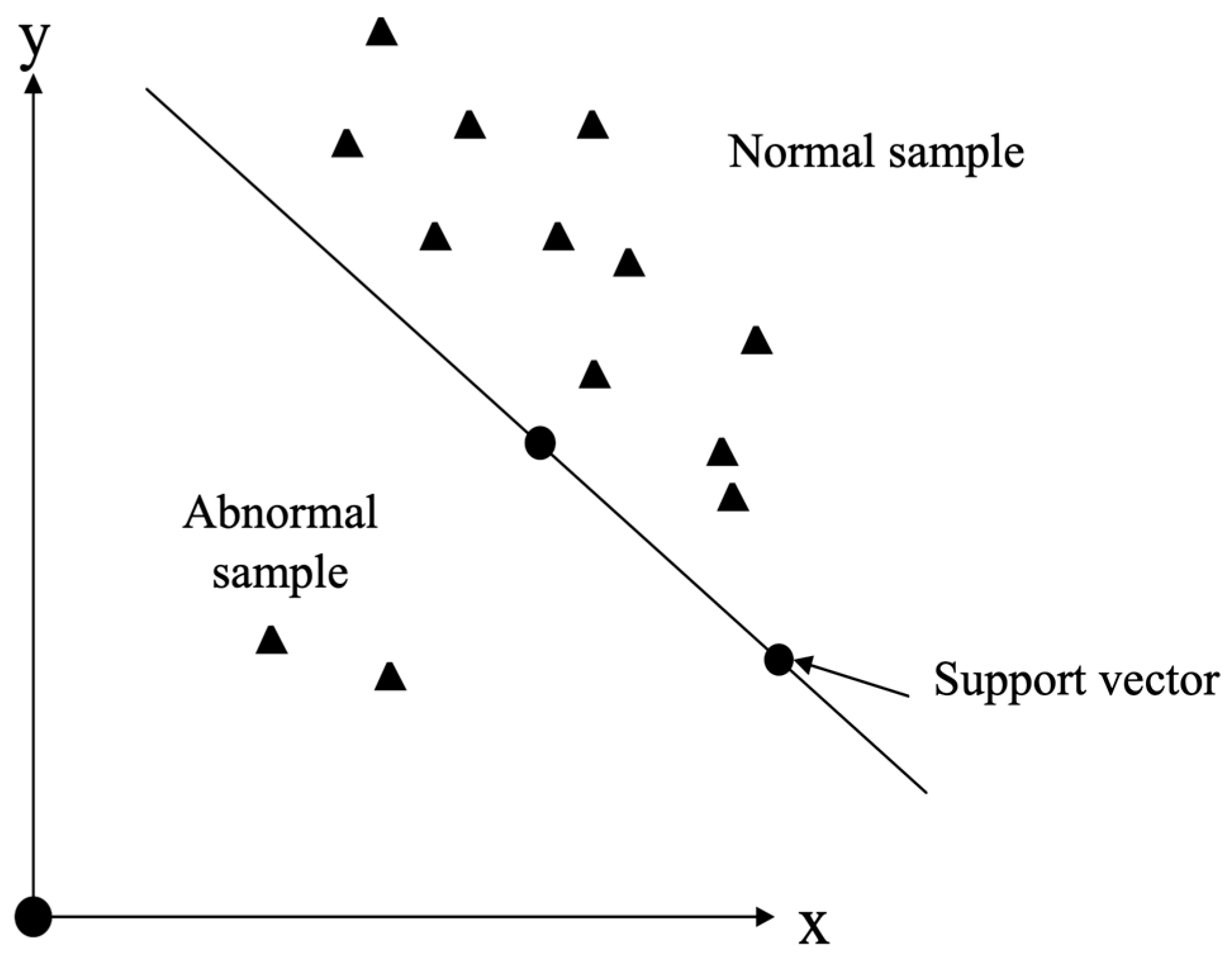

支持向量機 (SVM, Support Vector Machine)

演算法原理與應用

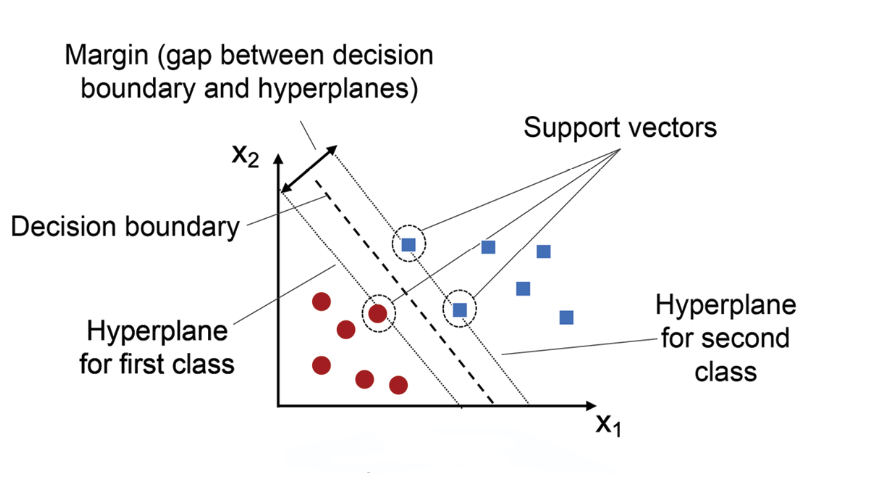

SVM 是一種強大的監督式學習演算法,主要用於分類,也可用於迴歸。其核心思想是找到一個能夠最大化不同類別數據點之間邊界 (Margin) 的決策邊界(超平面)。

透過核技巧 (Kernel Trick) (如高斯核 RBF、多項式核),SVM 可以有效地處理非線性問題。在高維空間表現良好。

透過核技巧 (Kernel Trick) (如高斯核 RBF、多項式核),SVM 可以有效地處理非線性問題。在高維空間表現良好。

#8

★★★★

決策樹 (Decision Tree)

演算法原理與應用 (參考樣題 Q9)

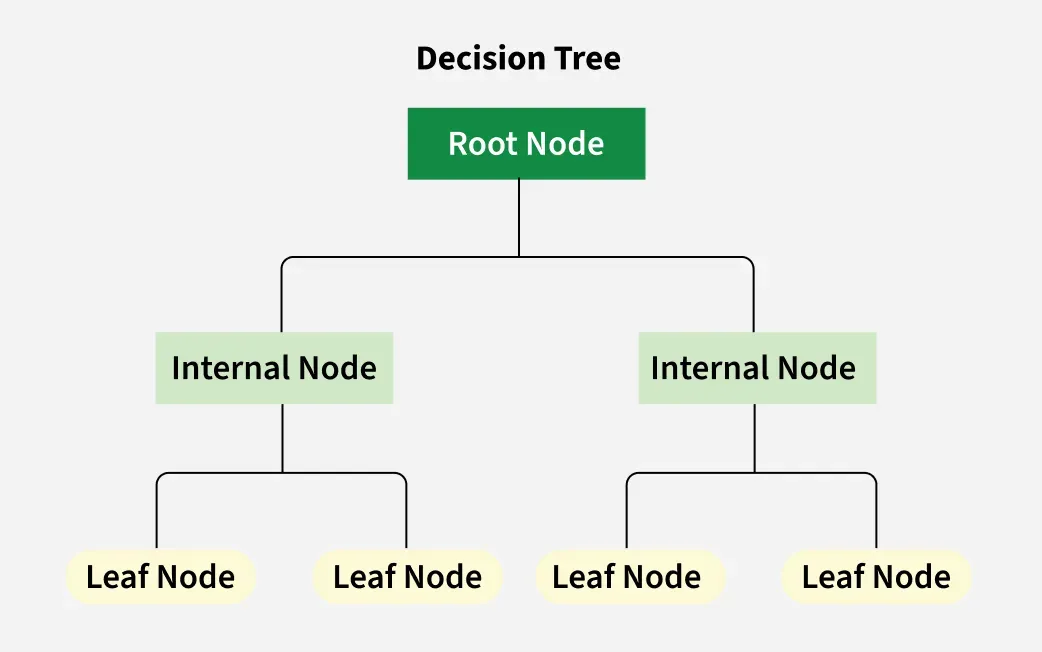

決策樹是一種監督式學習演算法,可用於分類和迴歸。它構建一個樹狀結構,每個內部節點代表一個特徵測試,每個分支代表測試結果,每個葉節點代表最終的預測(類別或數值)。

優點是模型直觀、易於解釋。缺點是單棵決策樹容易過擬合。

樣題 Q9 提到其常用於集成學習的基模型。

優點是模型直觀、易於解釋。缺點是單棵決策樹容易過擬合。

樣題 Q9 提到其常用於集成學習的基模型。

#9

★★★

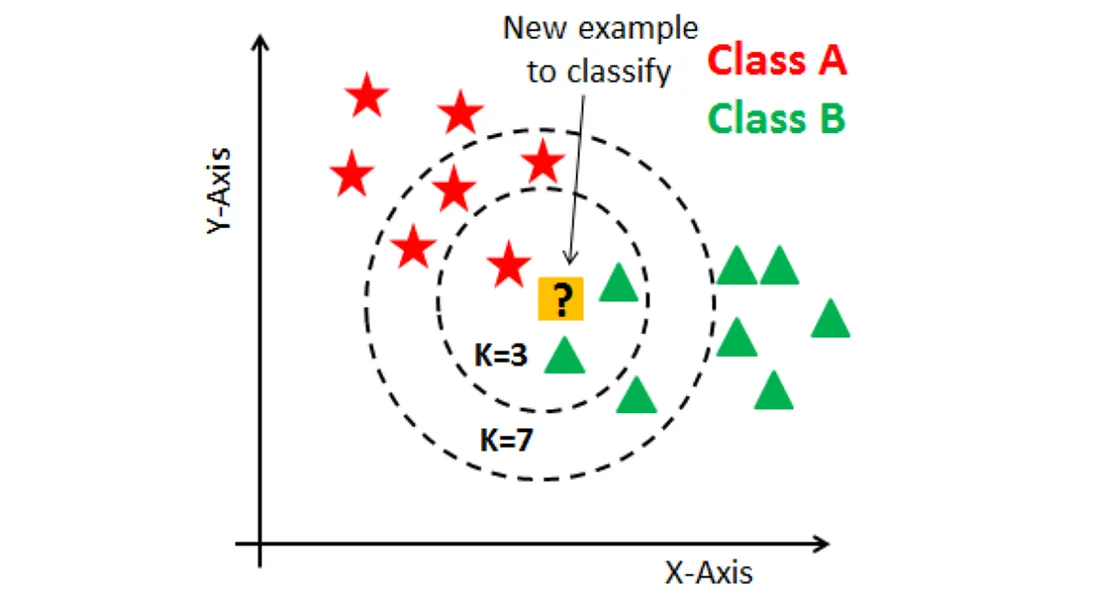

K-近鄰 (KNN, K-Nearest Neighbors)

演算法原理與應用

KNN 是一種監督式學習的非參數、懶惰學習演算法,可用於分類和迴歸。它基於「物以類聚」的思想,預測新樣本時,查找訓練集中與其距離最近的 K 個樣本(鄰居),然後根據這些鄰居的標籤進行投票(分類)或平均(迴歸)。

#10

★★★

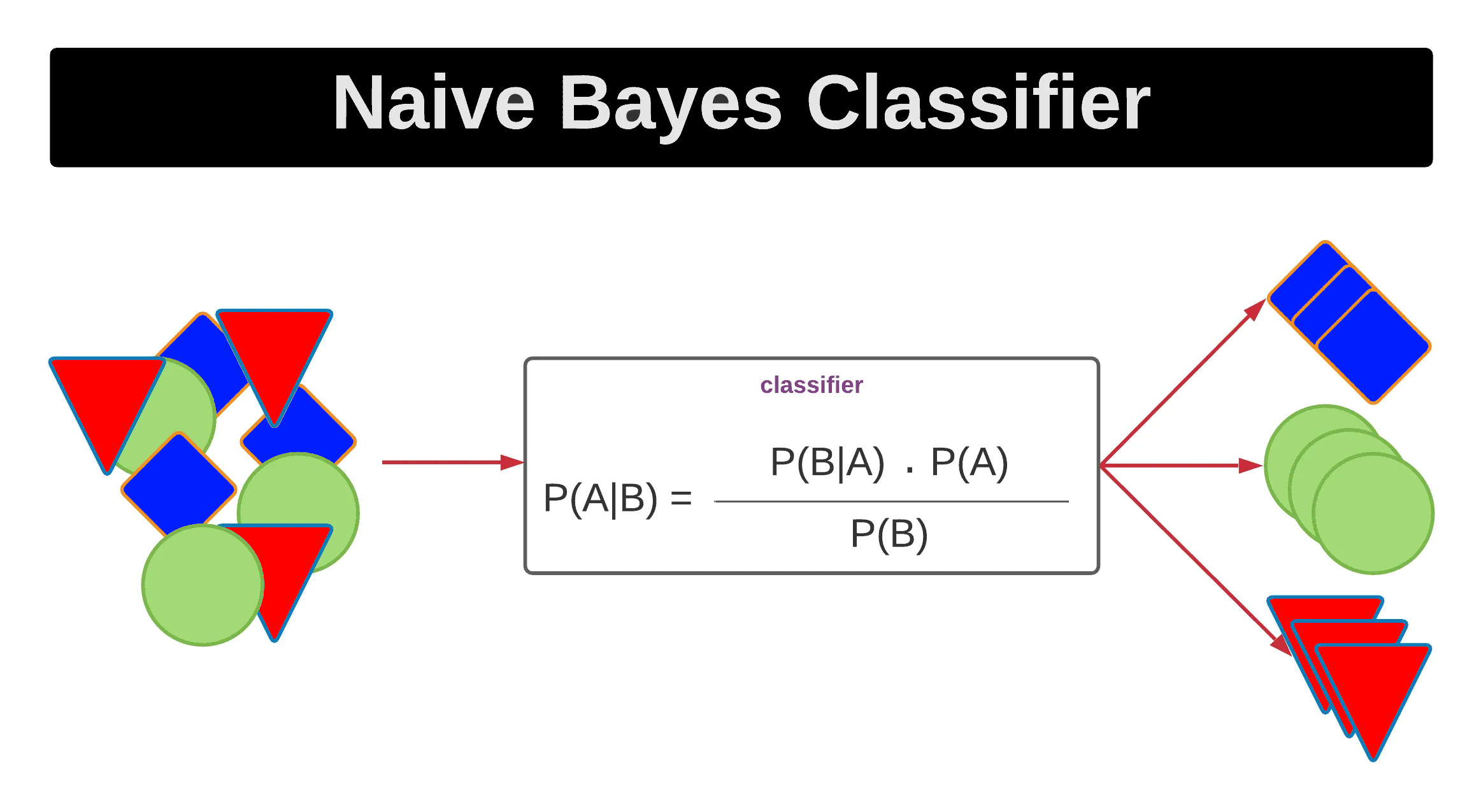

樸素貝氏 (Naive Bayes)

演算法原理與應用

樸素貝氏是一類基於貝氏定理的監督式學習分類演算法。其核心假設是特徵之間相互獨立(「樸素」的來源)。儘管這個假設在現實中很少完全成立,但樸素貝氏在文本分類(如垃圾郵件檢測)等領域表現通常不錯,且計算效率高。

#11

★★★★★

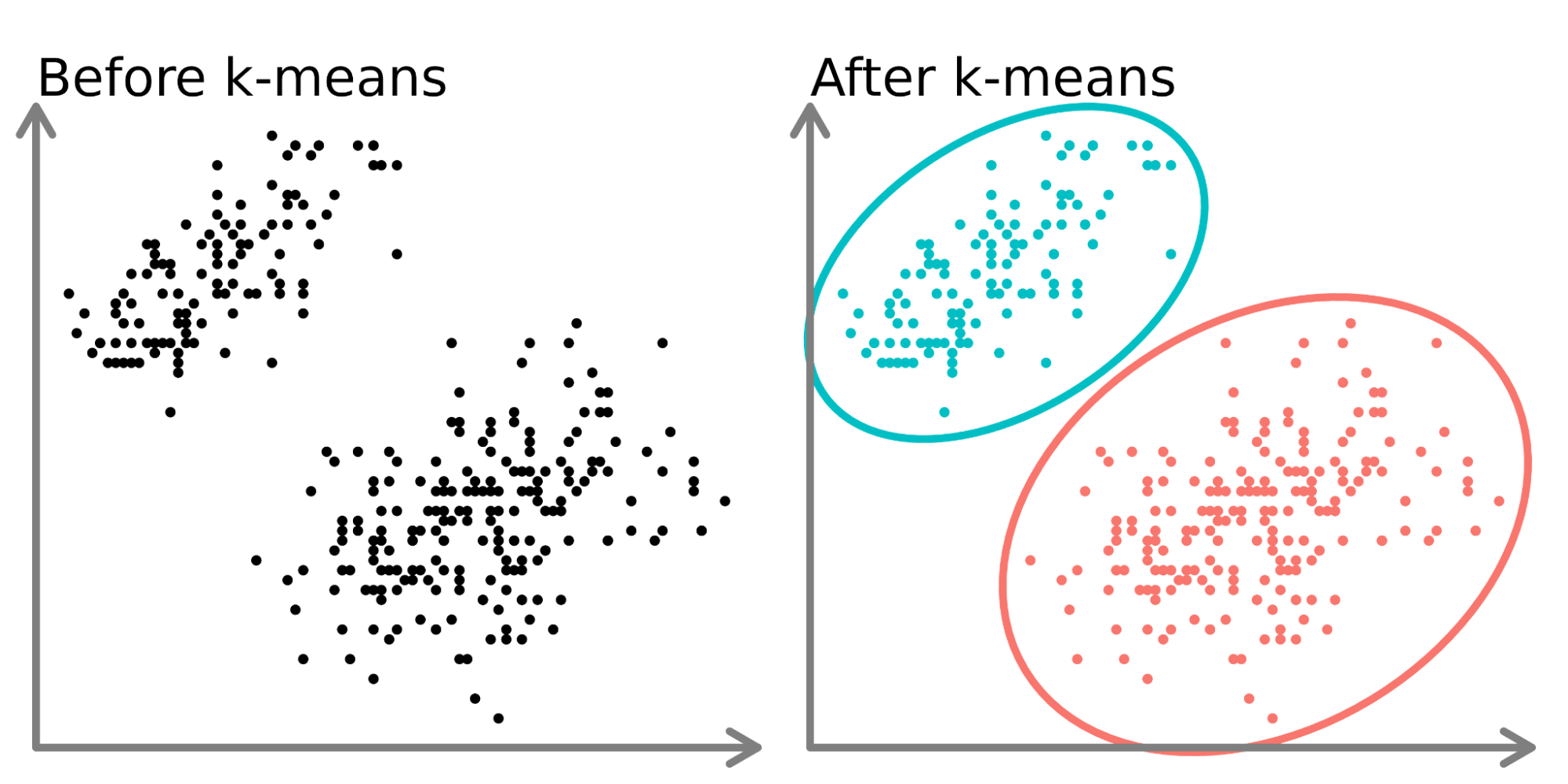

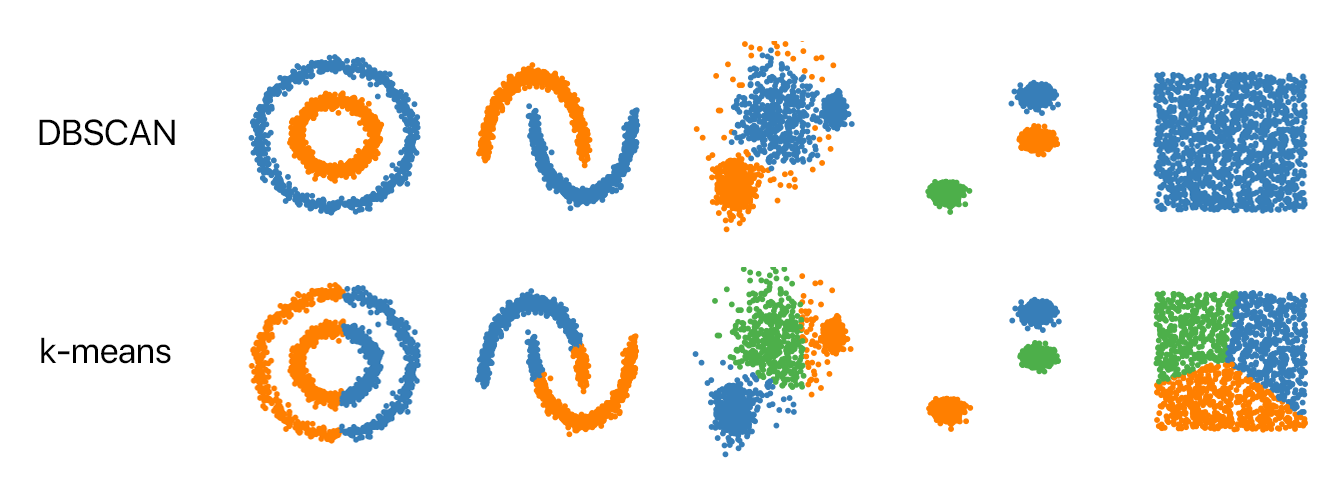

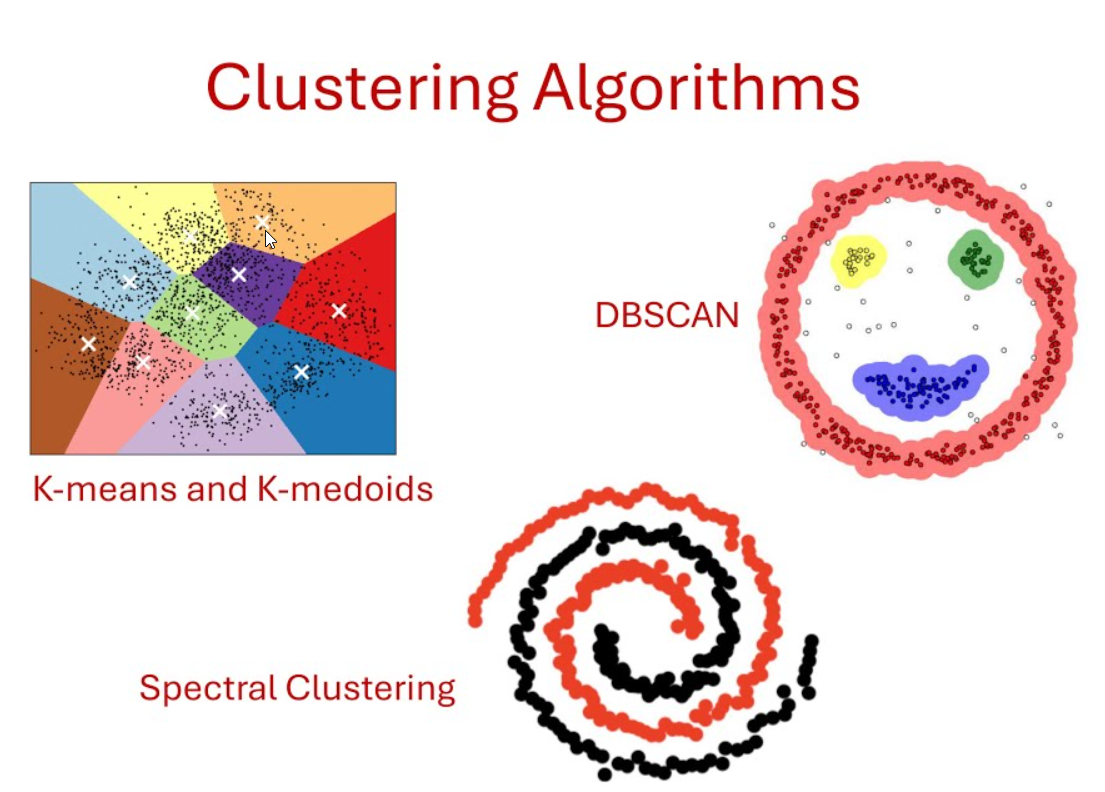

K-均值 (K-Means) 分群

演算法原理與應用 (參考樣題 Q5)

K-均值是最常用的非監督式學習分群 (Clustering) 演算法之一。目標是將數據集劃分為 K 個互斥的群集,使得每個數據點都屬於距離其最近的群集中心(質心, Centroid),同時最小化群內平方和。

步驟:隨機初始化 K 個質心 -> 將每個點分配給最近的質心 -> 重新計算每個群集的質心 -> 重複分配和更新步驟直到收斂。

樣題 Q5 指出其目標是找 K 個互不交集群集,結果受初始質心影響,且易受離群值影響,不能直接處理類別型數據。

步驟:隨機初始化 K 個質心 -> 將每個點分配給最近的質心 -> 重新計算每個群集的質心 -> 重複分配和更新步驟直到收斂。

樣題 Q5 指出其目標是找 K 個互不交集群集,結果受初始質心影響,且易受離群值影響,不能直接處理類別型數據。

#12

★★★

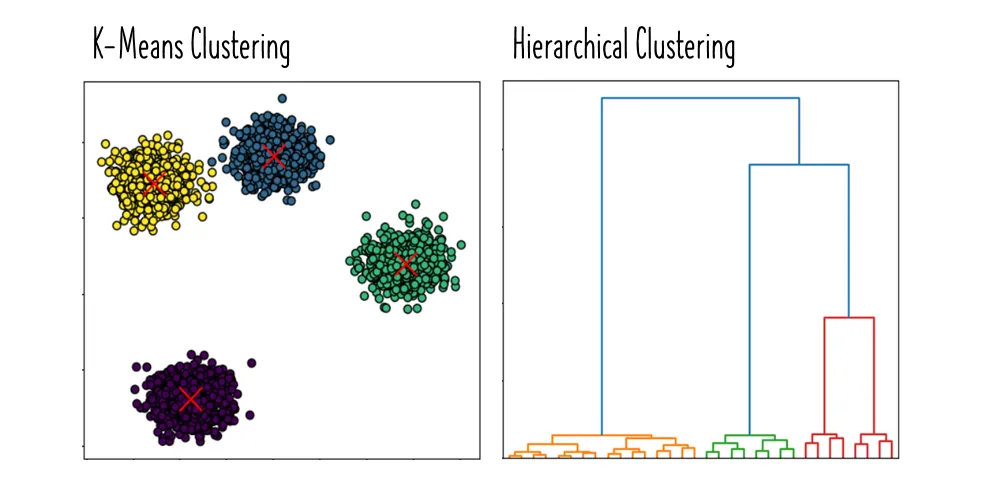

階層式分群 (Hierarchical Clustering)

演算法原理與應用

一種非監督式學習分群方法,它創建一個巢狀的群集結構(樹狀圖, Dendrogram)。有兩種主要策略:

- 凝聚式 (Agglomerative): 從每個點自成一類開始,逐步合併最接近的群集。

- 分裂式 (Divisive): 從所有點歸為一類開始,逐步分裂群集。

#13

★★★

DBSCAN (Density-Based Spatial Clustering of Applications with Noise)

演算法原理與應用

一種基於密度的非監督式學習分群演算法。它將密集區域中的點連接起來形成群集,並將稀疏區域中的點標記為噪聲或離群值。

優點:能夠發現任意形狀的群集,對噪聲不敏感,不需要預先指定群集數量。

缺點:對參數(鄰域半徑 ε 和最小點數 MinPts)敏感,對密度差異大的數據集效果不佳。

優點:能夠發現任意形狀的群集,對噪聲不敏感,不需要預先指定群集數量。

缺點:對參數(鄰域半徑 ε 和最小點數 MinPts)敏感,對密度差異大的數據集效果不佳。

#14

★★★★

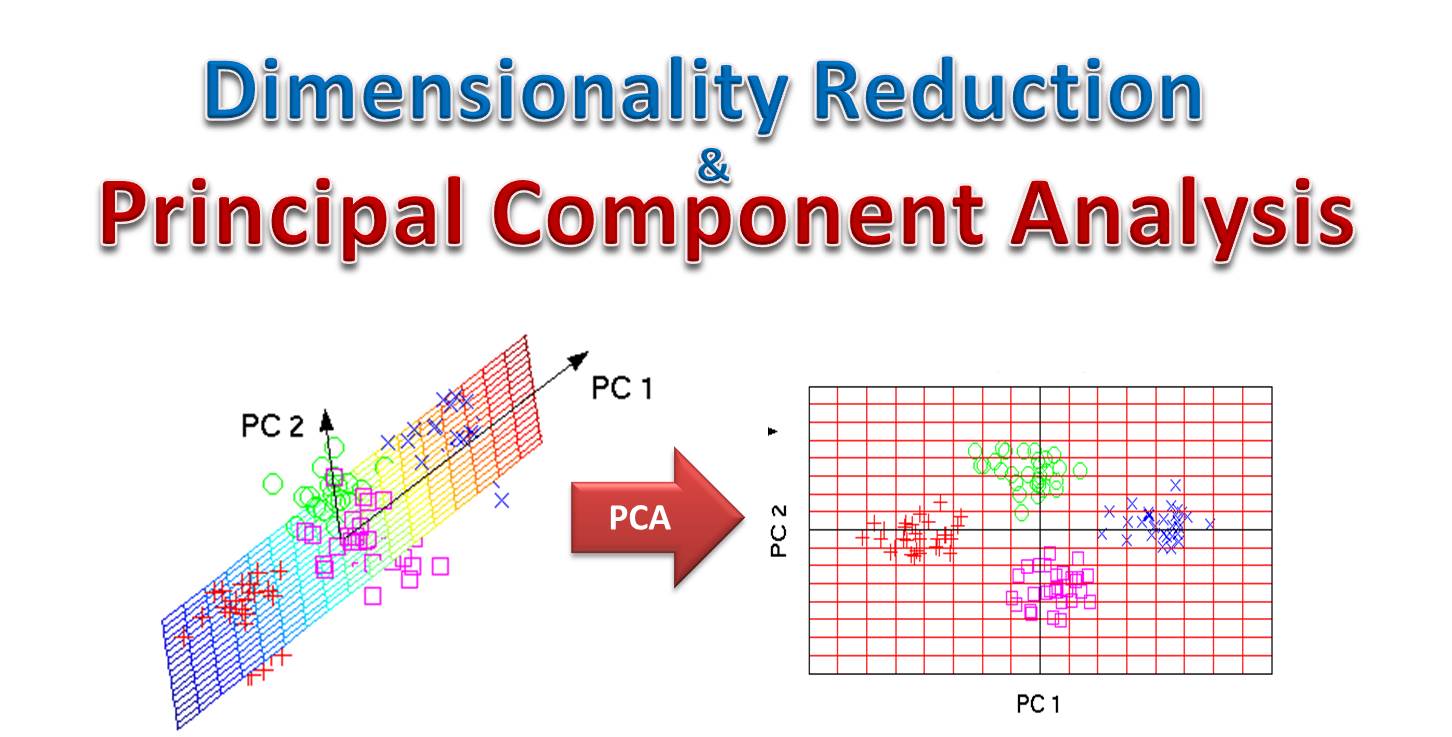

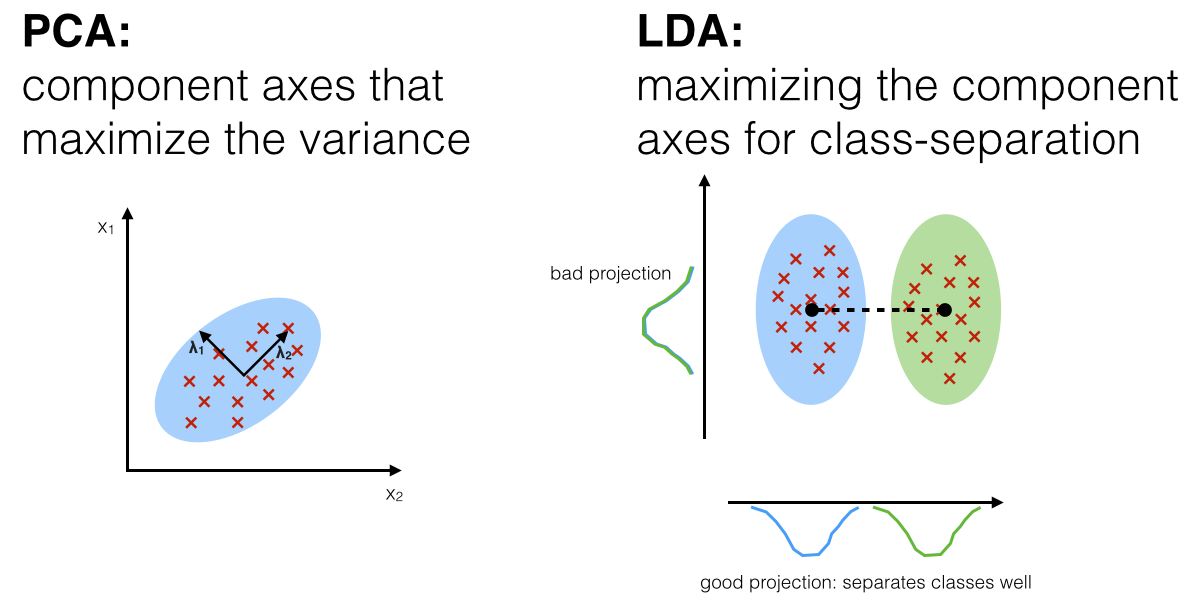

主成分分析 (PCA, Principal Component Analysis)

演算法原理與應用 (參考樣題 Q9 選項)

PCA 是一種常用的非監督式學習降維 (Dimensionality Reduction) 技術。它透過線性變換將原始高維數據投影到一個新的低維空間,使得在新的維度(主成分)上數據的變異數最大化。主成分之間相互正交(不相關)。

應用:數據壓縮、數據視覺化、噪聲過濾、特徵提取。

應用:數據壓縮、數據視覺化、噪聲過濾、特徵提取。

#15

★★

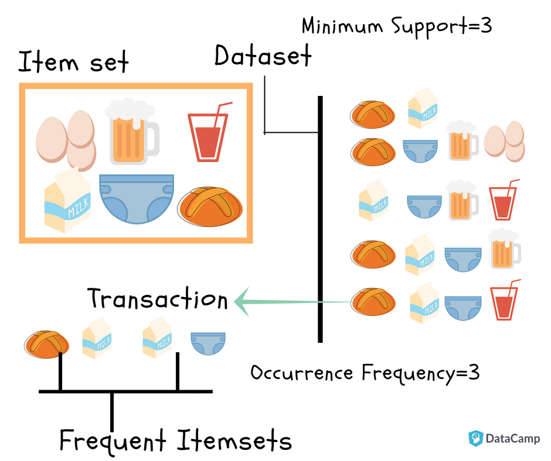

關聯規則學習 (Association Rule Learning) - Apriori

演算法原理與應用

一種非監督式學習方法,用於發現數據集中項目之間有趣的關聯關係或共現模式。常用於市場籃分析(例如,「購買麵包的顧客也經常購買牛奶」)。

Apriori 演算法是挖掘頻繁項集 (Frequent Itemsets) 和生成關聯規則的經典算法。關鍵指標包括支持度 (Support)、信賴度 (Confidence) 和提升度 (Lift)。

Apriori 演算法是挖掘頻繁項集 (Frequent Itemsets) 和生成關聯規則的經典算法。關鍵指標包括支持度 (Support)、信賴度 (Confidence) 和提升度 (Lift)。

#16

★★★★

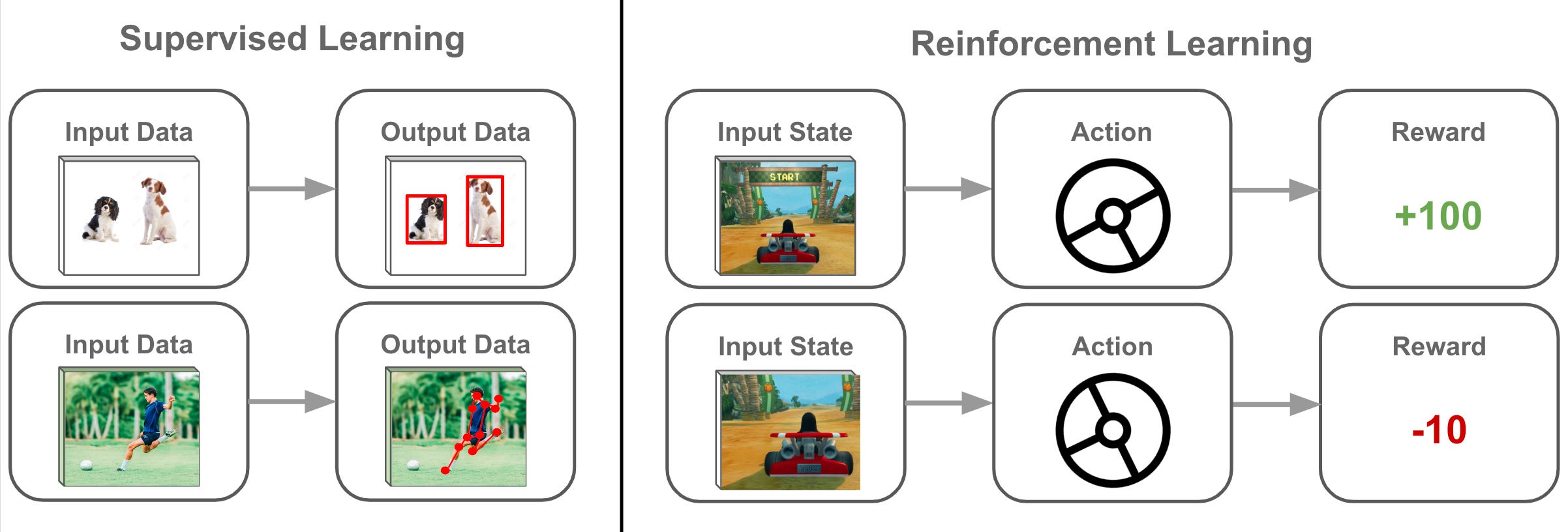

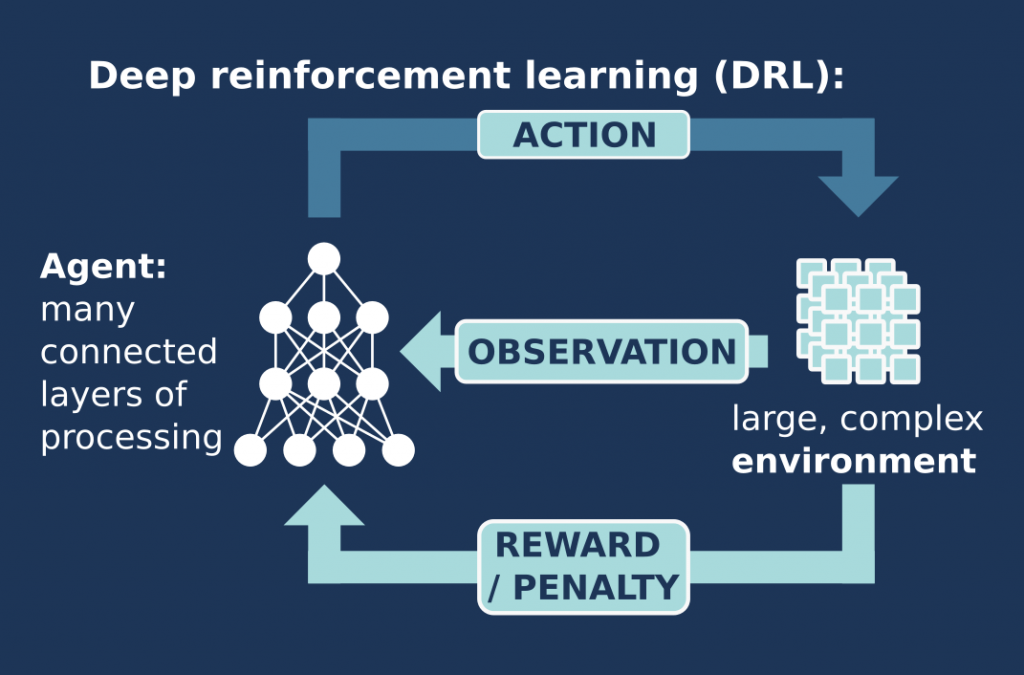

強化學習 (RL, Reinforcement Learning) - 基本概念 (參考樣題 Q2)

學習範式

RL 是一種機器學習範式,其中代理 (Agent) 透過與環境 (Environment) 互動來學習。代理在每個狀態 (State) 下選擇一個動作 (Action),環境會回饋一個獎勵 (Reward) 或懲罰,並轉移到下一個狀態。代理的目標是學習一個策略 (Policy)(狀態到動作的映射),以最大化累積獎勵。

樣題 Q2 指出 RL 適合處理動態重複互動問題,如圍棋、自動駕駛。

樣題 Q2 指出 RL 適合處理動態重複互動問題,如圍棋、自動駕駛。

#17

★★★

RL 的關鍵元素:代理、環境、狀態、動作、獎勵

核心組件

- 代理 (Agent): 學習者和決策者。

- 環境 (Environment): 代理互動的外部世界。

- 狀態 (State): 描述環境當前狀況的資訊。

- 動作 (Action): 代理可以執行的操作。

- 獎勵 (Reward): 環境對代理動作的立即回饋信號。

- 策略 (Policy): 代理選擇動作的規則或方式。

- 價值函數 (Value Function): 評估處於某個狀態或執行某個動作的長期期望回報。

#18

★★

RL 演算法分類:基於模型 vs. 無模型;基於價值 vs. 基於策略

分類方式

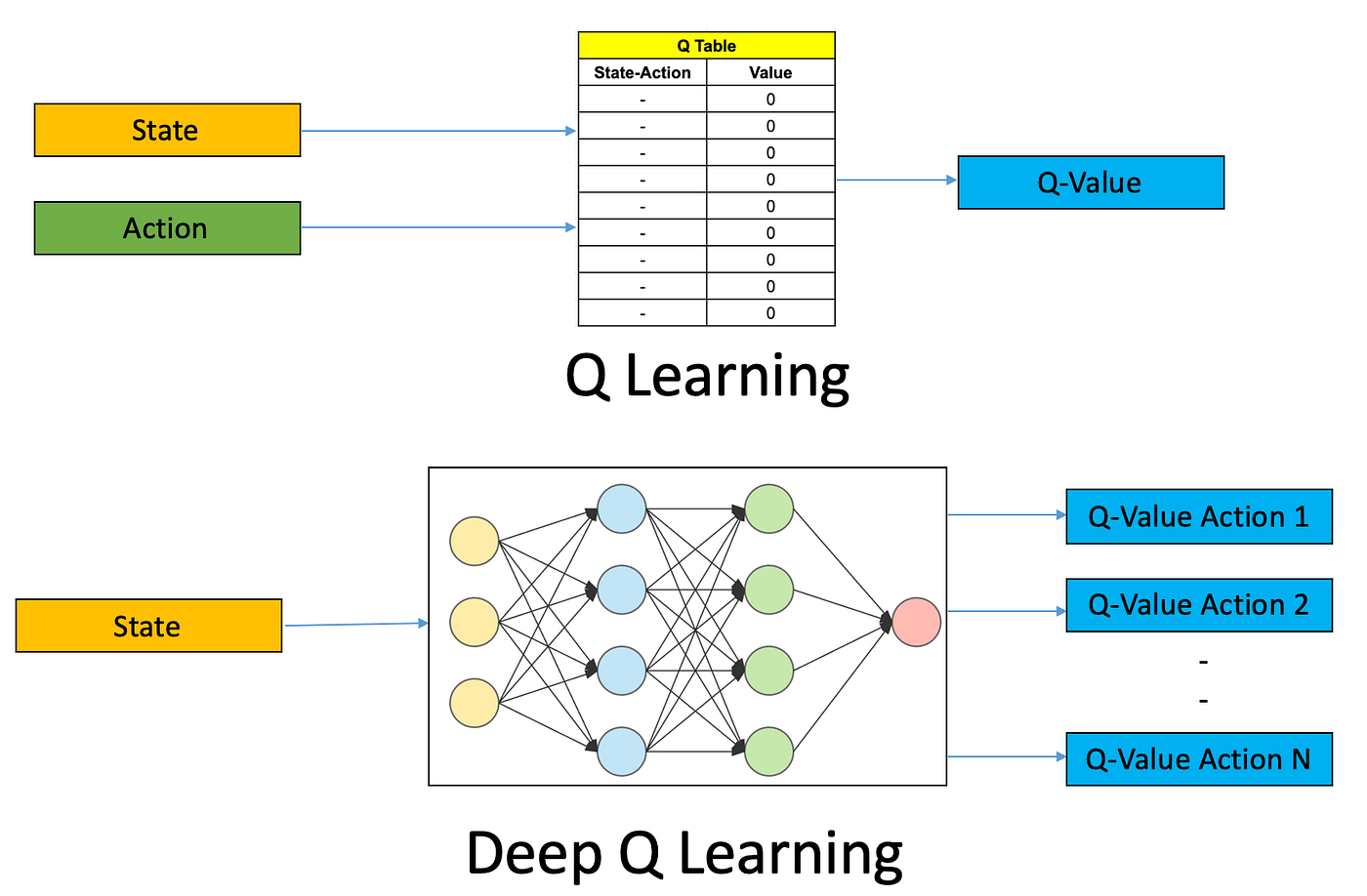

- 基於模型 (Model-based) vs. 無模型 (Model-free): 是否學習環境的模型(狀態轉移和獎勵函數)。

- 基於價值 (Value-based): 學習價值函數,策略是隱含的(如 Q-learning, DQN)。

- 基於策略 (Policy-based): 直接學習策略(如 Policy Gradients, REINFORCE)。

- 演員-評論家 (Actor-Critic): 結合基於價值和基於策略的方法。

#19

★★★

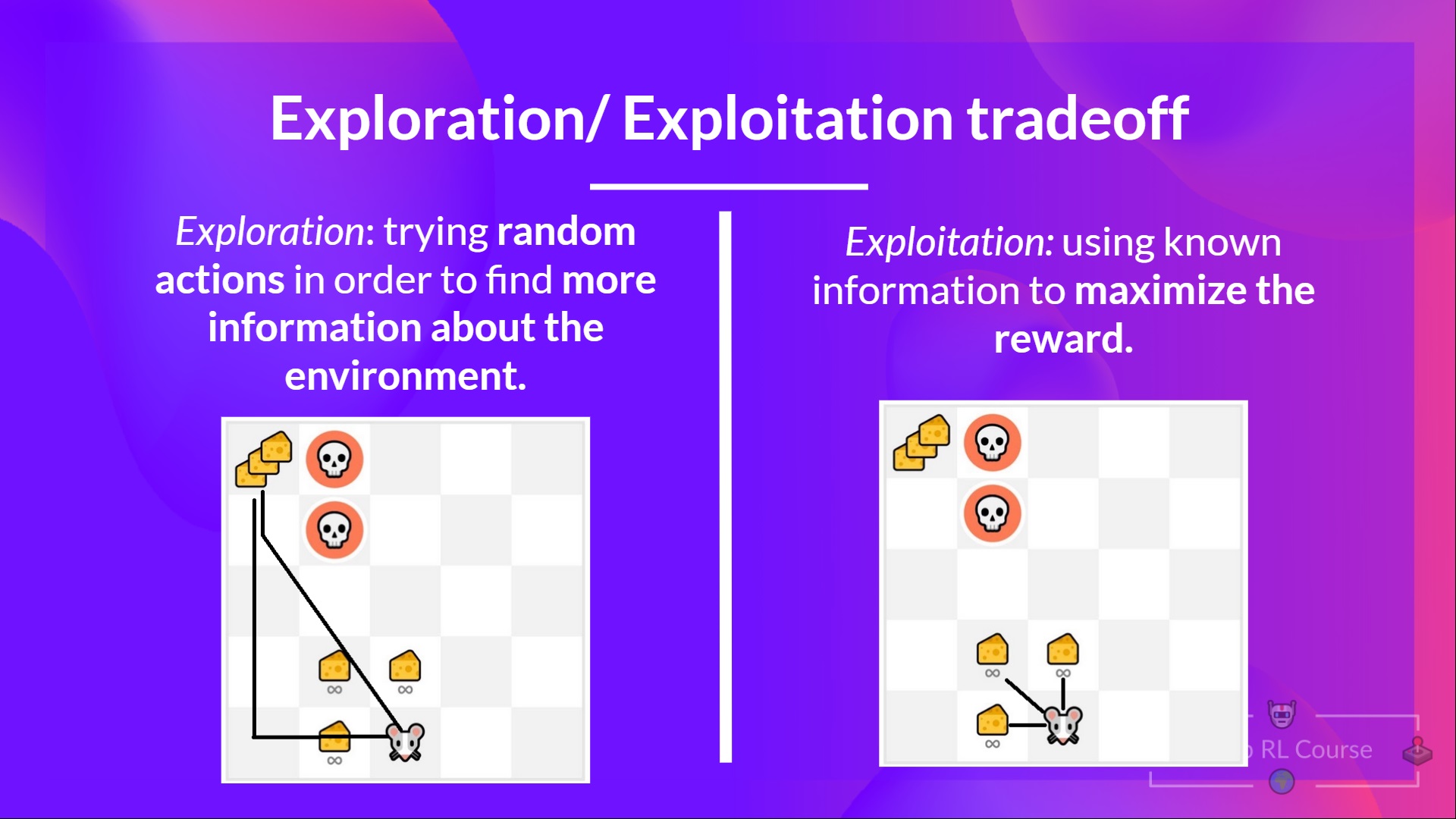

探索 (Exploration) vs. 利用 (Exploitation) 的權衡

RL 核心挑戰

RL 代理需要在以下兩者之間取得平衡:

- 利用 (Exploitation): 執行當前已知的最佳動作以獲得獎勵。

- 探索 (Exploration): 嘗試新的、未知的動作以發現可能更好的策略。

#20

★★★★

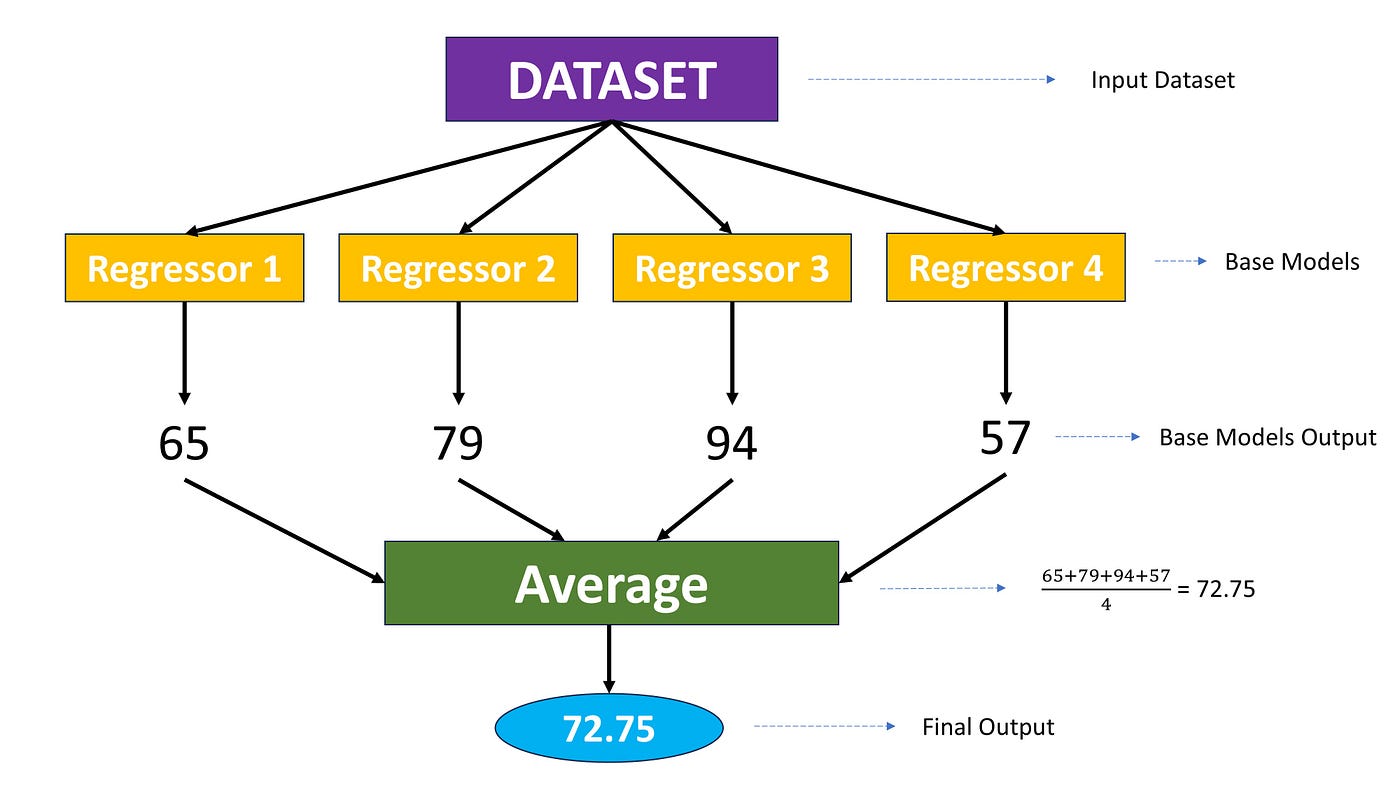

集成學習 (Ensemble Learning) - 基本思想

核心概念

集成學習通過構建並結合多個基學習器(通常是同類型但訓練方式不同的模型,或不同類型的模型)來完成學習任務,以期獲得比單個學習器更好、更穩定的預測性能。"三個臭皮匠,勝過一個諸葛亮"。

#21

★★★★

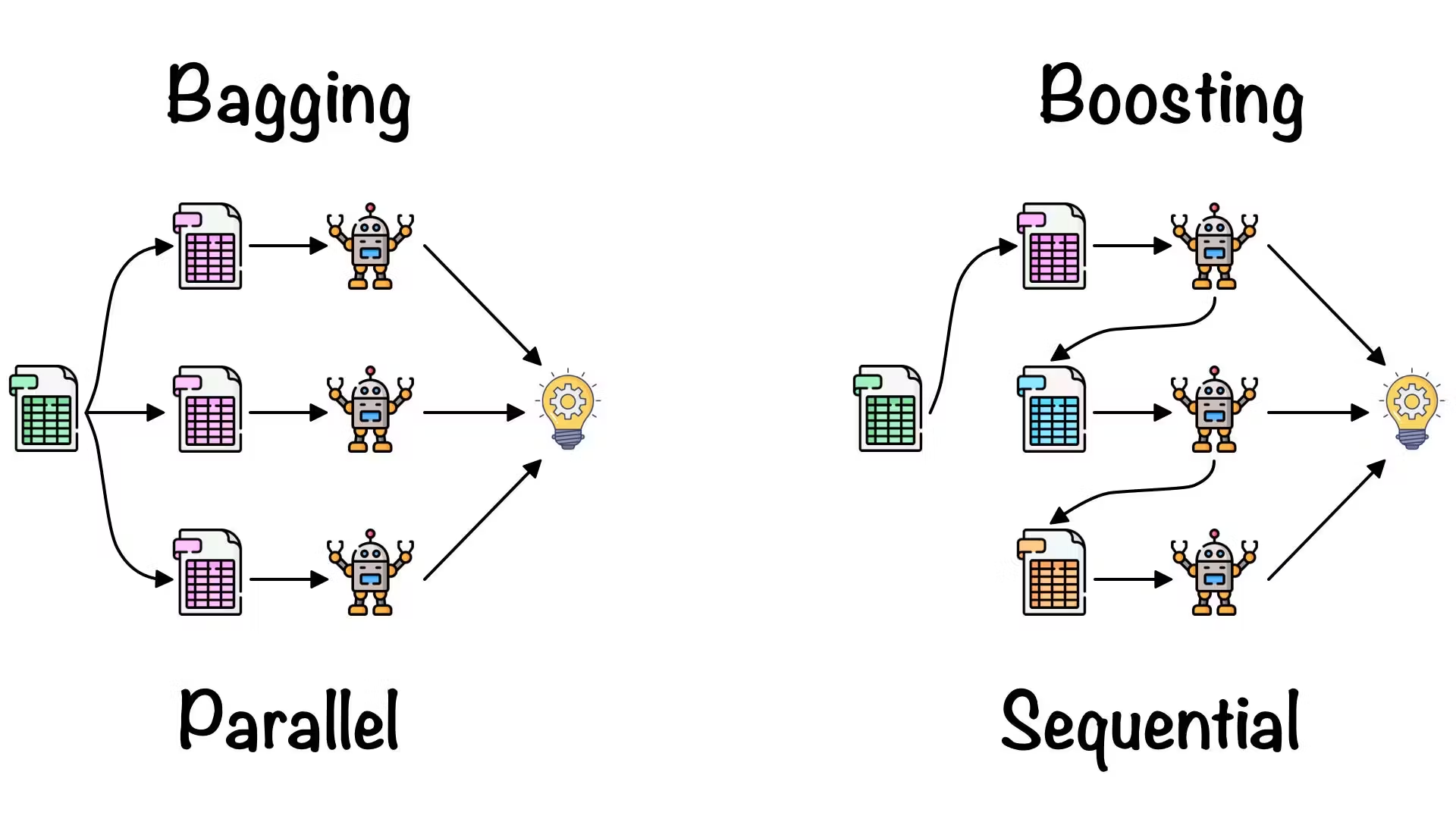

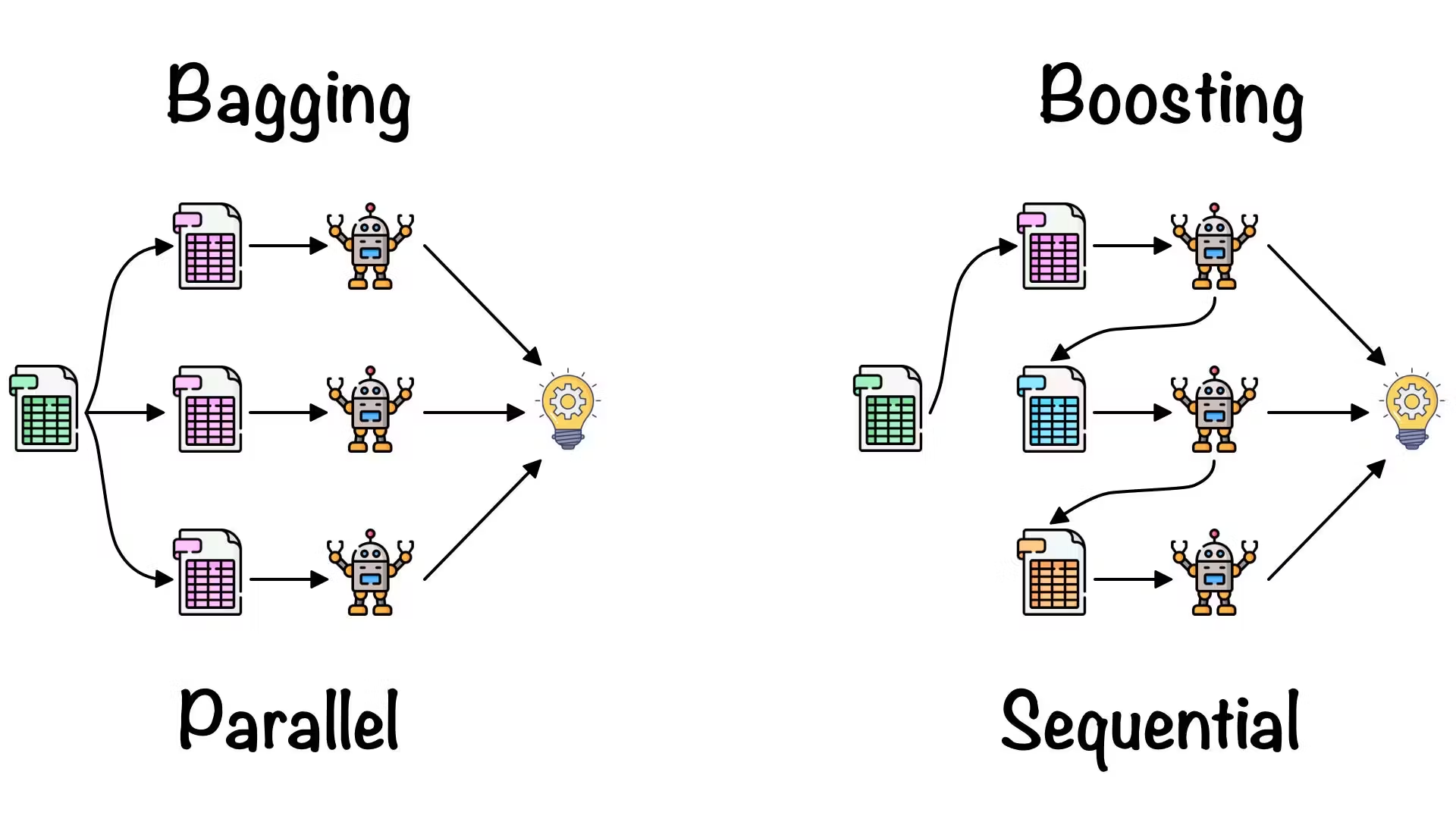

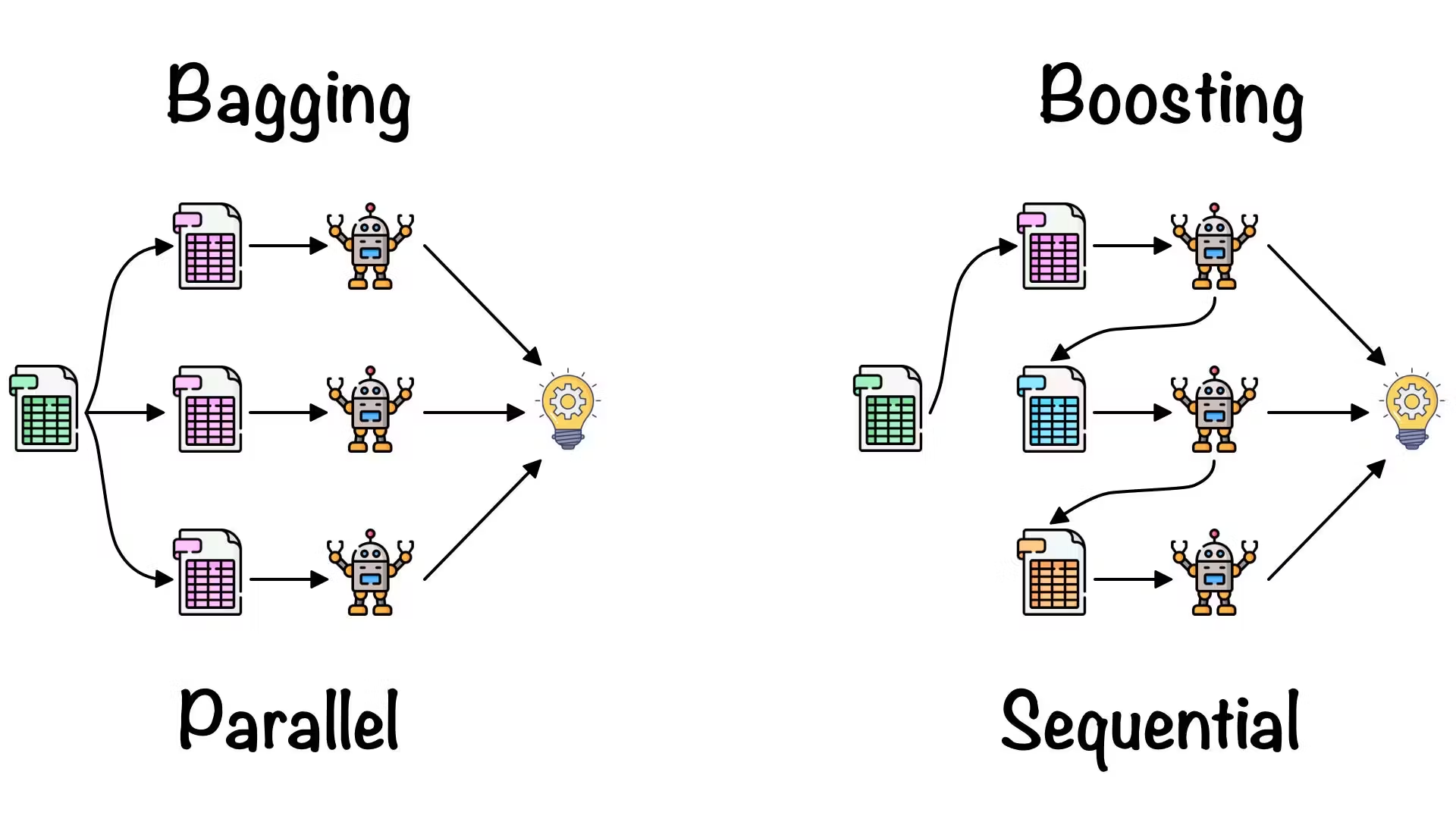

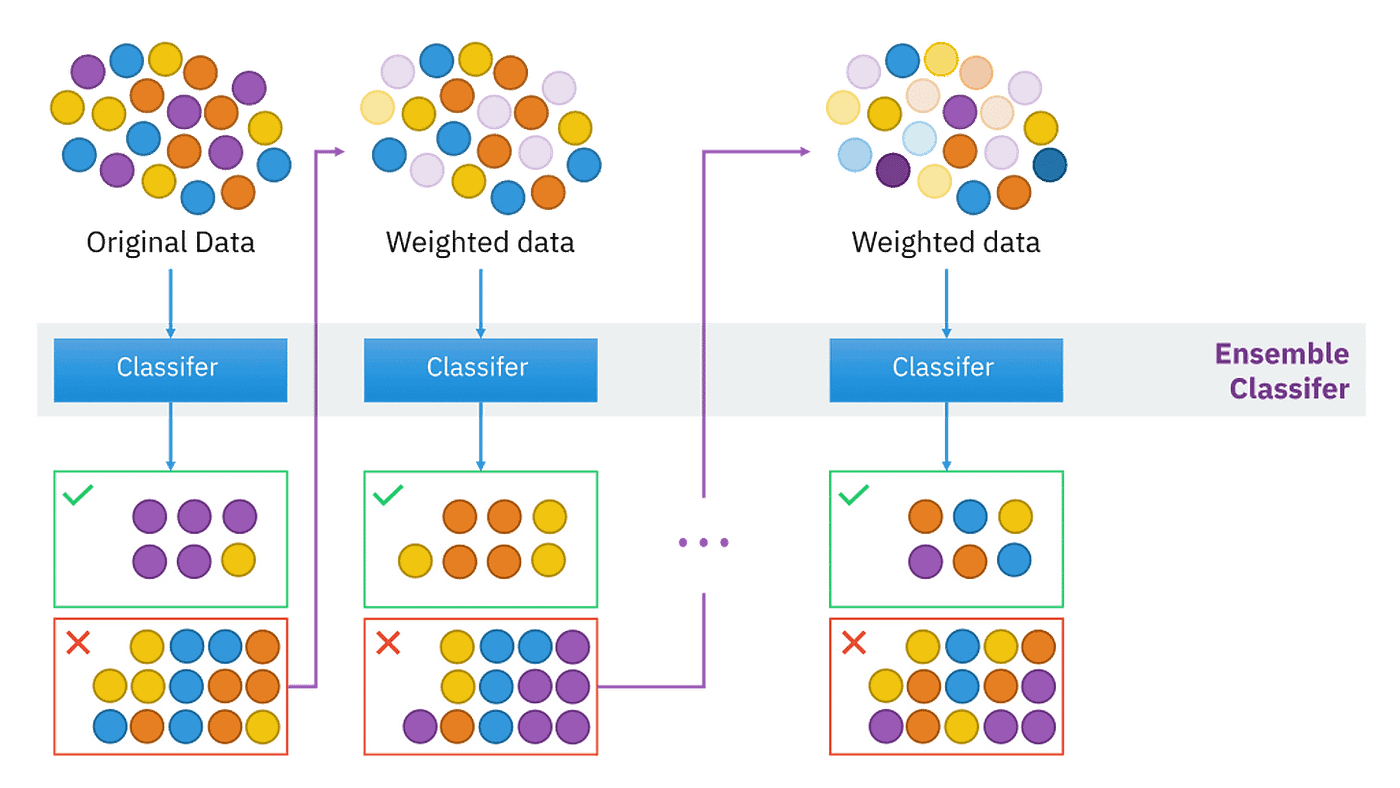

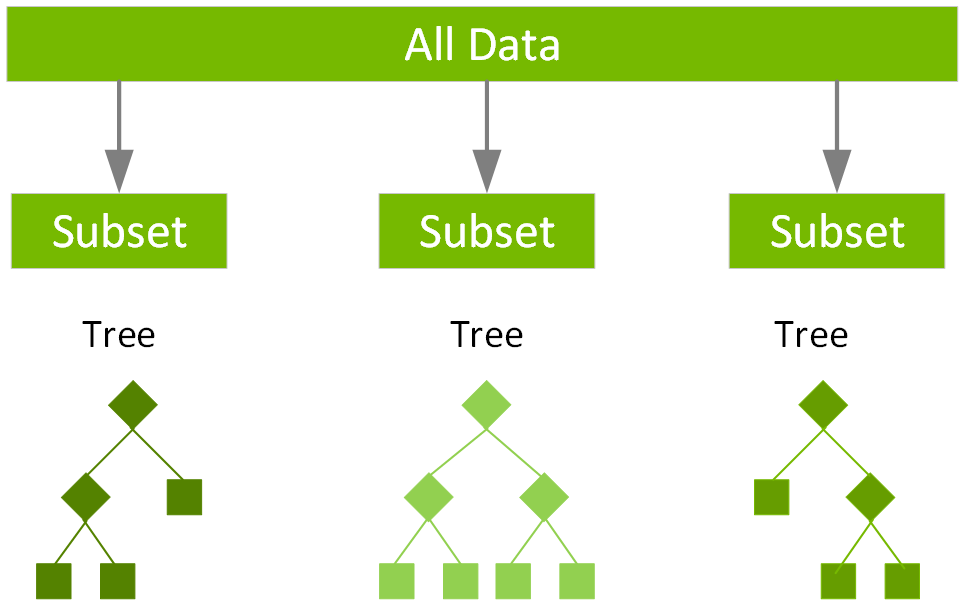

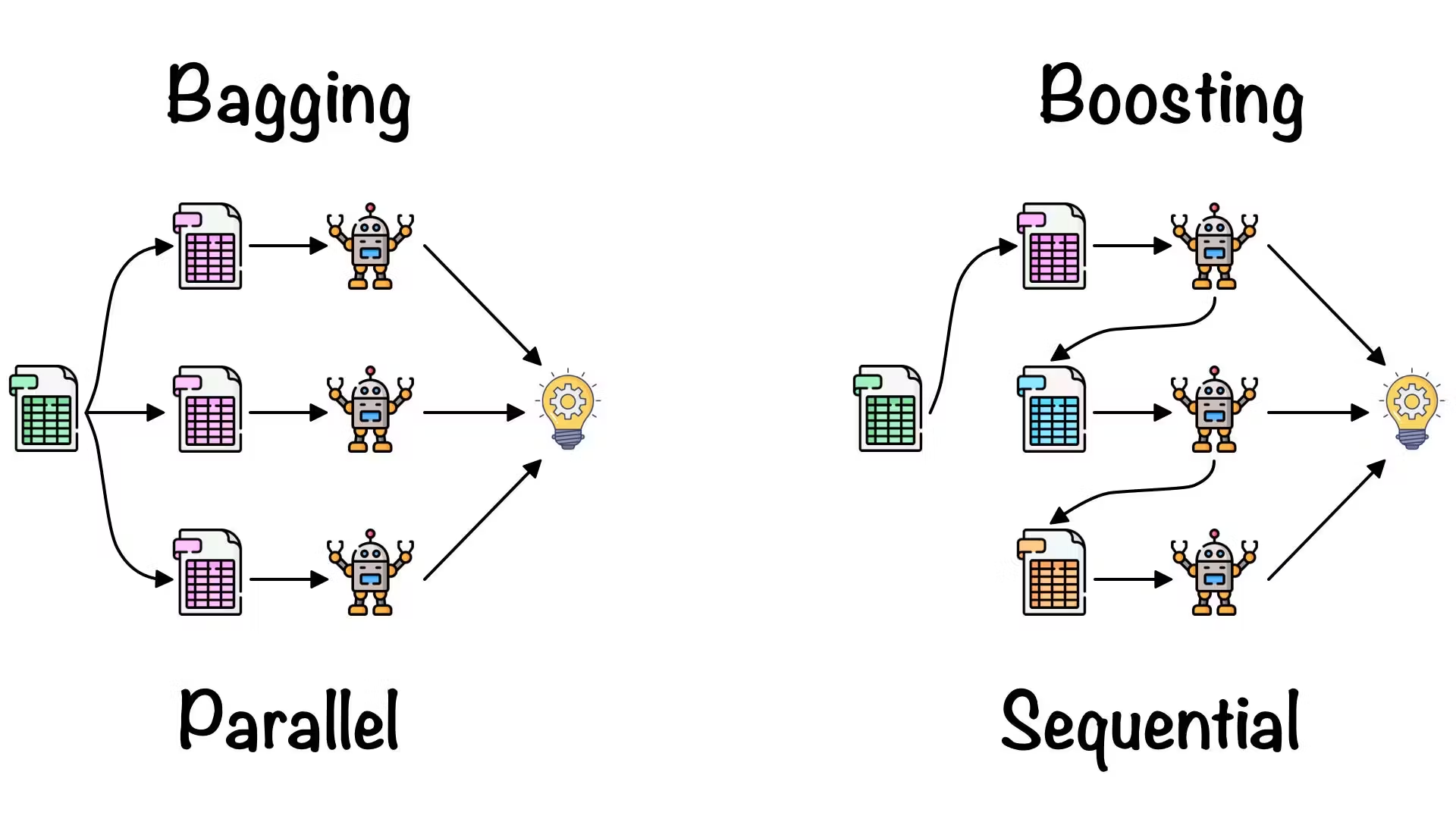

Bagging (Bootstrap Aggregating)

集成方法

Bagging 的主要思想:

- 從原始訓練集中進行自助抽樣 (Bootstrap Sampling,有放回抽樣) 產生多個不同的訓練子集。

- 在每個子集上獨立地訓練一個基學習器(通常是同種類型,如決策樹)。

- 將所有基學習器的預測結果進行聚合(分類問題用投票,迴歸問題用平均)。

#23

★★★★

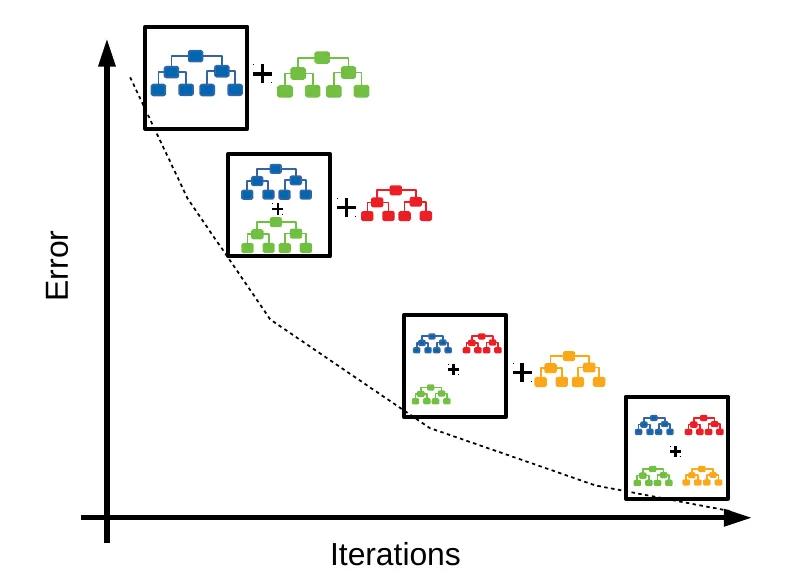

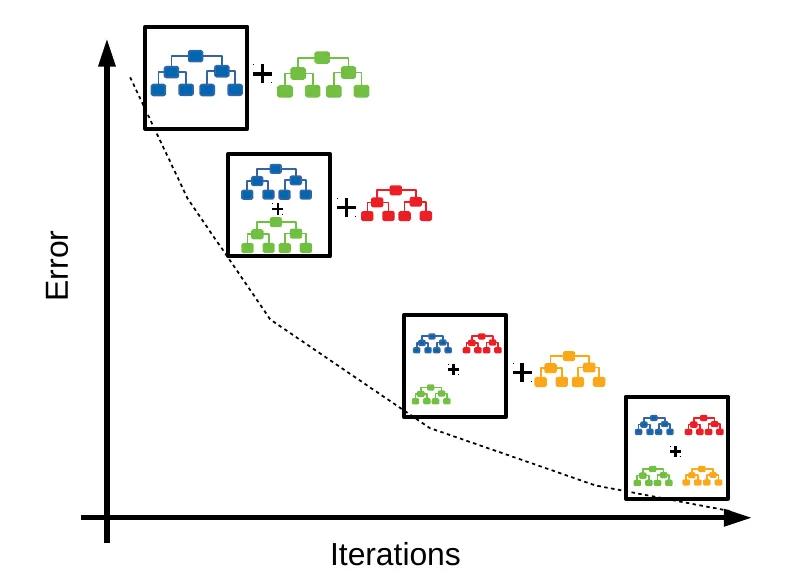

Boosting (提升)

集成方法

Boosting 的主要思想:

- 串行地訓練一系列基學習器(通常是弱學習器,如淺層決策樹)。

- 每個後續的學習器都更關注先前學習器預測錯誤的樣本(透過調整樣本權重或擬合殘差)。

- 最終將所有基學習器的預測結果進行加權組合。

#24

★★★★

AdaBoost (Adaptive Boosting)

Boosting 演算法

最早的 Boosting 演算法之一。它在每次迭代中提高被前一個弱學習器錯誤分類的樣本的權重,使得後續學習器更關注這些困難樣本。最終的預測是所有弱學習器的加權投票(權重基於弱學習器的性能)。

#25

★★★★★

梯度提升決策樹 (GBDT, Gradient Boosting Decision Tree)

Boosting 演算法

一種非常強大和流行的 Boosting 演算法。它在每次迭代中訓練一個新的基學習器(通常是決策樹)來擬合先前所有學習器預測結果的殘差(梯度)。

其改進版本如 XGBoost, LightGBM, CatBoost 在 GBDT 的基礎上進行了許多工程優化(如正則化、並行處理、缺失值處理等),在各種機器學習競賽和實際應用中表現非常出色。

其改進版本如 XGBoost, LightGBM, CatBoost 在 GBDT 的基礎上進行了許多工程優化(如正則化、並行處理、缺失值處理等),在各種機器學習競賽和實際應用中表現非常出色。

#26

★★

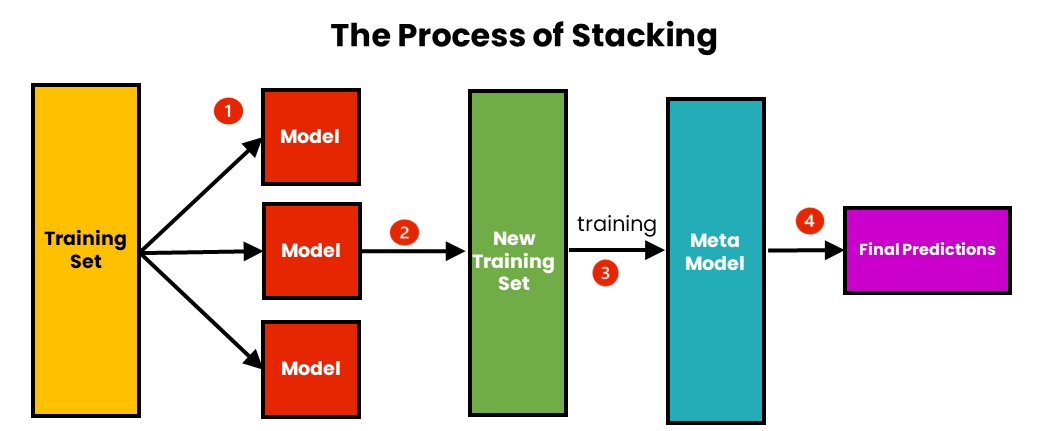

Stacking (堆疊泛化)

集成方法

Stacking 的主要思想:

- 訓練多個不同的第一層基學習器(也稱 Level-0 模型)。

- 使用這些基學習器的預測結果作為新的特徵。

- 訓練一個第二層元學習器(也稱 Level-1 模型)來學習如何最好地組合第一層模型的預測,以產生最終的預測結果。

#22

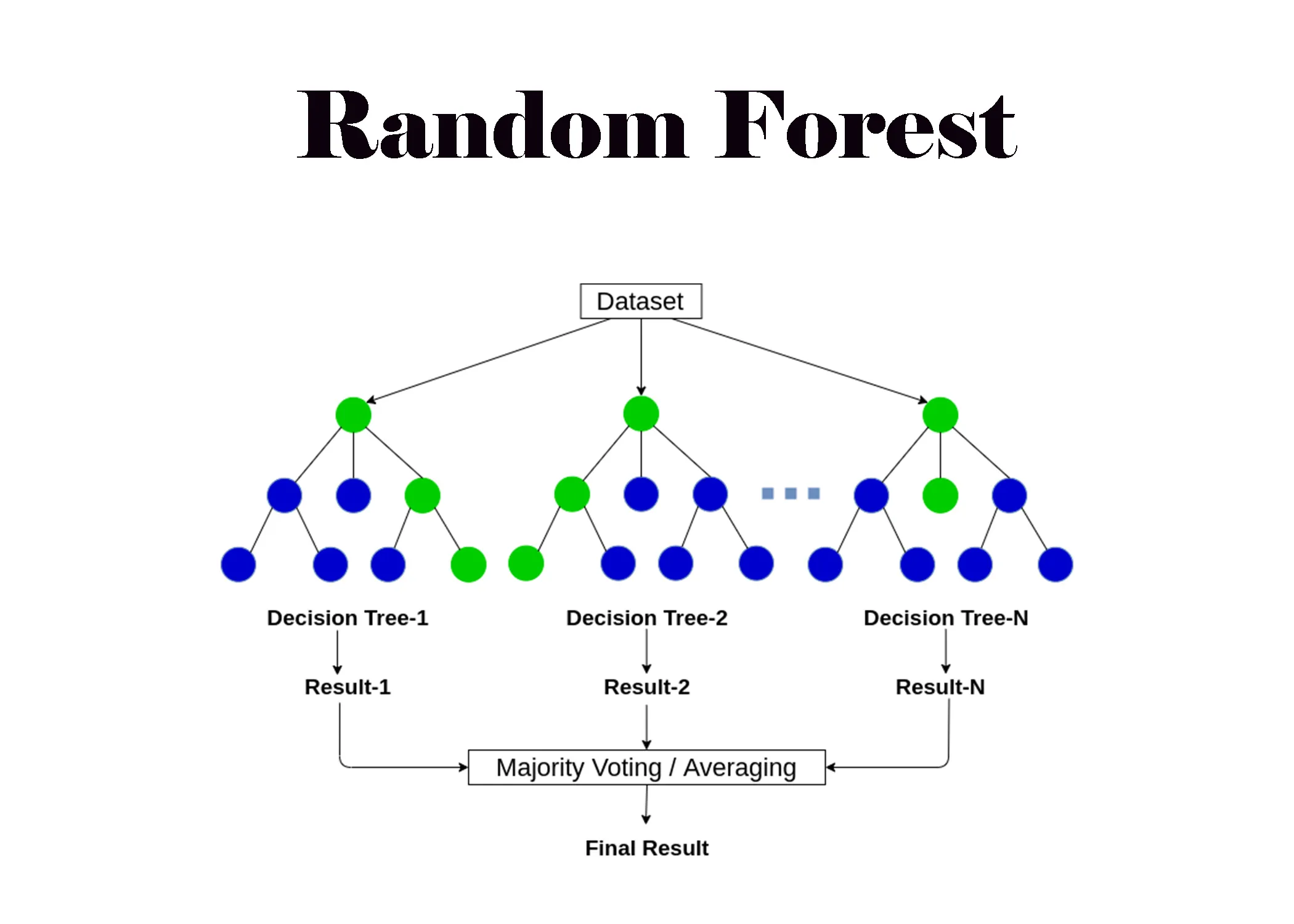

★★★★★

隨機森林 (RF, Random Forest) (參考樣題 Q22 選項)

集成演算法

隨機森林是 Bagging 的一種擴展和改進,其基學習器是決策樹。除了使用 Bootstrap 抽樣樣本外,它在構建每棵樹的每個節點時,還會隨機選擇一部分特徵來進行分裂判斷,進一步增加了模型的多樣性,通常能獲得比 Bagging 更好的性能。是非常常用和強大的集成算法。

#27

★★★★

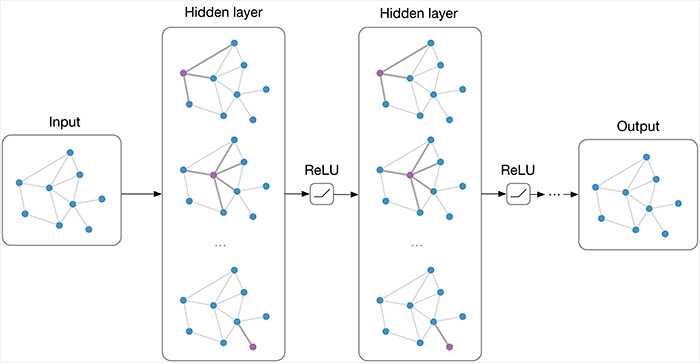

深度學習演算法類型概覽

主要類型 (連接 L23203)

常見的深度學習演算法(架構)包括:

- 多層感知器 (MLP): 基礎全連接網路。

- 卷積神經網路 (CNN): 擅長圖像處理。

- 循環神經網路 (RNN) 及其變體 (LSTM, GRU): 擅長序列數據。

- Transformer: 基於自注意力,在 NLP 領域佔主導。

- 生成對抗網路 (GAN): 用於生成數據。

- 自編碼器 (AE): 用於降維、特徵學習、生成。

#28

★★★★★

演算法選擇:考慮問題類型 (分類/迴歸/分群等)

核心考量

必須根據問題的性質選擇合適類型的演算法。例如,不能用分群算法 (K-Means) 來解決迴歸問題(預測銷售額),也不能用迴歸算法(線性迴歸)來直接解決圖像分類問題。(參考樣題 Q8)

#29

★★★★

演算法選擇:考慮數據特性 (大小/維度/類型/品質)

核心考量

數據量小可能不適合複雜的深度學習模型;高維數據可能需要 SVM 或 Lasso;圖像數據常用 CNN;文本數據常用 RNN 或 Transformer;數據品質差可能需要更穩健的算法或加強預處理。

#30

★★★★

演算法選擇:考慮性能要求 (準確性/速度)

核心考量

預期達到的準確性水平是多少?對訓練速度和預測速度有何要求?需要高精度可能選擇集成方法或深度學習;需要快速預測可能選擇線性模型或簡單樹模型。

#31

★★★★

演算法選擇:考慮可解釋性

核心考量

應用場景是否需要理解模型的決策過程?線性模型、決策樹相對易於解釋;深度學習、集成模型則較難解釋(黑盒子)。

#32

★★★

演算法選擇:考慮計算資源

核心考量

是否有足夠的 CPU, GPU, 記憶體來訓練和部署所選模型?複雜模型(如深度學習)通常需要更多資源。

#33

★★

演算法選擇:考慮易用性與維護性

核心考量

團隊是否熟悉該演算法?是否有成熟的函式庫支持?模型部署和後續維護的難度如何?

#34

★★★★

模型評估的重要性 (連接 L23303)

核心目的

需要使用合適的評估指標和獨立的測試數據來客觀評估演算法(模型)的性能,以判斷其是否滿足需求並比較不同演算法的優劣。

#35

★★★

常見評估指標:分類 (準確率, 精確率, 召回率, F1, AUC)

指標簡介

衡量分類模型性能的關鍵指標,需根據業務需求和數據特性(如類別不平衡)選擇。(詳見 L23303)

#36

★★★

常見評估指標:迴歸 (MSE, RMSE, MAE, R²)

指標簡介

衡量迴歸模型預測誤差或擬合程度的關鍵指標。(詳見 L23303, 參考樣題 Q14)

#37

★

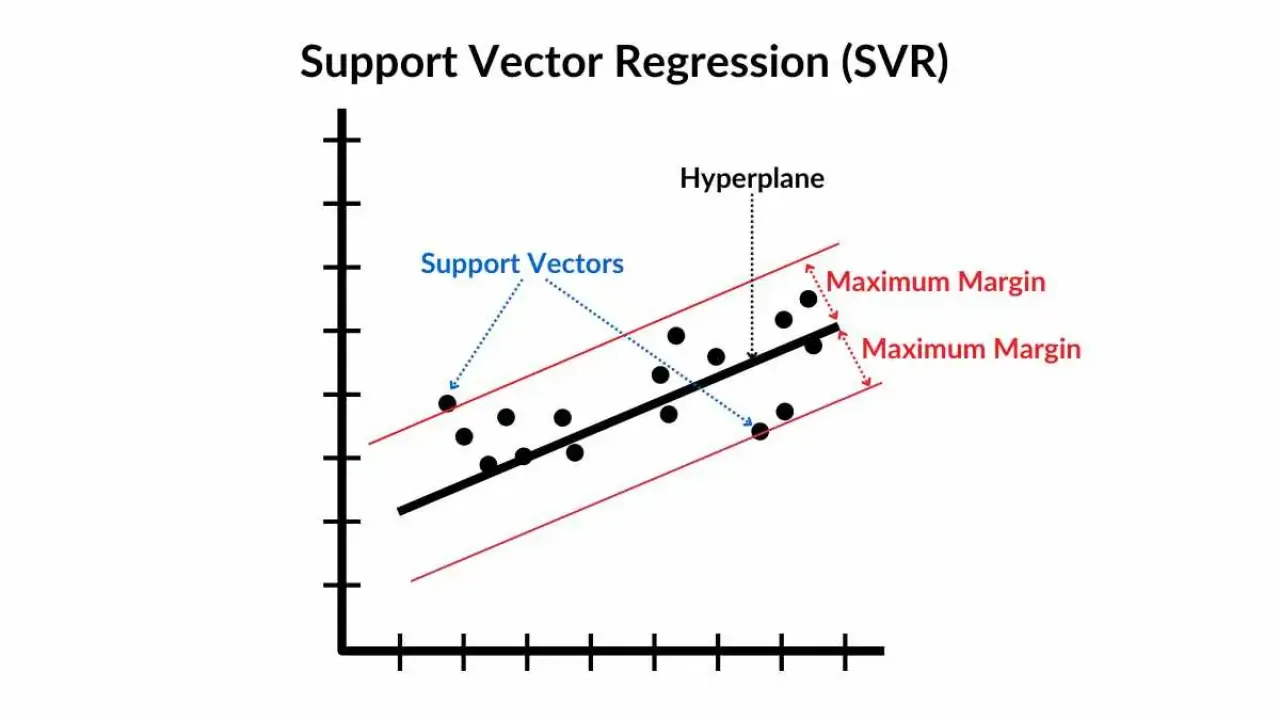

支持向量迴歸 (SVR, Support Vector Regression)

迴歸演算法

將 SVM 的思想應用於迴歸問題。目標是找到一個函數,使得盡可能多的樣本點落在函數的 ε-不敏感帶內,同時最小化邊界外的誤差。

#38

★

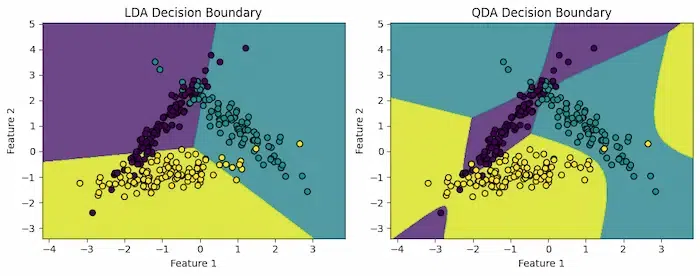

判別分析 (DA, Discriminant Analysis) - LDA, Linear Discriminant Analysis, QDA, Quadratic Discriminant Analysis

分類演算法

線性判別分析 (LDA, Linear Discriminant Analysis) 和二次判別分析 (QDA, Quadratic Discriminant Analysis) 是基於統計假設(數據服從高斯分佈)的分類方法。LDA 假設各類別協方差矩陣相同,產生線性邊界;QDA 允許不同,產生二次邊界。

#39

★

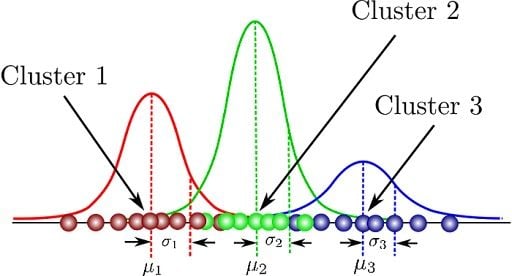

高斯混合模型 (GMM, Gaussian Mixture Model)

分群演算法

一種基於機率模型的分群方法。假設數據由多個高斯分佈混合而成,透過期望最大化 (EM) 演算法來估計每個群集的參數(均值、協方差)以及每個點屬於各群集的機率。可以處理非球狀群集。

#40

★

Q-Learning

RL 演算法

一種經典的無模型、基於價值的強化學習演算法。它學習一個 Q-函數(動作價值函數),估計在特定狀態下執行特定動作的期望回報,然後根據 Q 值選擇動作。

#41

★★

XGBoost (Extreme Gradient Boosting)

GBDT (Gradient Boosting Decision Tree) 實現

GBDT (Gradient Boosting Decision Tree) 的一種高效、可擴展的實現。加入了正則化項(防止過擬合)、支援並行處理、內建缺失值處理等,在許多競賽和應用中表現優異。

#42

★★

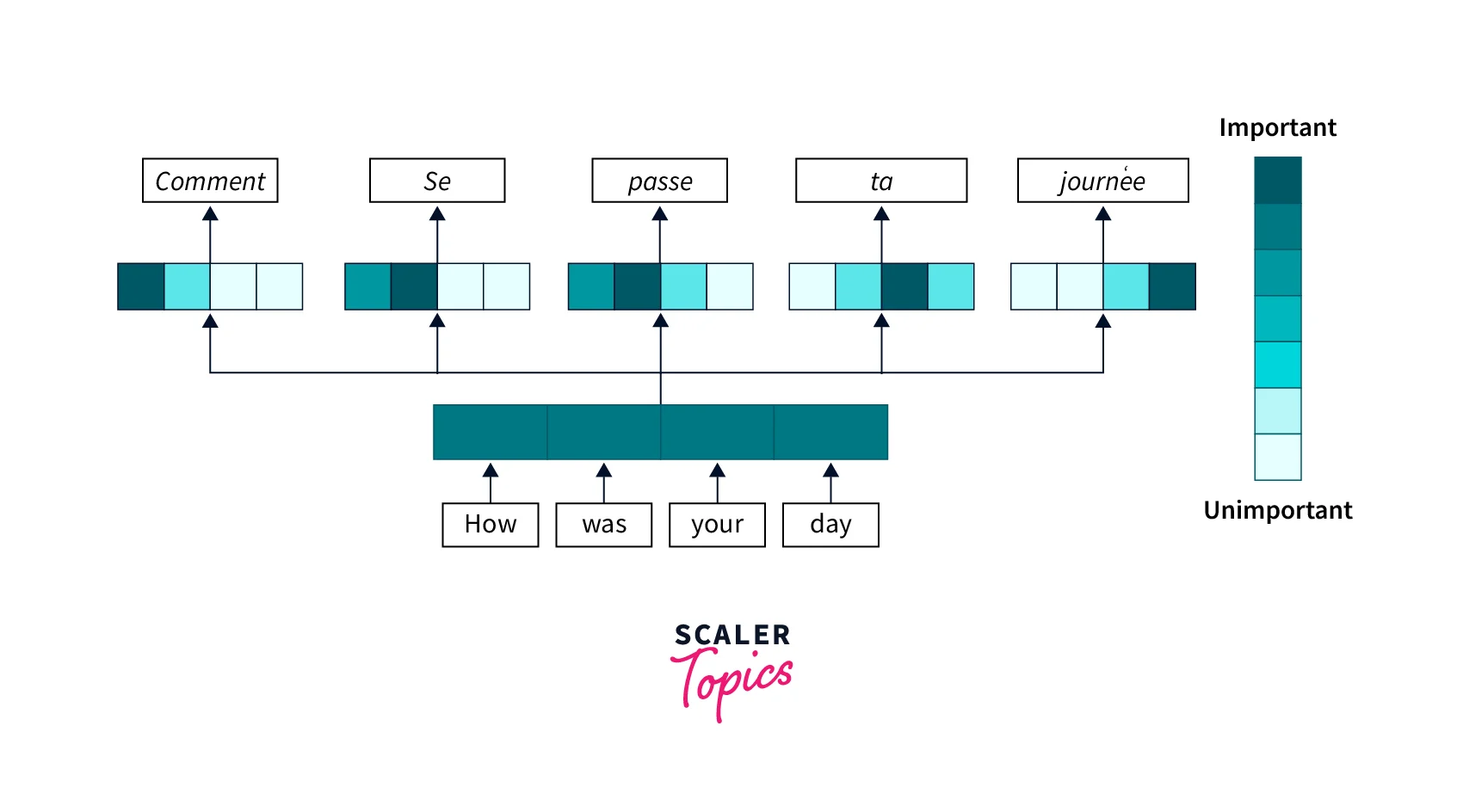

注意力機制 (Attention Mechanism)

深度學習組件

允許模型在處理輸入序列(或圖像)時,動態地將「注意力」集中在與當前任務最相關的部分。最初用於RNN,後來成為 Transformer 的核心。

#43

★

演算法的穩健性 (Robustness)

選擇考量

指演算法對輸入數據中的噪聲、異常值或分佈變化的敏感程度。某些算法(如基於樹的集成模型)通常比其他算法(如線性模型、KNN)更具穩健性。

#44

★★

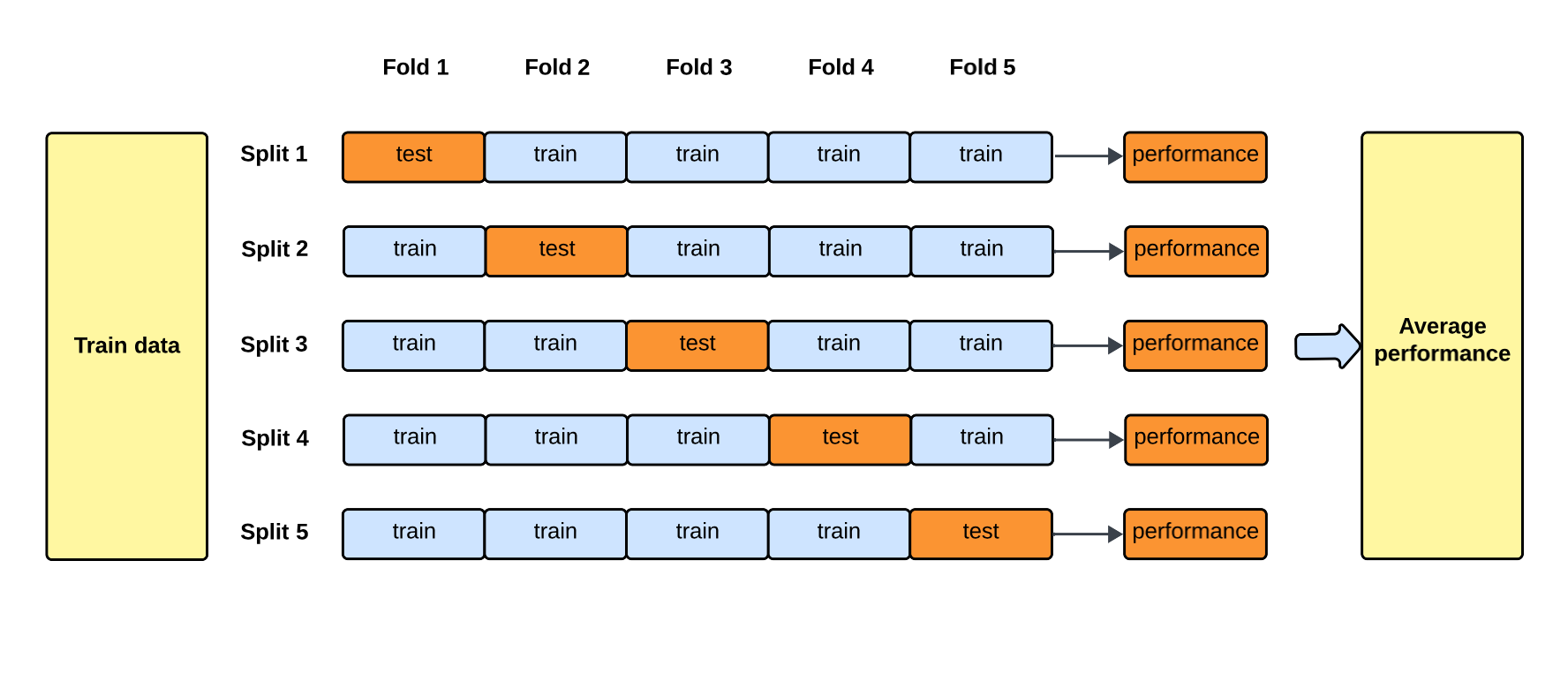

交叉驗證 (Cross-Validation) 在評估中的應用

評估方法 (參考樣題 Q9)

交叉驗證提供了一種比單次劃分訓練/驗證集更可靠的模型性能評估方法,尤其是在數據量有限時。它有助於獲得更穩定的性能估計並減少對特定劃分的依賴。樣題 Q9 確認其目的之一是減少過擬合風險(透過更可靠的評估)。

#45

★

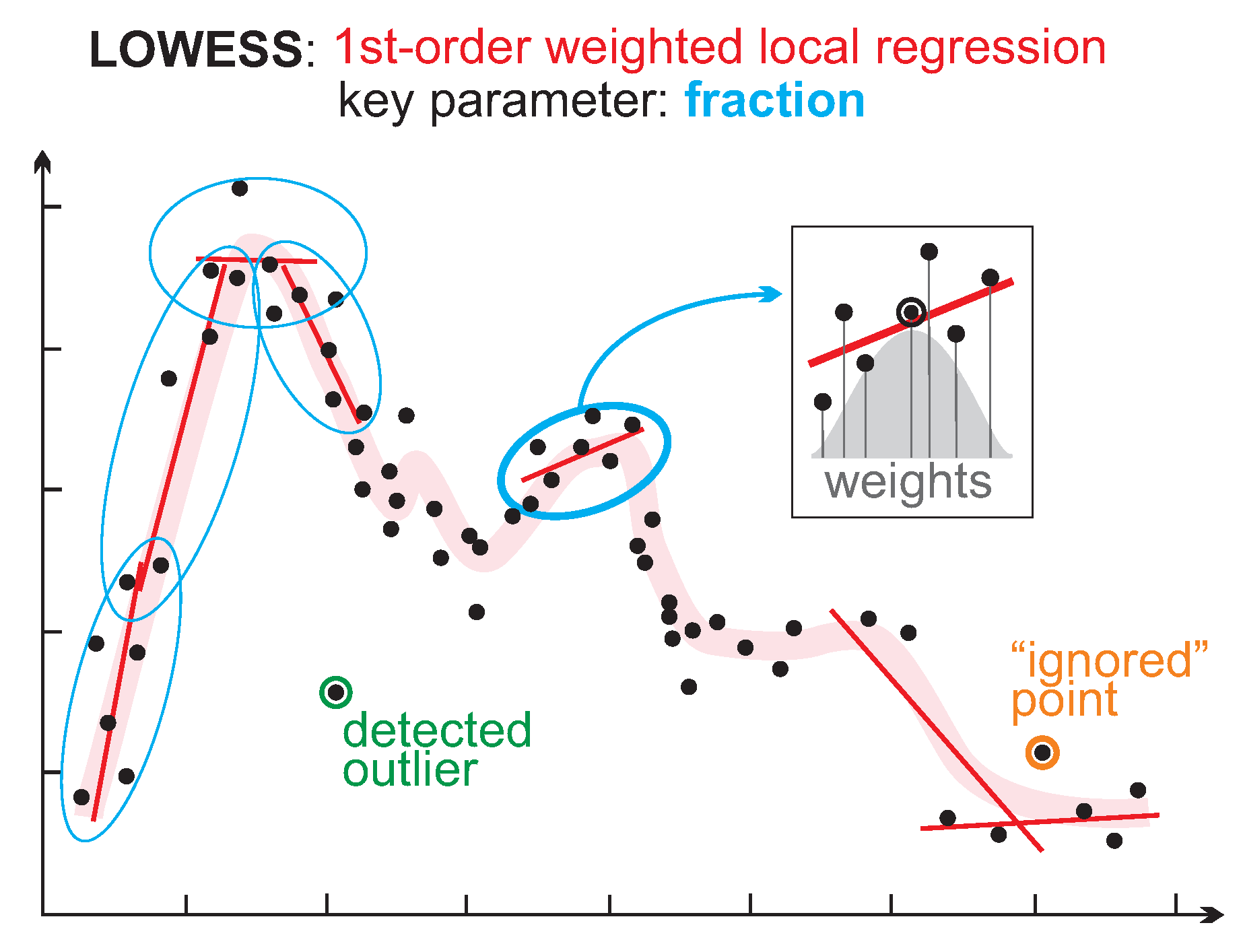

局部加權迴歸 (Locally Weighted Regression, LOWESS/LOESS)

迴歸演算法

一種非參數迴歸方法。預測某一點的值時,只使用該點附近的數據點進行加權線性迴歸,距離越近的點權重越高。能擬合複雜的局部模式。

#46

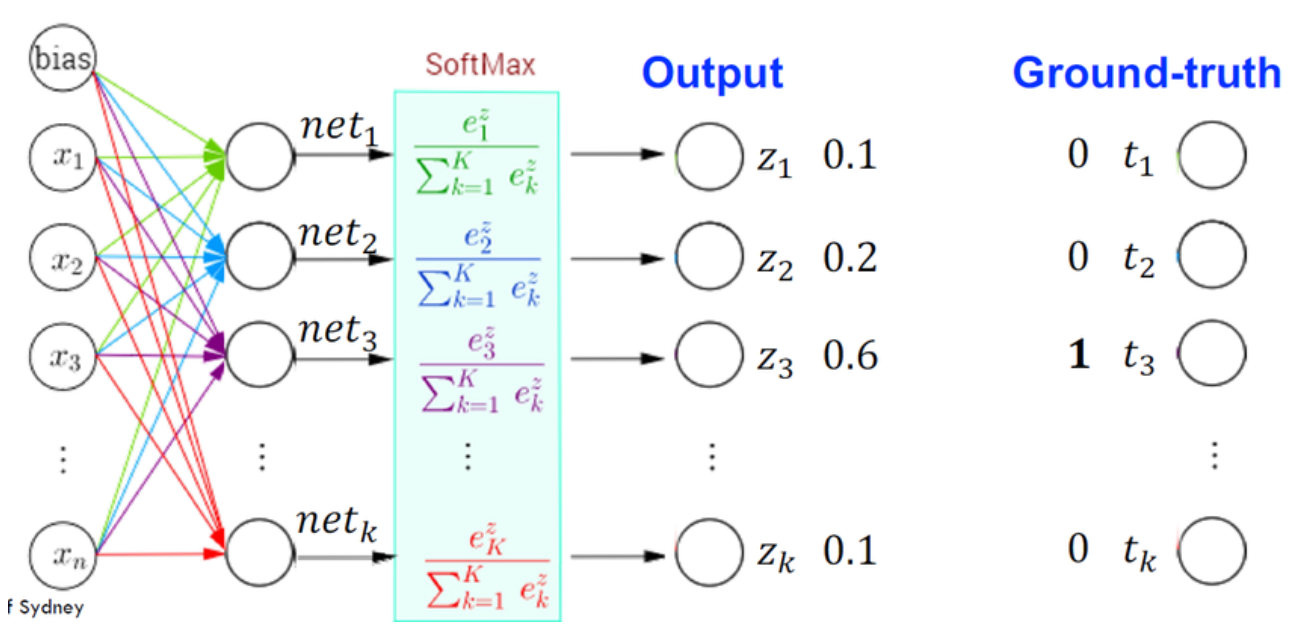

★

神經網路 (用於分類)

分類應用

透過在輸出層使用 Sigmoid (二分類) 或 Softmax (多分類) 激活函數,並配合交叉熵損失,神經網路可以非常有效地解決複雜的分類問題。

#47

★

譜分群 (Spectral Clustering)

分群演算法

一種基於圖論的分群方法。它先將數據點間的相似性轉換為圖,然後利用圖拉普拉斯矩陣的譜(特徵值/特徵向量)進行降維,最後在降維後的空間中進行分群(如 K-Means)。擅長處理非凸形狀的群集。

#48

★

深度強化學習 (DRL, Deep Reinforcement Learning)

RL 結合 DL

將深度學習(特別是深度神經網路)與強化學習相結合。使用神經網路來近似價值函數或策略,使其能夠處理高維度的狀態空間(如從像素學習玩遊戲)。代表性算法如 DQN (Deep Q-Network)。

#49

★

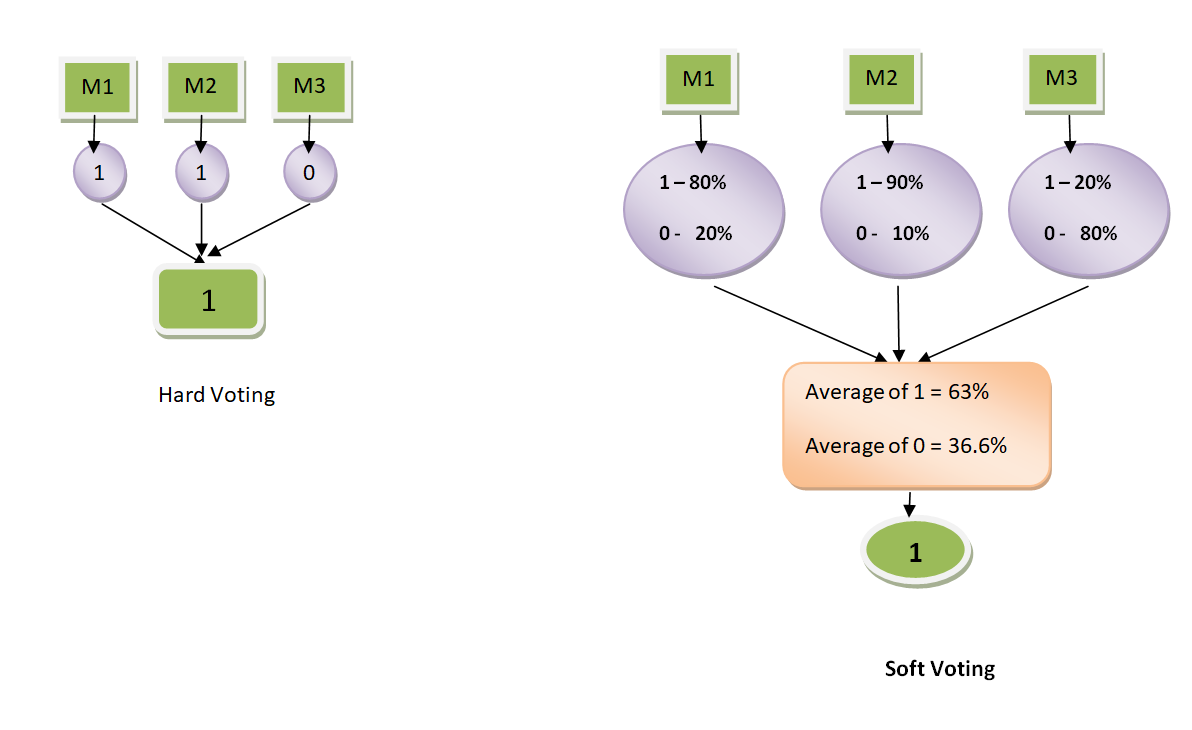

投票分類器/迴歸器 (Voting Classifier/Regressor)

集成方法

一種簡單的集成方法,直接結合多個不同模型的預測結果。分類問題通常使用硬投票(預測最多的類別)或軟投票(基於預測機率平均);迴歸問題使用預測值的平均。

#50

★

圖神經網路 (GNN, Graph Neural Network)

深度學習架構

用於處理圖結構數據的深度學習演算法。透過聚合鄰居節點的資訊來更新節點表示。

#51

★

無免費午餐定理的啟示

選擇原則

強調了沒有 universally 最好的演算法,必須根據具體任務和數據實驗和比較不同的演算法。

#52

★

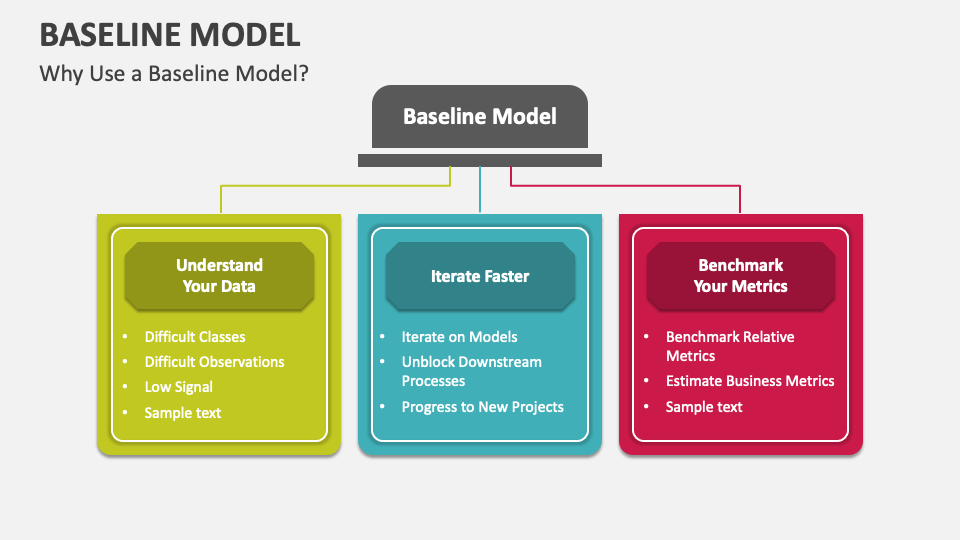

基準模型 (Baseline Model) 的重要性

評估基準

建立一個簡單的基準模型有助於量化複雜模型的實際性能提升。如果複雜模型的性能僅略好於或甚至不如簡單基準,則可能需要重新考慮。

#53

★

時間序列預測模型 (ARIMA, Prophet)

迴歸應用

傳統統計模型 ARIMA 或 Facebook 開發的 Prophet 常用於具有趨勢和季節性的時間序列數據預測。

#54

★

One-Class SVM

異常檢測

SVM 的一種變體,用於異常檢測 (Anomaly Detection)。它學習正常數據的邊界,將遠離邊界的點識別為異常。

#55

★

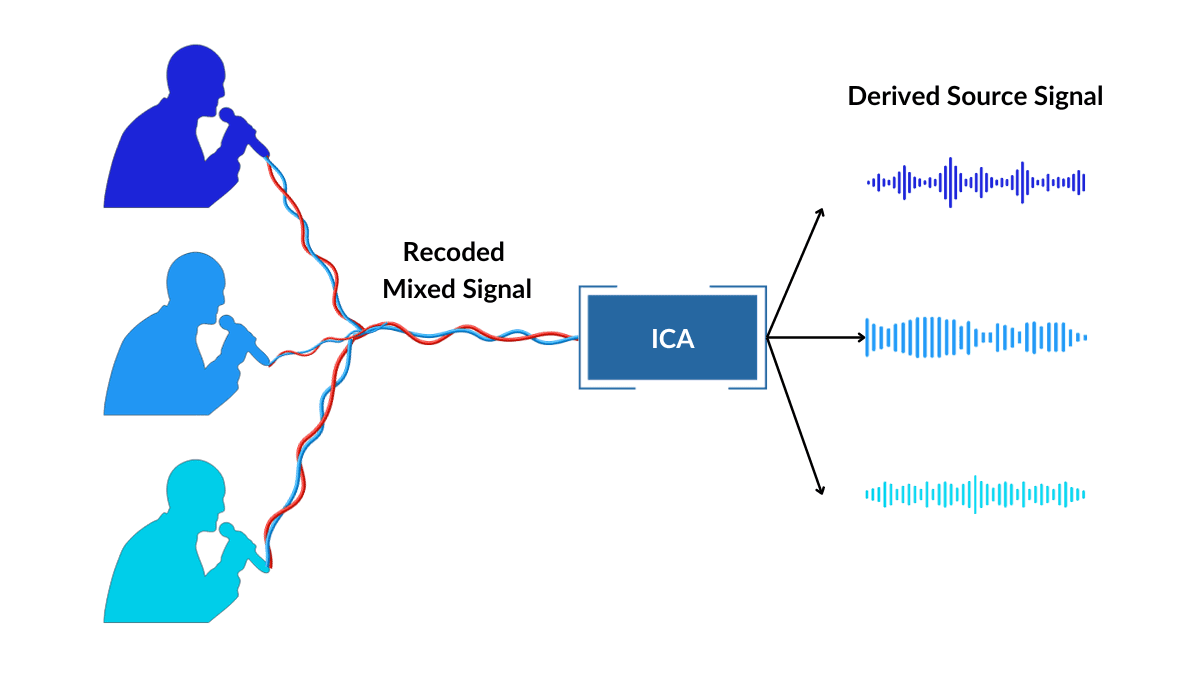

獨立成分分析 (ICA, Independent Component Analysis)

降維/信號分離

一種非監督式學習技術,旨在將混合信號分解為統計上獨立的源信號。常用於盲源分離 (Blind Source Separation)。

#56

★

集成學習中的多樣性

關鍵因素

集成學習成功的關鍵在於基學習器之間的多樣性(即它們的預測錯誤是不同的)。Bagging 和隨機森林透過抽樣來增加多樣性;Boosting 透過關注不同樣本來增加多樣性。

#57

★

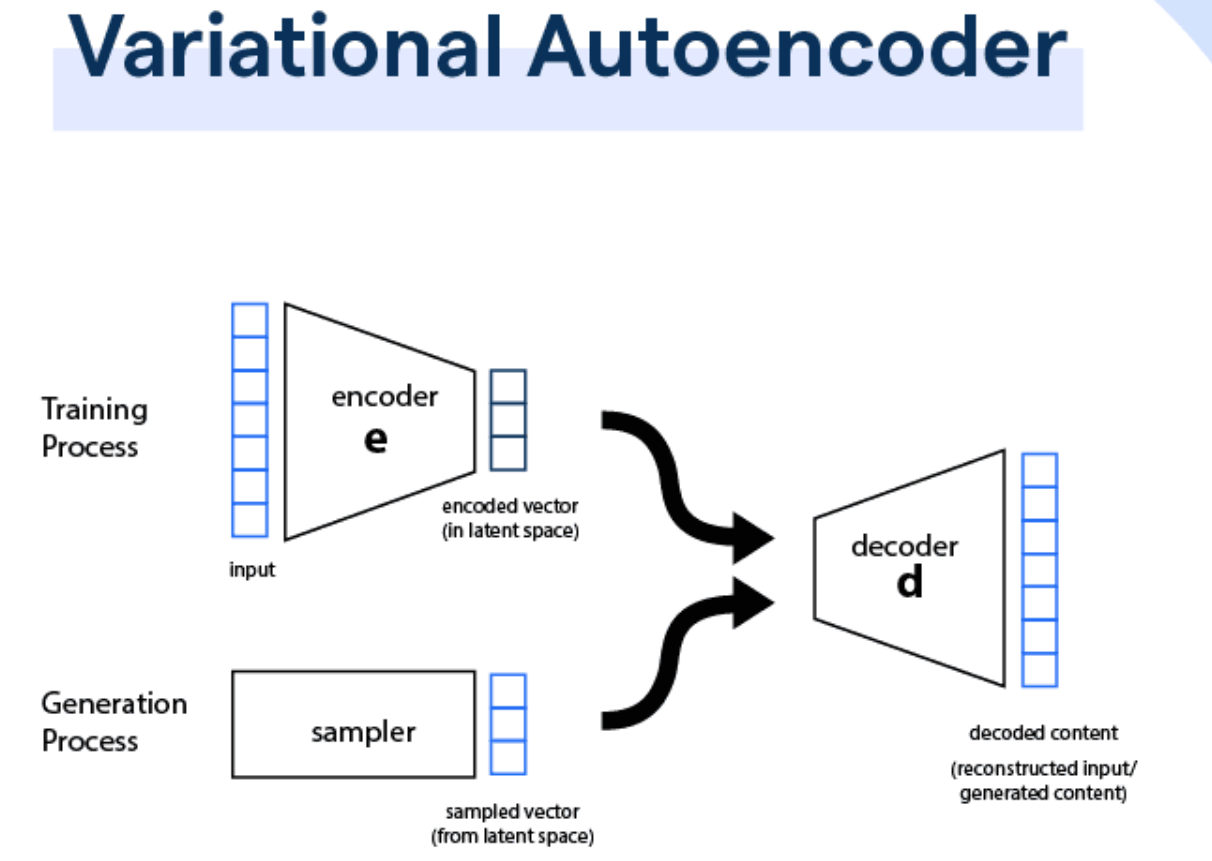

變分自編碼器 (VAE, Variational Autoencoder)

生成模型

自編碼器的一種變體,屬於深度生成模型。它學習數據的潛在機率分佈,使其能夠生成新的、類似於訓練數據的樣本。

#58

★

參數數量與模型複雜度

關係

通常,模型的可學習參數數量是衡量其複雜度的一個指標。參數越多,模型容量越大,但也越容易過擬合。

#59

★

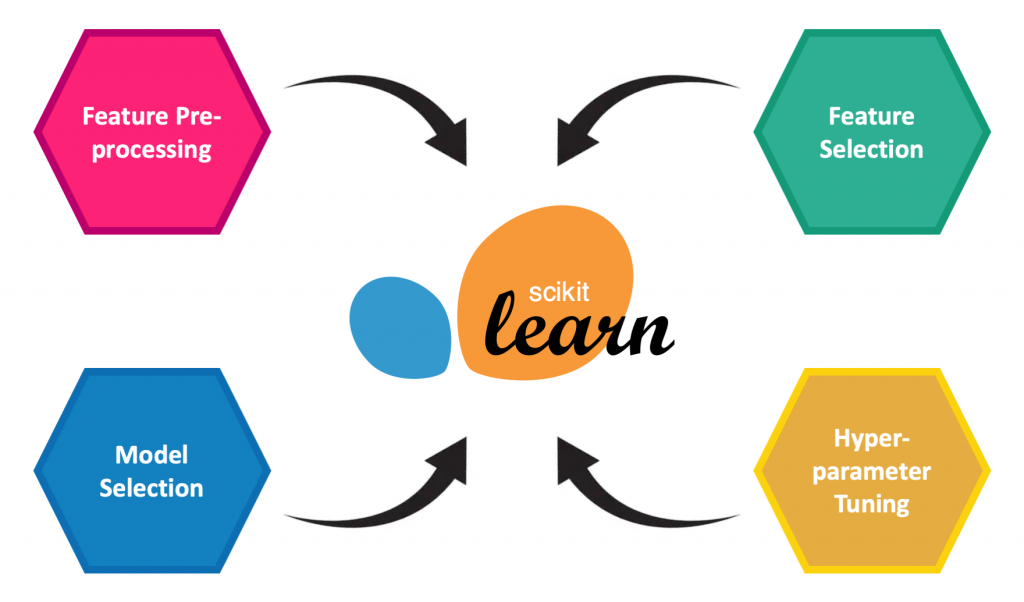

評估指標的計算庫 (Scikit-learn)

工具

像 Scikit-learn 這樣的 Python 庫提供了計算各種標準評估指標的現成函數,方便開發者使用。

#60

★

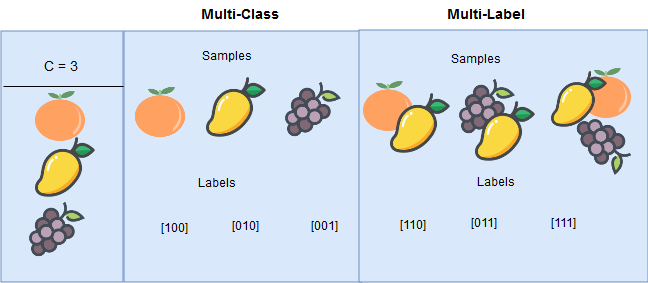

多標籤分類 (Multi-label Classification)

分類變體

每個樣本可以同時屬於多個類別的分類問題(與每個樣本只屬於一個類別的多類別分類不同)。需要使用特定的演算法或策略(如二元關聯法)來處理。

沒有找到符合條件的重點。

↑