iPAS AI應用規劃師 經典題庫

L22402 大數據在鑑別式AI中的應用

出題方向

1

基礎概念與大數據特性

2

大數據前處理與特徵工程

3

適用於大數據的鑑別式模型

4

分散式訓練與計算框架

5

模型評估與挑戰

6

鑑別式AI在大數據應用案例

7

資料品質與可解釋性

8

工具平台與未來趨勢

#1

★★★★★

在人工智慧領域中,鑑別式模型(Discriminative

Model)的主要目標是什麼?

答案解析

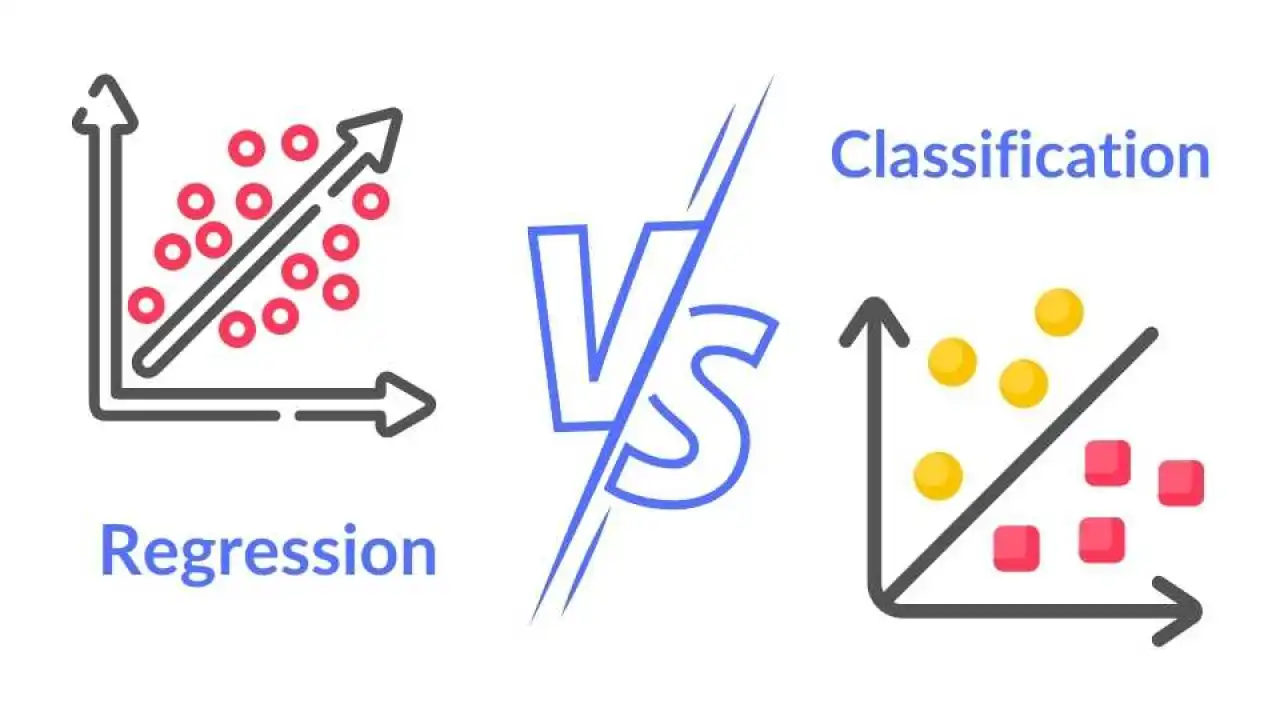

鑑別式模型專注於學習不同類別之間的區別或預測特定輸出。它們通常直接模擬 P(Y|X),即在給定輸入 X

的情況下,預測輸出 Y 的機率,或者直接學習一個函數將輸入映射到輸出(如分類邊界)。選項A和C描述的是生成式模型(Generative

Model)的目標。選項D描述的是非監督式學習(如分群)的目標。常見的鑑別式模型包括邏輯迴歸、支持向量機(SVM)、決策樹、以及用於分類任務的神經網路。

#2

★★★★

大數據的「多樣性」(Variety)特性對鑑別式AI模型訓練帶來的主要挑戰是什麼?

答案解析

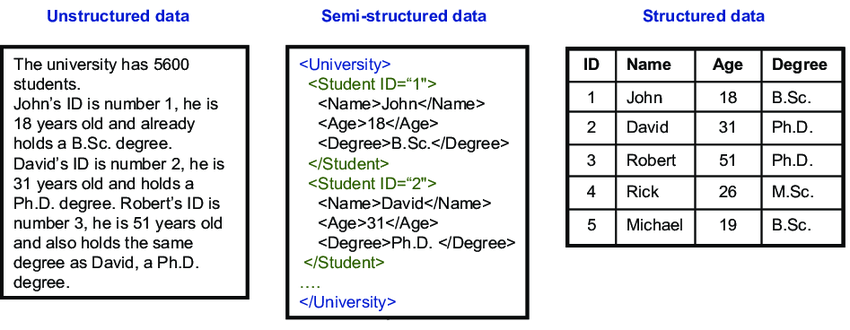

大數據的 Variety

特性指的是數據來源和格式的多樣化,例如結構化的資料庫表格、半結構化的 JSON/XML 檔案、以及非結構化的文字、圖像、聲音、影片等。鑑別式模型通常需要數值化的特徵輸入,因此處理和整合這些異構資料,將其轉換為模型可用的統一格式,是 Variety 帶來的核心挑戰。選項A主要關聯 Volume(容量),選項B關聯 Velocity(速度),選項D關聯 Veracity(真實性)。

#3

★★★★

在處理用於鑑別式模型訓練的大數據時,特徵縮放(Feature Scaling)的主要目的是什麼?

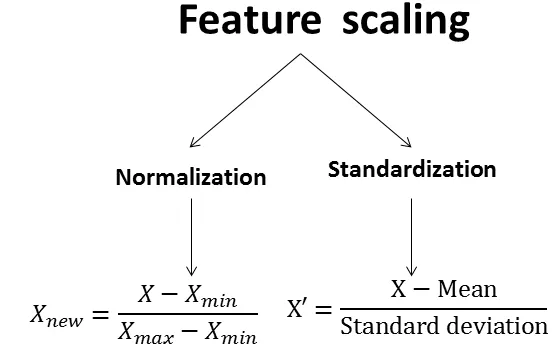

答案解析

許多鑑別式模型(如基於距離的SVM、邏輯迴歸、梯度下降優化的神經網路等)對輸入特徵的尺度(Scale)很敏感。如果不同特徵的數值範圍差異很大(例如,年齡範圍是幾十,收入範圍是幾十萬),數值範圍較大的特徵可能會不成比例地主導模型的學習過程。特徵縮放(如標準化 Standardization 或歸一化

Normalization)將所有特徵縮放到相似的範圍,避免這種偏差,有助於模型更快、更穩定地收斂。選項A是特徵選擇或降維的目的。選項C是類別編碼的目的。選項D與目的相反。

#4

★★★★★

下列哪種鑑別式模型特別適合處理具有非線性關係且資料量龐大的分類問題?

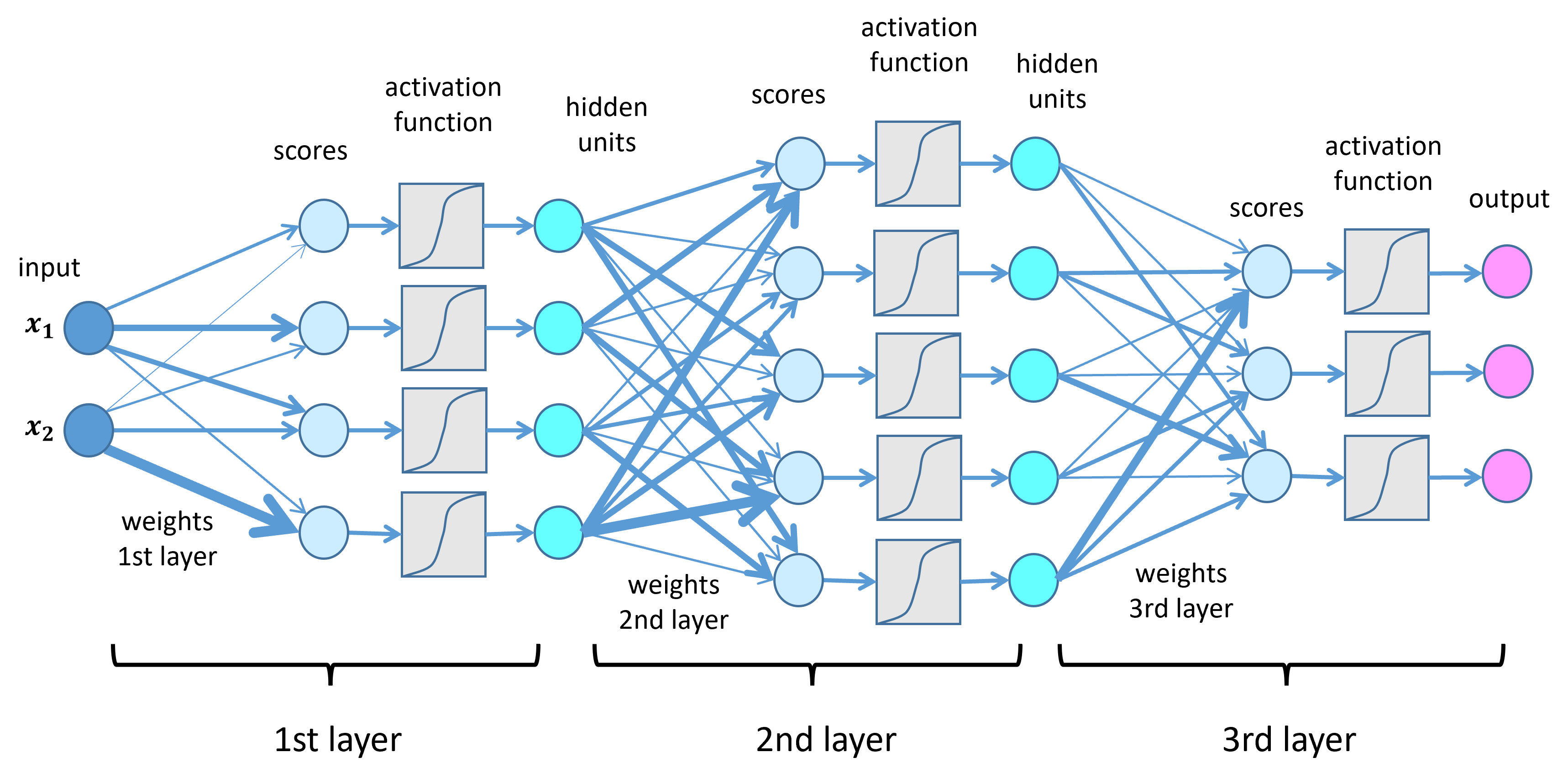

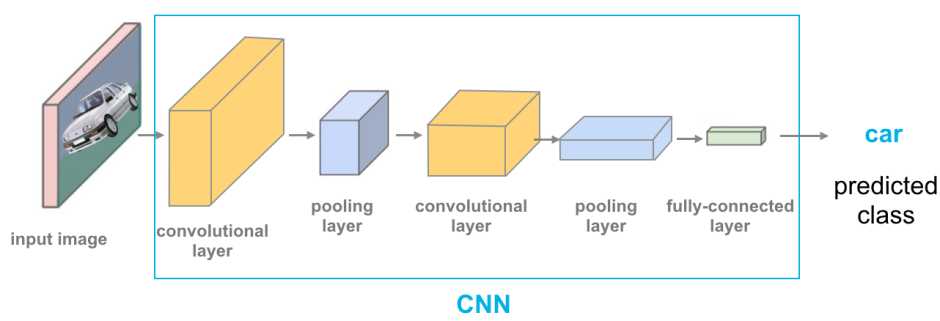

答案解析

深度神經網路(DNN)通過其多層非線性轉換,能夠學習非常複雜的非線性模式,非常適合處理複雜的分類或迴歸問題。同時,DNN 可以利用大數據進行訓練,透過大量資料學習到更精確的模式。線性迴歸用於迴歸問題且假設線性關係。KNN

雖然能處理非線性,但在大數據下預測成本高(需計算與所有訓練點的距離)。PCA 是非監督式降維方法,不是鑑別式分類模型。

#5

★★★★

在分散式機器學習框架(如 Apache Spark MLlib)中,使用大數據訓練鑑別式模型時,資料平行化(Data

Parallelism)通常如何實現?

答案解析

資料平行化是處理大數據的關鍵策略。它將龐大的資料集切分成小塊(partitions

or splits),分發到叢集中的多個工作節點(worker

nodes)。每個工作節點上運行著一份模型的副本(或模型的一部分狀態),並獨立地處理分配給它的資料子集(例如計算局部梯度)。然後,各節點的計算結果會被匯總(如梯度聚合)以更新全域模型參數。選項A更接近某些特徵平行化的概念。選項C描述的是模型平行化(Model

Parallelism),通常用於模型本身非常大,無法放入單一節點記憶體的情況。選項D不是分散式處理。

#6

★★★★

當使用大數據訓練鑑別式分類模型時,若資料集中存在嚴重的類別不平衡(Class

Imbalance)問題,直接使用準確率(Accuracy)作為評估指標可能會有什麼問題?

答案解析

類別不平衡指不同類別的樣本數量差異懸殊。例如,在詐欺偵測中,正常交易(多數類)遠多於詐欺交易(少數類)。如果模型總是預測為正常交易,即使它完全無法辨識出任何詐欺交易,其準確率也可能非常高(例如99%),因為它正確分類了大部分的正常交易。這顯然無法反映模型在關鍵的少數類別上的表現。在這種情況下,應使用如精確率(Precision)、召回率(Recall)、F1分數(F1-Score)、AUC(Area Under the ROC

Curve)等對類別不平衡更魯棒的指標。

#7

★★★★★

在電子商務平台中,利用大量使用者歷史行為數據(點擊、瀏覽、購買)來預測使用者可能點擊或購買某商品的機率,這屬於哪種結合大數據的鑑別式AI應用?

答案解析

推薦系統是利用大數據分析使用者行為和偏好的典型應用。點擊率(CTR)預估或轉換率(CVR)預估是推薦系統中的核心任務之一,其目標是建立一個鑑別式模型(如邏輯迴歸、因子分解機、深度學習模型)來預測使用者對特定推薦項目(商品、廣告等)產生互動(點擊、購買)的可能性。這是一個典型的利用大量歷史數據進行監督式學習的分類或迴歸問題。NLP主要處理文字,電腦視覺處理圖像/影片,異常檢測關注找出罕見模式。

#8

★★★★

面對大數據集中的高維度特徵(High-Dimensional

Features),在訓練鑑別式模型前,進行降維(Dimensionality

Reduction)的主要好處不包含下列哪項?

答案解析

降維技術(如主成分分析 PCA、線性判別分析 LDA、t-SNE等)旨在將高維度數據轉換為低維度表示,同時盡可能保留重要資訊。其好處包括:減少計算量、緩解維度災難(高維空間數據稀疏,模型難以學習)、去除雜訊和冗餘特徵、有助於資料視覺化。然而,降維過程本身可能會損失部分資訊,特別是非線性降維方法雖然能捕捉非線性結構,但不能保證找到 *所有* 潛在的非線性關係,且線性降維方法(如PCA)主要捕捉線性關係。因此,D選項的「保證」過於絕對,不是降維的主要好處或能力。

#9

★★★

大數據的「真實性」(Veracity)問題,即數據中可能包含雜訊、錯誤、不一致或缺失值,對鑑別式AI模型的訓練可能產生什麼負面影響?

答案解析

數據品質是機器學習成功的基石。「Garbage in, garbage

out。」如果訓練數據的真實性存疑,包含大量錯誤或雜訊,鑑別式模型在學習過程中可能會被這些不可靠的數據誤導,學習到虛假的關聯或模式,導致其在未見過的新數據上的表現(泛化能力)不佳,預測結果不準確。雖然大數據本身可能包含冗餘資訊,有一定程度的抗噪能力,但嚴重的 Veracity 問題仍會顯著影響模型效能。增加資料量可能有幫助,但不能完全替代數據清理和質量控制。

#10

★★★★

Apache Spark 是一個常用於大數據處理與分析的框架,其 MLLib 函式庫提供了多種機器學習演算法。相較於傳統的

Hadoop MapReduce,Spark

主要的優勢是什麼,使其更適合迭代式的機器學習演算法(如許多鑑別式模型的訓練過程)?

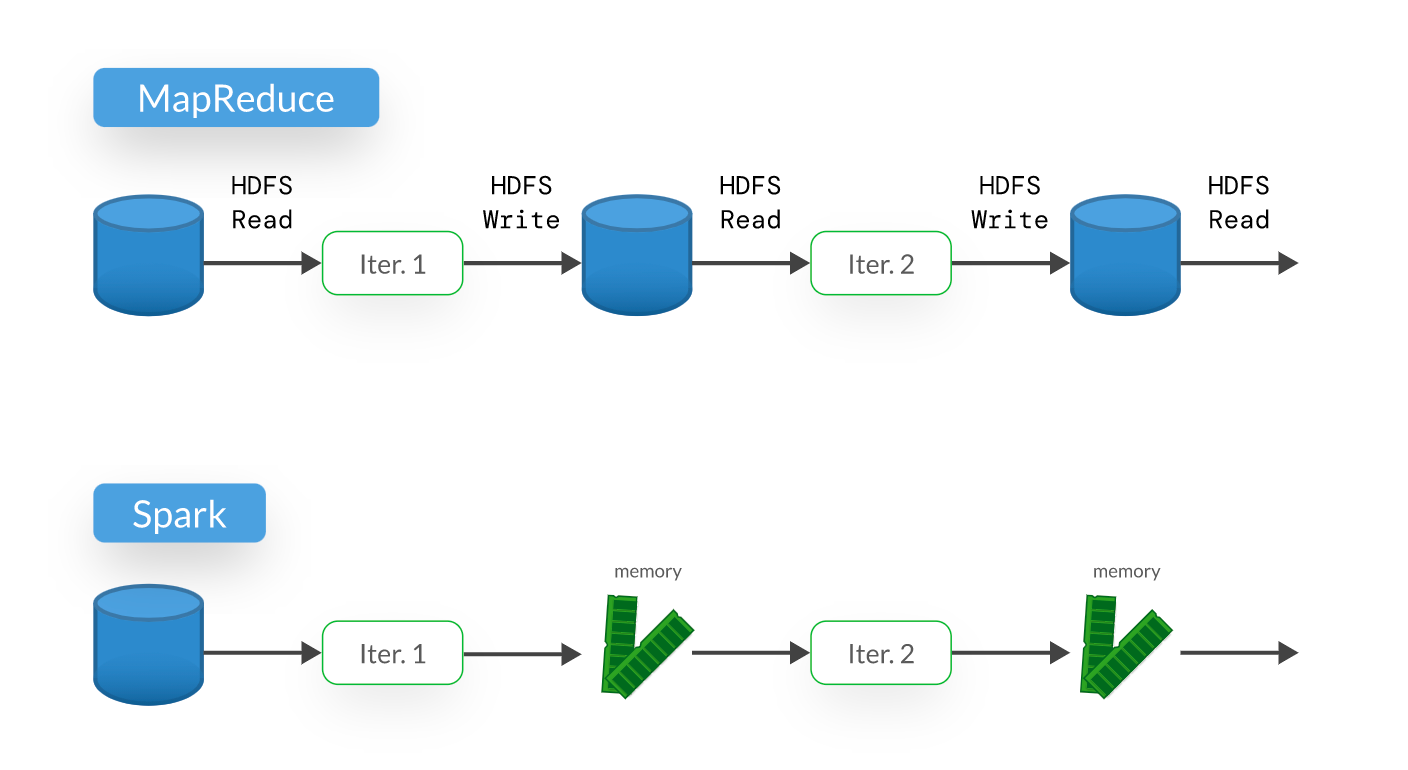

答案解析

許多機器學習演算法(尤其是優化過程,如梯度下降)需要多次迭代處理數據。傳統的 Hadoop MapReduce 在每次迭代之間需要將中間結果寫入磁碟(HDFS)再讀出,造成大量的 I/O

開銷。Spark 引入了彈性分散式資料集(Resilient Distributed

Dataset, RDD)和後來的 DataFrame/Dataset API,允許將數據和中間結果緩存在記憶體中,極大地加速了需要多次數據掃描和迭代計算的任務,使其非常適合機器學習應用。Spark

支援多種語言(Scala, Java,

Python, R),需要資料前處理,也能處理多種格式的資料。

#11

★★★★

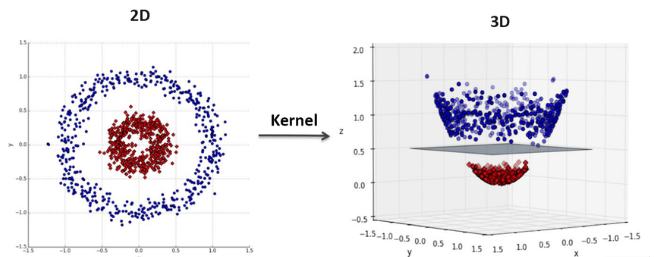

下列哪個鑑別式模型在處理大數據時,可以透過核技巧(Kernel Trick)有效處理高維空間的非線性分類問題,但在資料量極大時訓練可能較慢?

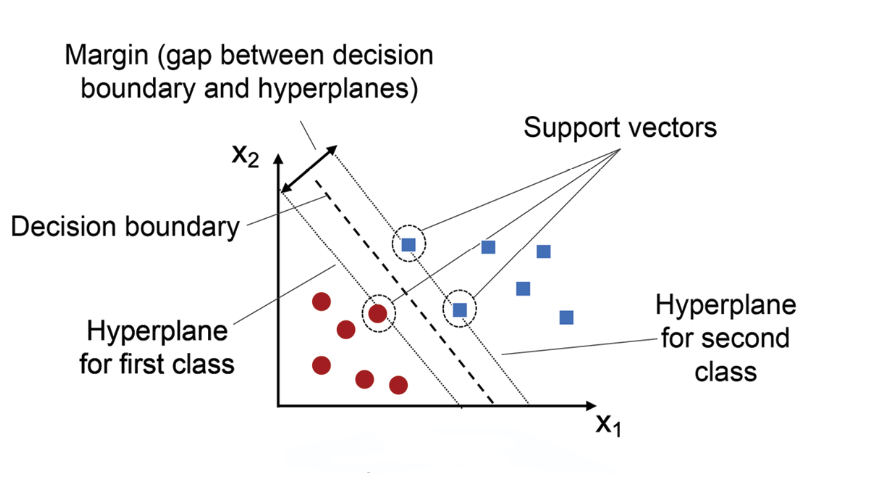

答案解析

支持向量機(SVM)通過最大化類別間的邊界(Margin)來進行分類。核技巧允許

SVM 在不顯式計算高維座標的情況下,學習高維空間中的非線性決策邊界,非常強大。然而,標準的 SVM

訓練複雜度與樣本數的平方或立方相關,當資料量(樣本數)非常大時,訓練會變得非常耗時和消耗資源,需要使用近似算法或特定為大數據設計的變種(如 Pegasos)。邏輯迴歸是線性模型(或需手動加非線性特徵)。Naive

Bayes 和 LDA 通常計算效率較高,但模型假設較強。

#12

★★★

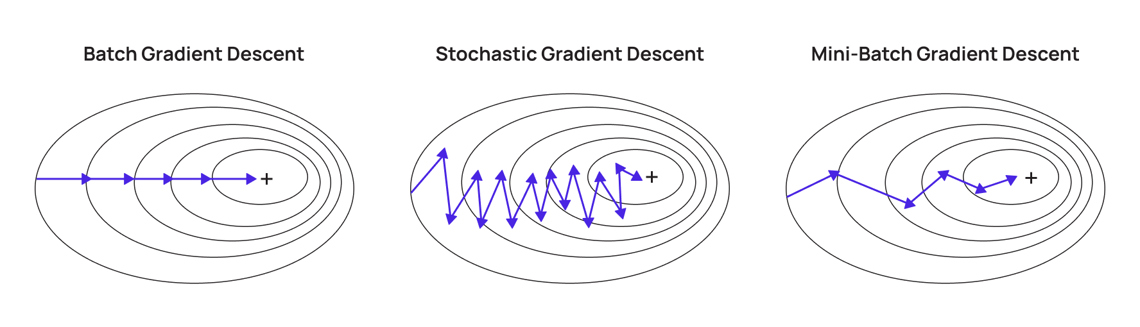

在分散式環境下使用大數據訓練鑑別式模型時,「梯度下降」(Gradient

Descent)的哪種變體最常被用於處理分佈在不同節點上的資料?

答案解析

批次梯度下降(BGD)需要計算整個資料集的梯度,在大數據下不可行。隨機梯度下降(SGD)每次只用一個樣本,變異性大,不易平行化。小批次隨機梯度下降(Mini-batch SGD)是介於兩者之間的折衷,每次使用一小批資料計算梯度。這既利用了 SGD 的隨機性優點(跳出局部最優),又能利用現代硬體的平行計算能力(如 GPU 加速處理一個批次),並且非常適合分散式環境:每個節點可以計算分配給它的一或多個 Mini-batch 的梯度,然後進行同步或非同步更新。牛頓法和共軛梯度法是其他優化方法,計算成本通常更高。

#13

★★★

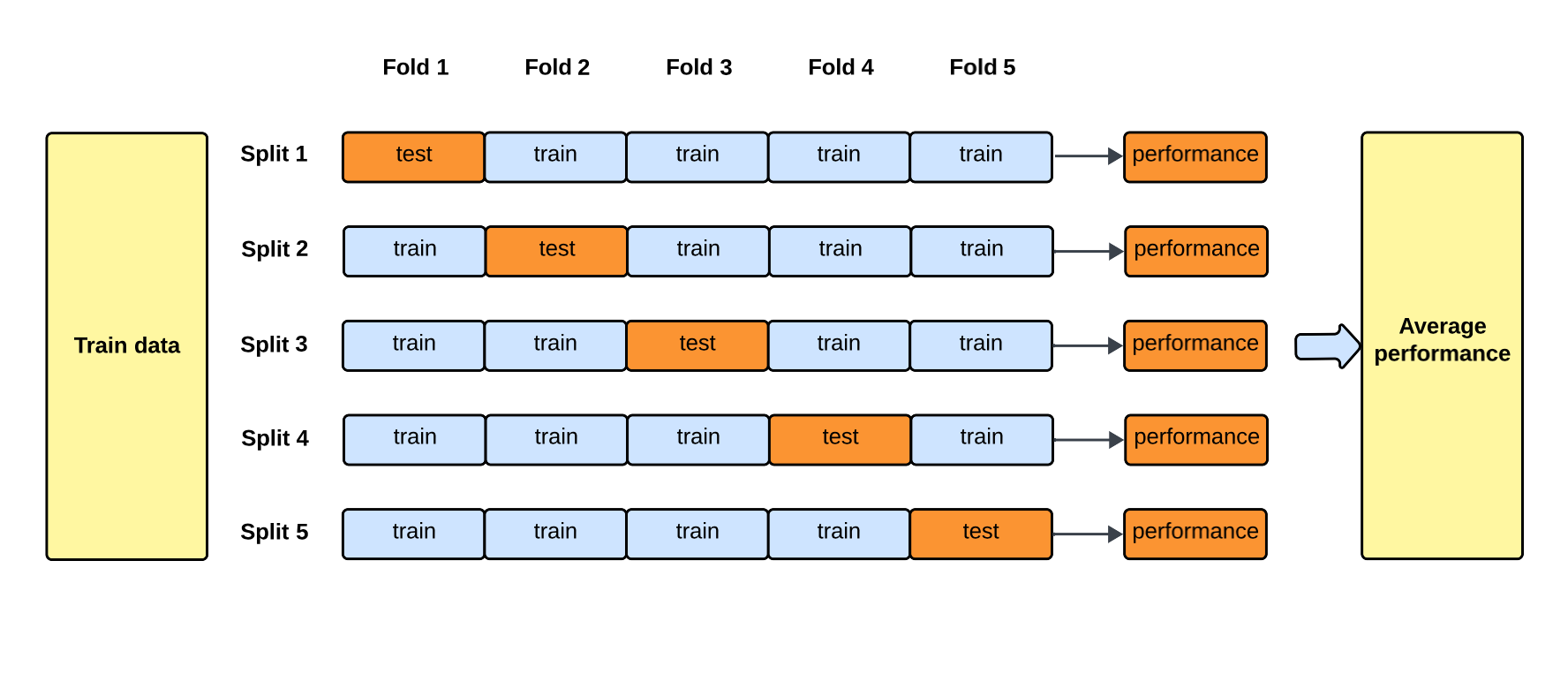

在大數據背景下評估鑑別式模型時,交叉驗證(Cross-Validation)的主要挑戰是什麼?

答案解析

交叉驗證(如 K-摺交叉驗證)是一種常用的模型評估方法,它將數據分成 K 份,輪流使用

K-1 份訓練,1 份驗證,重複 K 次。這能提供更穩健的模型效能估計。然而,在大數據集上,這意味著需要將複雜的模型重複訓練 K 次,每次訓練都可能非常耗時,導致總體的計算成本極高。因此,在大數據場景下,有時會採用簡化的驗證策略,如單次的訓練/驗證/測試集劃分,或使用特定的分散式交叉驗證方法。交叉驗證本身能提供較無偏的估計,可用於多類別問題,也有適用於時間序列的版本。

#14

★★★★

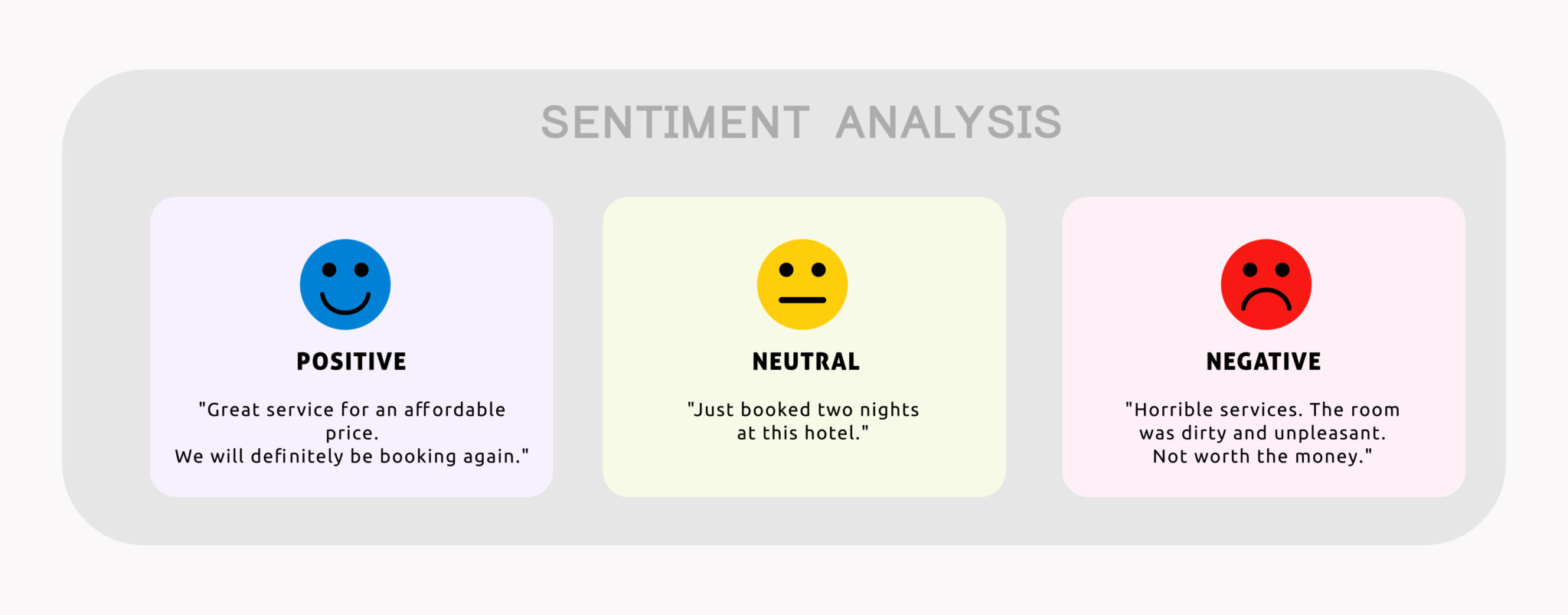

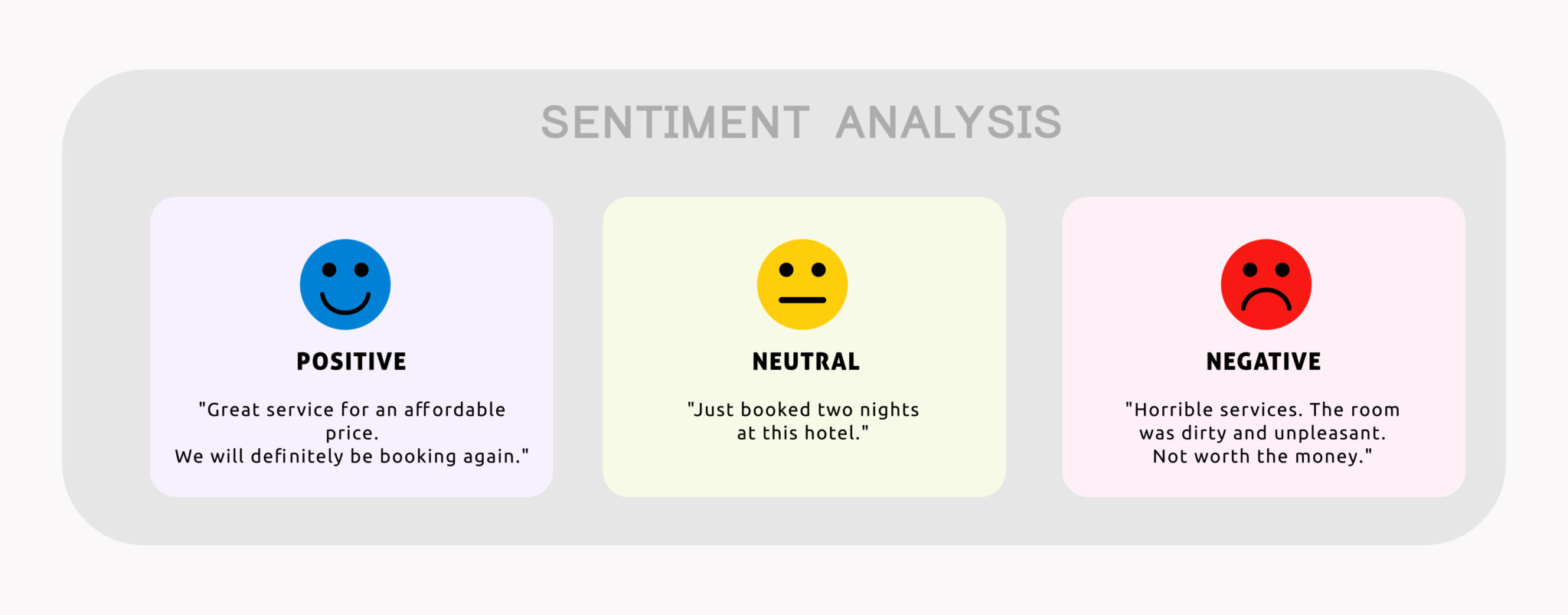

利用海量的社群媒體文字資料,訓練模型來判斷每條訊息的情感傾向(正面、負面、中性),這主要是應用了大數據在哪個鑑別式AI任務上?

答案解析

情感分析是自然語言處理(NLP)中的一個典型任務,旨在自動辨識和提取文本資料中表達的情感、觀點或評價。這通常被建模為一個分類問題(鑑別式任務),即將文字分為預定義的情感類別。利用大數據(如海量社群媒體貼文、產品評論)可以訓練出更準確、更能捕捉細微情感差異的模型。機器翻譯是語言轉換,NER是辨識特定實體(人名、地名等),主題模型是非監督式地發現文本集中的主題。

#15

★★★★

在金融領域使用大數據訓練鑑別式模型進行信用評分或詐欺偵測時,模型的可解釋性(Interpretability)為何重要?

答案解析

在金融等高風險、受監管的領域,僅有高準確率的模型是不夠的。監管機構可能要求解釋模型做出特定決策(如拒絕貸款)的原因。理解模型決策邏輯有助於使用者(如信貸員、客戶)信任模型結果。同時,可解釋性分析有助於檢查模型是否基於不公平或歧視性的因素做出判斷(例如,是否存在對特定人群的偏見)。雖然複雜的黑盒子模型(如深度學習)可能準確率更高,但其可解釋性差,限制了它們在這些場景的直接應用或需要額外搭配可解釋性技術(XAI)。可解釋性與準確率之間往往存在一定的權衡。

#16

★★★

TensorFlow 和 PyTorch 是當前流行的深度學習框架,它們如何支持使用大數據訓練鑑別式模型?

答案解析

TensorFlow 和 PyTorch 雖然本身不是大數據儲存或管理系統,但它們提供了高效的資料載入和預處理管道(如

tf.data,

PyTorch DataLoader),能夠處理大型資料集。它們的核心優勢在於能充分利用 GPU 進行大規模平行計算,極大加速深度學習模型的訓練。此外,兩者都提供了進行分散式訓練的API和工具(如 tf.distribute.Strategy, PyTorch DistributedDataParallel),允許將模型訓練擴展到多個機器或多個 GPU 上,從而能夠處理超出單機能力的大數據和/或大模型。它們廣泛用於訓練各種鑑別式模型(如分類器)。#17

★★

大數據的「即時性」(Velocity)對鑑別式AI應用(例如,即時詐欺偵測)的主要需求是什麼?

答案解析

Velocity

指的是數據生成和流動的速度很快。在需要即時反應的應用場景(如線上交易的詐欺偵測、即時推薦、監控系統異常檢測等),鑑別式模型不僅要在歷史數據上訓練好,還必須能夠在新的數據點(如一筆交易)到達時,以非常低的延遲進行預測(推論),以便及時採取行動(如阻止交易、更新推薦)。這對模型的推論效率和部署架構(如使用串流處理框架 Kafka, Flink, Spark

Streaming)提出了很高要求。離線批量處理適用於模型訓練或非即時分析。

#18

★★★

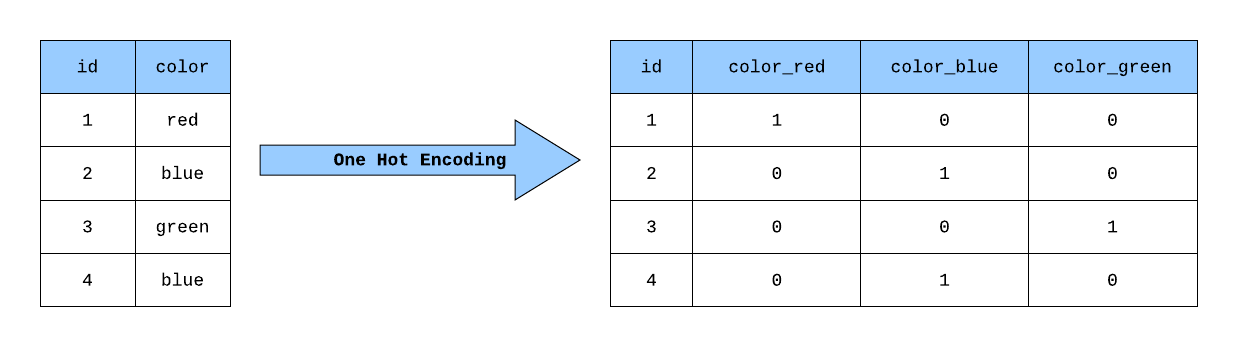

在處理用於鑑別式模型訓練的大數據時,如果遇到類別型特徵(Categorical Features)具有非常多可能的類別(High Cardinality),例如使用者ID或商品ID,直接使用獨熱編碼(One-Hot

Encoding)可能會有什麼問題?

答案解析

獨熱編碼(One-Hot

Encoding)將每個類別轉換為一個二元向量,向量長度等於總類別數,只有對應類別的位置為1,其餘為0。如果一個類別特徵有成千上萬甚至百萬個可能的取值(如使用者ID),獨熱編碼會產生一個維度極高且極其稀疏(大部分元素為0)的特徵向量。這不僅會大幅增加模型的輸入維度,帶來儲存和計算上的挑戰(尤其在大數據背景下),也可能因資料稀疏性影響某些模型的學習效果。在這種情況下,常會考慮使用其他編碼方法,如特徵雜湊(Feature

Hashing)或嵌入(Embeddings)。

#19

★★★★

集成學習(Ensemble Learning)中的隨機森林(Random

Forest)如何適應大數據的鑑別式分類任務?

答案解析

隨機森林是構建多棵決策樹並將它們的預測結果進行整合(如投票)的集成方法。其優勢在於:1) 每棵樹的訓練相對獨立,非常適合平行化處理,可以分佈到不同機器或核心上訓練,加速處理大數據。2) 它在構建每棵樹時,會對訓練樣本進行隨機抽樣(Bootstrap aggregating, or

Bagging),並在每個節點分裂時只考慮隨機抽樣的一部分特徵,這使得它對高維度資料和資料中的雜訊具有較好的穩健性,並且能夠有效利用大數據。隨機森林能處理非線性問題,且分散式實現不要求所有資料都在單機記憶體。

#20

★★★

在參數伺服器(Parameter Server)架構中,使用大數據進行分散式訓練鑑別式模型時,伺服器節點(Server Nodes)的主要職責是什麼?

答案解析

參數伺服器是一種常見的分散式機器學習架構。它將計算節點分為兩類:工作節點(Worker

Nodes)和伺服器節點(Server Nodes)。工作節點負責讀取分配到的資料、進行模型計算(如前向傳播、反向傳播、梯度計算),然後將計算出的梯度或參數更新發送到伺服器節點。伺服器節點則負責維護模型的最新的全域參數,接收來自多個工作節點的更新,進行聚合(如求平均),並將更新後的參數廣播回工作節點供下一輪計算使用。

#21

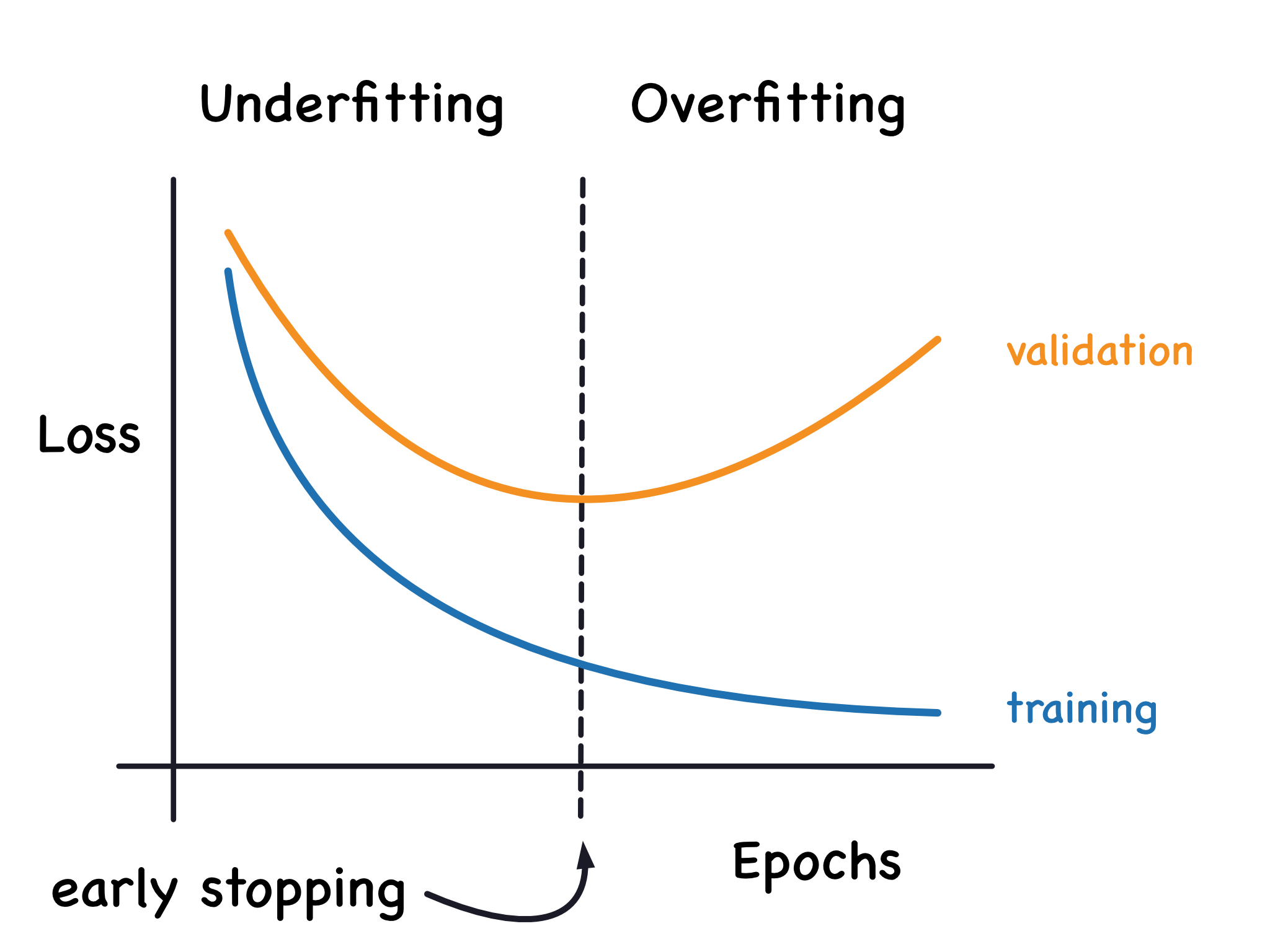

★★★★

當使用大數據訓練鑑別式模型時,觀察到訓練集上的效能(例如,準確率)持續提高,但驗證集上的效能達到某個點後開始下降,這種現象稱為什麼?

答案解析

過度擬合(Overfitting)是指模型在訓練數據上表現過好,學習到了訓練數據中的雜訊或特定模式,但這些模式無法推廣到未見過的新數據(如驗證集或測試集)。其典型表現就是訓練效能持續提升,而驗證效能停滯甚至下降。欠擬合(Underfitting)是指模型過於簡單,未能充分學習到訓練數據中的模式,導致訓練和驗證效能都較差。資料漂移指數據分佈隨時間發生變化。模型收斂指訓練過程達到穩定狀態。在大數據下,雖然數據量大有助於緩解過度擬合,但如果模型過於複雜或訓練時間過長,仍然可能發生過度擬合。

#22

★★★

醫療領域利用大量的病患電子病歷(Electronic Health Records, EHR)數據,訓練鑑別式模型來預測病患未來罹患某種疾病(如糖尿病)的風險,這體現了大數據在鑑別式AI的哪個應用方向?

答案解析

利用結構化(如檢驗數值、用藥記錄)和非結構化(如醫生筆記)的電子病歷大數據,訓練模型(如邏輯迴歸、隨機森林、RNN/LSTM處理時序資訊)來辨識可能導致未來疾病的風險因子組合,並預測個體病患的發病風險,是鑑別式AI在醫療領域的重要應用。這有助於醫生進行早期干預和預防。藥物發現通常涉及更複雜的分子模擬或生成模型。影像分割是電腦視覺任務。健身計畫推薦雖也可能用到大數據,但與醫療診斷不同。

#23

★★★

當使用大數據訓練鑑別式模型時,如果不同來源的資料在合併時存在格式或語意上的不一致(例如,日期格式不同,或「性別」欄位有「男/女」、「M/F」、「1/0」等多種表示),這主要涉及到大數據的哪個品質維度問題?

答案解析

數據一致性指的是數據在不同記錄、不同表格或不同系統之間是否遵循相同的標準和定義。當合併來自異構來源的大數據時,常常會遇到表示同一概念卻使用不同格式或代碼的情況,這就是一致性問題。在將這些數據餵給鑑別式模型之前,必須進行清理和轉換,將它們統一成標準格式,否則模型可能無法正確理解和利用這些資訊。完整性指數據是否存在缺失。及時性指數據是否足夠新。獨特性指是否存在重複記錄。

#24

★★

H2O.ai 是一個開源的機器學習與AI平台,它針對大數據環境下的鑑別式模型訓練提供了哪些特性?

答案解析

H2O.ai 平台的核心設計就是為了在分散式環境(如 Hadoop 或 Kubernetes 叢集)中高效處理大數據。它採用記憶體內(In-Memory)運算架構,類似於

Spark,以加速計算。H2O

內建了多種高效能的機器學習演算法實作,特別是其梯度提升機(Gradient Boosting

Machine, GBM)、深度學習以及自動化機器學習(AutoML)功能,非常適合用於建立高效能的鑑別式模型。它支援多種介面(Python,

R, Web

UI),並非僅限單機,也非專注於生成任務。

#25

★★★★

相較於生成式模型(Generative Model),鑑別式模型在大數據應用中的一個主要優勢通常是什麼?

答案解析

鑑別式模型直接專注於學習輸入到輸出的映射關係或類別間的決策邊界,其目標就是最大化預測的準確性。相比之下,生成式模型需要學習數據的完整聯合分佈

P(X,Y),這通常是一個更困難的任務。因此,在給定足夠數據(尤其大數據)的情況下,鑑別式模型往往能在特定的預測任務(如分類、迴歸)上取得比生成式模型更好的效能。生成數據是生成式模型的長處。處理缺失值和理解分佈則各有方法,不一定是鑑別式模型的絕對優勢。

#26

★★★★

在大數據背景下進行特徵工程(Feature

Engineering)時,自動特徵生成(Automated Feature Generation)技術(例如使用深度學習模型自動學習表示)相較於手動特徵工程的主要潛在好處是什麼?

答案解析

手動特徵工程需要依賴領域專家的知識和經驗來設計有效的特徵,這在高維度、複雜的大數據上可能非常耗時且不全面。深度學習等模型能夠從原始數據中自動學習分層次的特徵表示(Representation Learning),可能捕捉到人難以發現的高階非線性交互關係,從而提升模型效能,並減少對手動設計特徵的依賴。然而,自動學習到的特徵通常可解釋性較差(選項A錯誤)。自動學習過程計算成本可能很高(選項C錯誤)。生成的特徵維度可能增加(如在中間層)或減少(如在瓶頸層),不一定變少(選項D錯誤)。

#27

★★★

梯度提升決策樹(Gradient Boosting Decision Tree, GBDT)是一種強大的鑑別式模型,它在大數據應用上相較於單一決策樹的主要優勢是什麼?

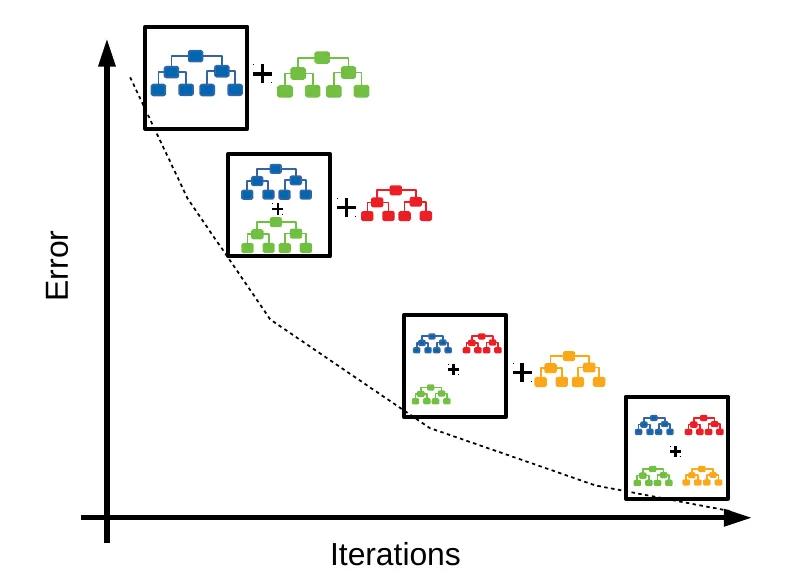

答案解析

GBDT 屬於集成學習中的提升(Boosting)方法。它循序地建立一系列決策樹,每一棵新的樹都試圖去擬合(學習)前面所有樹累積下來的殘差(Residuals)或梯度。透過這種逐步修正錯誤的方式,GBDT 通常能夠建構出比單一決策樹或其他集成方法(如隨機森林)更精確的模型。然而,GBDT 的訓練過程是循序的,不易完全平行化(不像隨機森林),訓練速度可能較慢(選項C錯誤)。模型結構較複雜,解釋性不如單一決策樹(選項A錯誤)。它對離群值相對敏感(選項D錯誤)。針對大數據,有如

XGBoost, LightGBM,

CatBoost 等高效的 GBDT

實作。

#28

★★

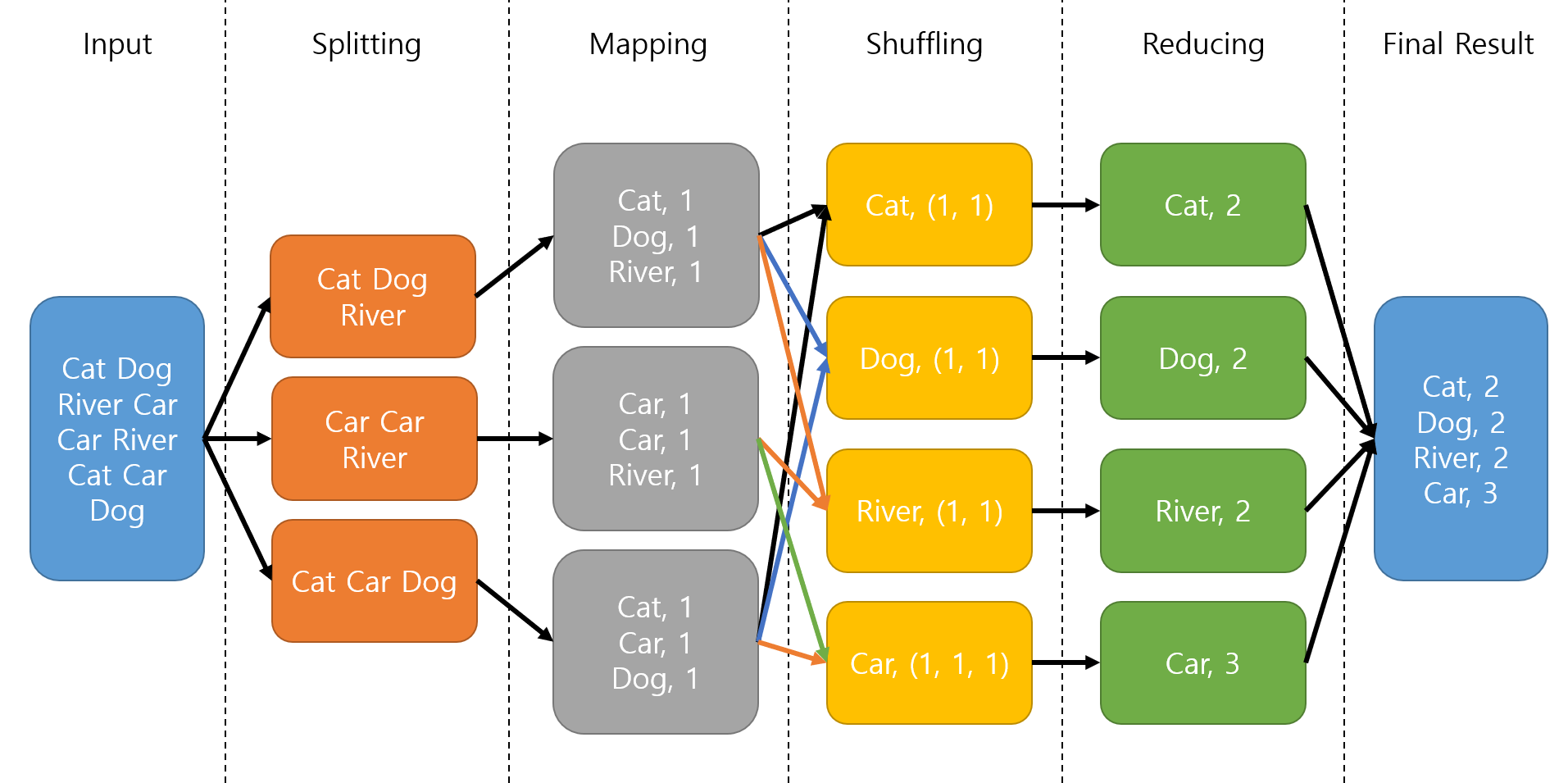

在分散式環境中使用 MapReduce 典範來實現鑑別式模型(例如,計算邏輯迴歸的梯度)時,"Reduce"

階段通常負責什麼任務?

答案解析

MapReduce 是一個用於處理大數據的分散式編程模型。在 Map 階段,輸入資料被分割,每個 Mapper

節點處理一部分資料並產生中間的鍵值對(Key-Value

Pairs)。例如,計算分配給該 Mapper 的資料子集的局部梯度。在 Reduce 階段,具有相同鍵的中間結果會被送到同一個 Reducer 節點。Reducer

負責將這些來自不同 Mapper 的局部結果進行匯總、合併或處理,以產生最終的輸出。例如,將所有 Mapper 計算出的局部梯度相加,得到整個資料集的總梯度。選項A是資料分發過程。選項B是 Map 階段的任務。選項D是推論階段的任務。

#29

★★★

在大數據應用中,除了模型本身的效能指標(如準確率、AUC),評估一個鑑別式 AI 系統時還需要考慮哪個重要的非功能性指標?

答案解析

在大數據場景下,除了模型的預測準確度外,系統的實際運行效能至關重要。可擴展性(Scalability)指系統處理不斷增長的數據量和用戶量的能力,是否能通過增加資源(如更多機器)來維持或提升效能。處理延遲(Latency)指系統從接收輸入到產生輸出的時間,對於需要即時反應的應用(如即時推薦、詐欺偵測)尤其關鍵。這些非功能性指標直接影響系統的可用性和使用者體驗。程式語言、參數數量、資料來源國雖然也是相關因素,但不如擴展性和延遲性來得核心和普遍。

#30

★★★★

電信業者利用大量的用戶通話記錄、上網行為、方案訂閱等數據,訓練鑑別式模型來預測哪些用戶可能會流失(Churn),以便提前採取挽留措施,這是大數據在鑑別式AI的哪類應用?

答案解析

客戶流失預測是一個重要的商業智慧應用,旨在辨識出那些具有高可能性終止服務或轉向競爭對手的客戶。這通常被建模為一個二元分類問題(流失 vs.

不流失),利用歷史客戶數據(包括人口統計學資訊、使用行為、互動記錄等大數據)來訓練鑑別式模型(如邏輯迴歸、決策樹、SVM、神經網路等)。預測結果可以幫助企業針對高風險客戶制定精準的挽留策略,從而降低客戶流失率。

#31

★★

在大數據環境下,為確保鑑別式模型訓練的公平性(Fairness),避免對特定群體(如基於性別、種族)產生歧視性預測,需要關注哪個環節?

答案解析

確保 AI 公平性是一個貫穿機器學習生命週期的問題。首先,需要檢查原始數據收集是否存在偏見,以及在前處理中是否加劇了偏見。其次,某些模型演算法可能更容易學習到或放大偏見,需要謹慎選擇或進行調整。最後,評估模型時,除了整體效能,還需要使用特定的公平性指標來衡量模型在不同群體上的表現是否存在差異。簡單地忽略敏感屬性可能不夠,因為其他特徵可能與敏感屬性高度相關,導致間接歧視。因此,需要綜合考慮數據、演算法和評估等多個環節。

#32

★★★

雲端平台(如 AWS SageMaker, Google AI

Platform, Azure Machine Learning)為使用大數據訓練鑑別式模型提供了便利,其主要優勢不包含下列哪項?

答案解析

雲端機器學習平台極大地簡化了大數據 AI

應用的開發與部署。它們提供按需分配的強大計算能力(CPU/GPU)和儲存空間,內建了數據標註、特徵工程、模型訓練框架(支援 TensorFlow, PyTorch

等)、自動化機器學習(AutoML)、模型版本控制、一鍵部署、效能監控等一系列工具。這使得團隊可以更快速地實驗和迭代。然而,雖然 AutoML 等功能降低了門檻,但要獲得真正好的、符合業務需求的模型,使用者仍然需要具備相當的機器學習知識來選擇合適的工具、設計實驗、解讀結果和進行調優。平台無法保證無需知識就能獲得最佳模型。

#33

★★

大數據的「價值」(Value)特性,強調從大量數據中提取有用的洞見。鑑別式AI如何幫助實現這一點?

答案解析

大數據本身若不能轉化為有價值的資訊或行動,就只是成本。鑑別式

AI 的核心能力是從數據中學習模式並進行預測(分類或迴歸)。例如,透過分析客戶購買數據預測流失風險,分析感測器數據預測設備故障,分析市場數據預測銷售趨勢。這些預測性的洞見可以直接支持商業決策(如制定挽留策略、安排預防性維護、調整庫存),或者驅動自動化流程(如自動過濾垃圾郵件、自動批准信用申請),從而從大數據中提取並實現其潛在的價值。

#34

★★★

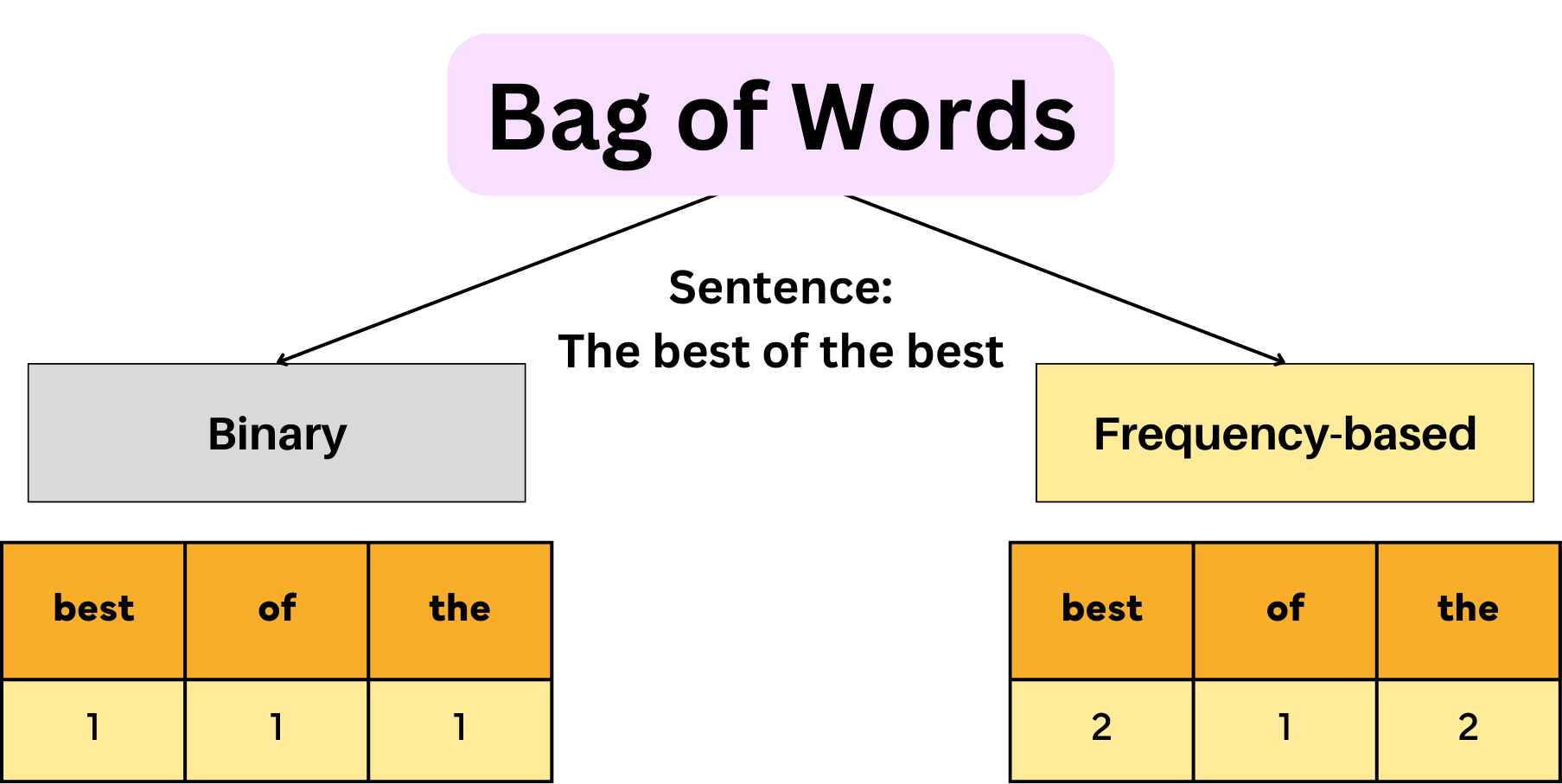

在處理用於鑑別式模型訓練的大量文本數據時,詞袋模型(Bag-of-Words, BoW)表示法的主要缺點是什麼?

答案解析

詞袋模型將文本表示為一個向量,其中每個維度對應詞彙表中的一個詞,向量的值通常是該詞在文本中出現的次數(或 TF-IDF 值)。這種表示方法雖然簡單有效,但它完全丟失了原始文本中詞語的排列順序和語法結構資訊。例如,「狗咬人」和「人咬狗」在詞袋模型下可能具有完全相同的表示,但它們的語意顯然不同。對於需要理解上下文或語序的鑑別式任務,詞袋模型的這個缺點可能會限制模型效能。TF-IDF 等變體可以表示詞頻(選項A錯誤)。它可以處理長文本(選項C錯誤)。其維度等於詞彙表大小,通常很高(選項D錯誤)。

#35

★★★

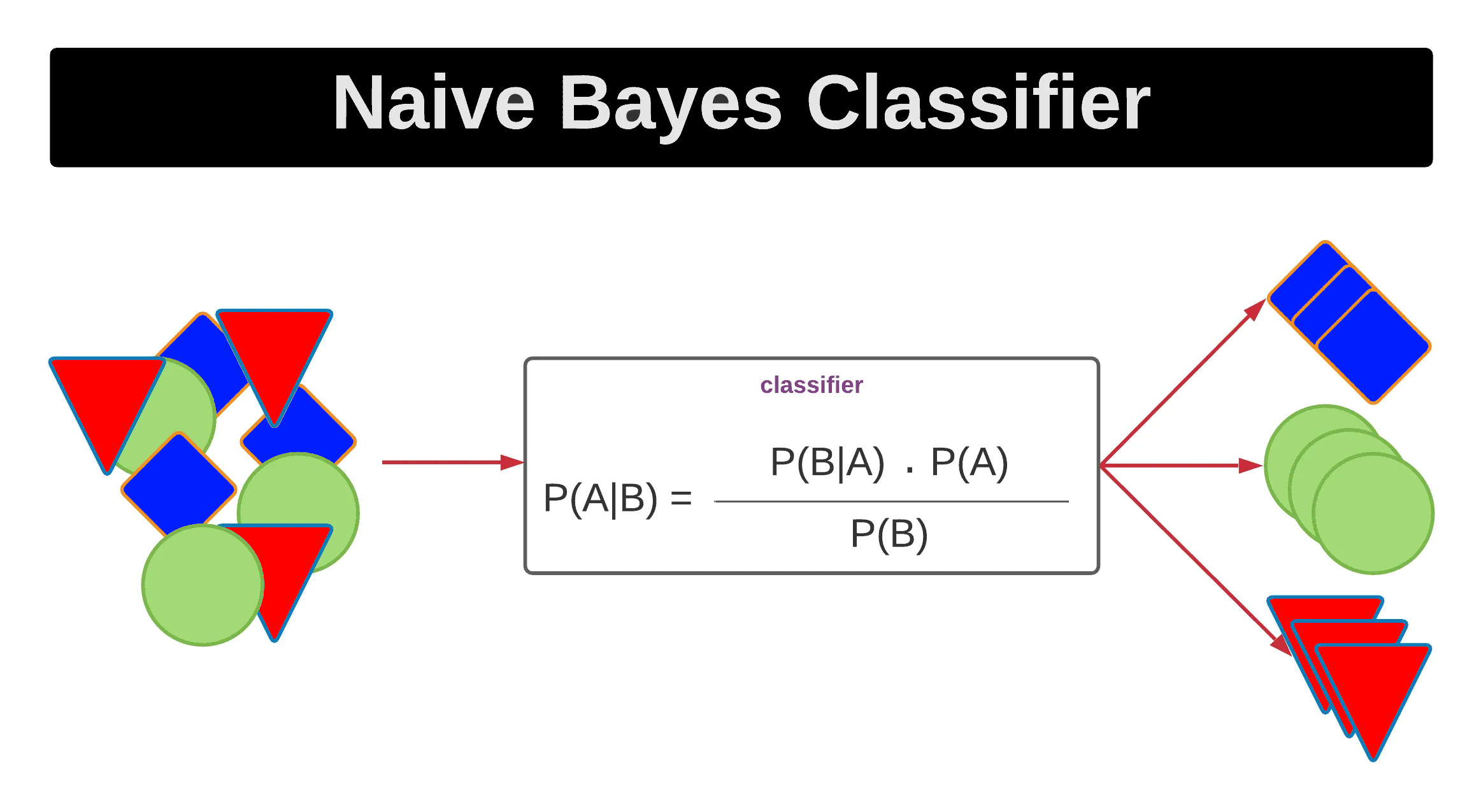

哪種鑑別式模型基於貝氏定理(Bayes'

Theorem),並假設特徵之間條件獨立?這種假設在大數據的高維特徵下可能不成立,但模型計算簡單快速。

答案解析

樸素貝氏分類器是一類基於貝氏定理的簡單機率分類器。其「樸素」(Naive)之處在於它假設所有輸入特徵之間在給定類別的條件下是相互獨立的。這個假設在現實世界的數據中往往不成立,尤其是在具有複雜關聯的大數據特徵中。然而,儘管這個假設很強,Naive

Bayes 模型在許多實際應用(尤其文本分類)中表現出奇地好,並且其優點是計算效率高,易於實現,對小數據集和高維數據(如文本詞袋特徵)處理效果不錯。

#36

★★★★

使用 GPU(圖形處理單元,Graphics Processing

Unit)加速大數據鑑別式模型(尤其是深度學習模型)訓練的主要原因是?

答案解析

深度學習模型的訓練涉及大量的矩陣乘法、向量加法等線性代數運算。CPU(中央處理單元)通常擁有少量但功能強大的核心,擅長處理複雜的循序任務。而 GPU

則擁有數百甚至數千個相對簡單的處理核心,設計初衷是為了並行處理圖形渲染中的像素計算,這使其天然地非常適合執行大規模、高度平行化的數值計算,如深度學習中的矩陣運算。透過將這些運算分配到眾多

GPU 核心上並行執行,可以比僅使用 CPU 實現數量級的加速。GPU

單核速度通常不如 CPU,快取結構也不同,能耗通常較高。

| 特性 | CPU (中央處理單元) | GPU (圖形處理單元) | NPU (神經網路處理單元) |

|---|---|---|---|

| 核心架構 | 少量、功能強大的核心 | 大量、相對簡單的核心 | 專為AI運算設計的特定電路 |

| 擅長任務 | 通用計算、複雜邏輯、循序任務 | 大規模平行計算、圖形渲染 | 神經網路推論與訓練、矩陣運算 |

| 運算模式 | 低延遲、高時脈速度 | 高吞吐量、並行處理 | 高能效、專用指令集 |

| 應用範例 | 作業系統、一般軟體 | 遊戲、科學計算、AI訓練 | 手機AI功能、智慧相機、AI加速器 |

#37

★★

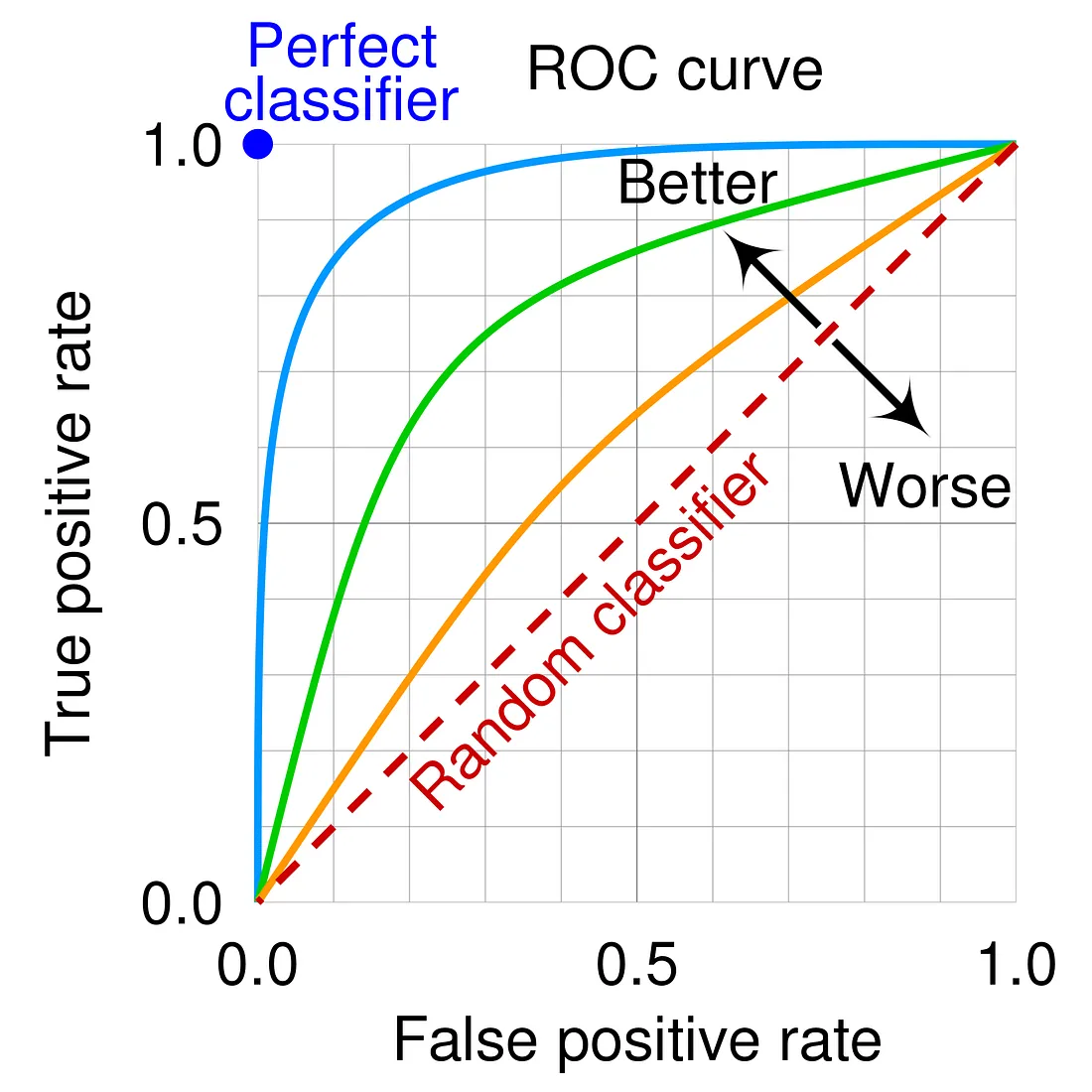

在評估鑑別式二元分類模型時,ROC 曲線(Receiver Operating Characteristic Curve)的橫軸和縱軸分別代表什麼?

答案解析

ROC 曲線是用於視覺化二元分類模型在不同分類閾值下效能的圖形。它繪製的是模型的真陽性率(TPR,也稱為召回率或敏感度,即正確預測為正例的比例)與偽陽性率(FPR,即錯誤預測為正例的比例,FPR

= 1 - 真陰性率/特異度)之間的關係。曲線越靠近左上角(即

TPR 高而 FPR

低),表示模型效能越好。AUC(Area Under

the ROC Curve)即 ROC 曲線下的面積,是衡量模型整體區分能力的常用指標。選項 A 描述的是 Precision-Recall 曲線。

#38

★★★

在自動駕駛領域,利用來自多個感測器(攝影機、光達 LiDAR、雷達)的大量數據,訓練鑑別式模型來辨識道路上的其他車輛、行人、交通號誌等,這屬於哪個AI應用領域?

答案解析

自動駕駛系統需要精確地感知周圍環境。物件偵測是電腦視覺中的一個核心任務,旨在識別影像或感測器數據中感興趣的物件(如汽車、行人)並確定它們的位置(通常用邊界框表示)。場景理解則更進一步,試圖理解物件之間的關係以及整體環境的佈局。這些通常被建模為鑑別式任務(例如,使用卷積神經網路

CNN 或 Transformer

架構的模型),需要利用大量標註過的感測器數據進行訓練。

#39

★★★

為何在某些鑑別式AI應用中(如利用大數據進行犯罪預測),需要特別警惕演算法偏見(Algorithmic Bias)?

答案解析

演算法偏見是指 AI 系統由於數據、設計或使用方式中的問題而產生系統性的、不公平的結果。如果用於訓練模型的歷史數據本身就反映了社會上存在的偏見(例如,某些族群在歷史執法記錄中被過度執法),那麼鑑別式模型很可能會學習到這些偏見,並在預測中複製甚至放大它們,導致對特定群體產生不公平的對待(如更高的犯罪風險評估)。這不僅是技術問題,更是嚴重的倫理和社會問題。偏見會影響預測結果,且存在於監督式(鑑別式)和非監督式學習中。

#40

★★

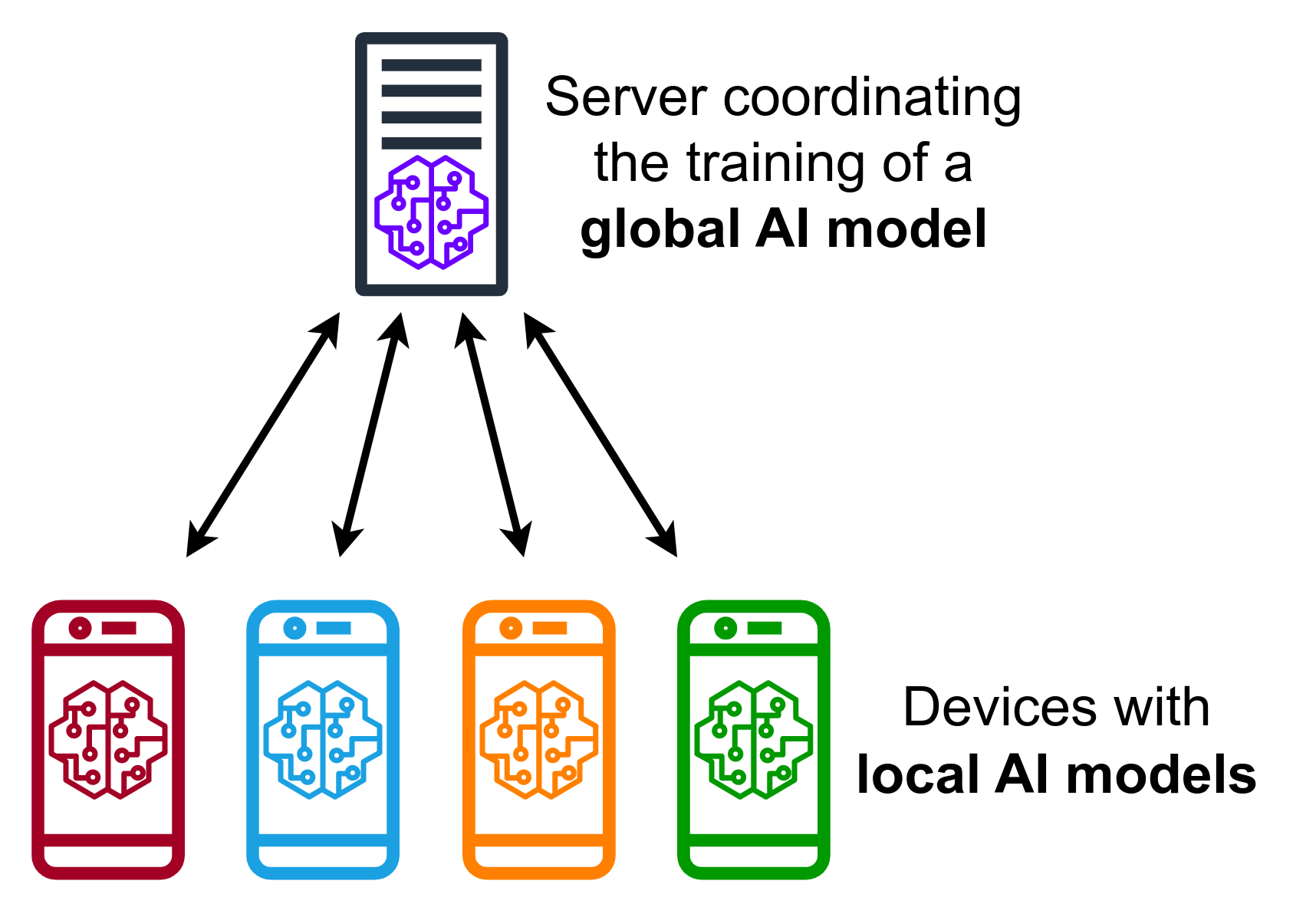

「聯邦學習」(Federated Learning)作為一種新興的處理大數據和隱私保護的技術,其核心思想是什麼?

答案解析

聯邦學習旨在解決數據分散且具有隱私敏感性的場景下的機器學習問題(例如,訓練手機輸入法模型而不收集用戶輸入內容)。其核心方法是:1)

中央伺服器將模型分發到各個本地裝置(如手機)。2) 每個裝置使用自己的本地數據訓練模型,產生模型更新(如梯度)。3) 各裝置只將模型更新(通常經過加密或差分隱私處理)發送回中央伺服器。4)

中央伺服器聚合來自多個裝置的模型更新,產生一個改進後的全域模型,再分發下去。這個過程中,原始數據始終保留在本地,不離開裝置,從而保護了數據隱私。

#41

★★★

在鑑別式模型中,"決策邊界" (Decision Boundary)

指的是什麼?

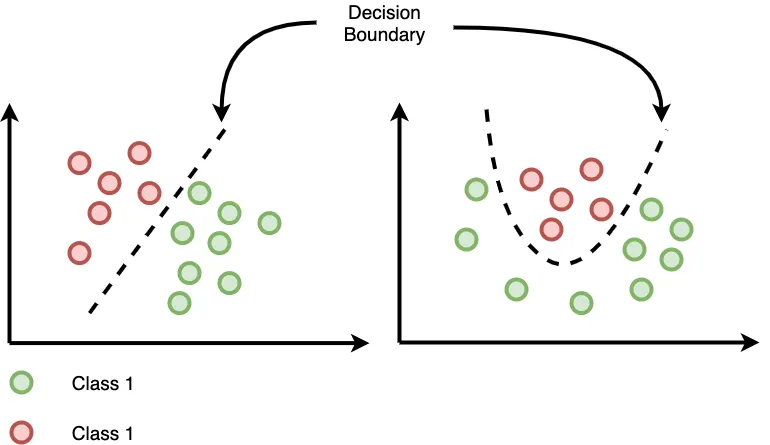

答案解析

鑑別式分類模型的目標是學習如何區分不同的類別。在輸入特徵構成的空間中,模型學習到一個「邊界」,將這個空間劃分成不同的區域,每個區域對應一個預測類別。這個邊界就稱為決策邊界。例如,線性分類器的決策邊界是直線或超平面,而非線性分類器(如SVM配核函數、神經網路)的決策邊界可以是複雜的曲線或曲面。模型根據輸入樣本落在決策邊界的哪一側來進行分類預測。

#42

★★

對於包含大量非結構化圖像數據的大數據集,在將其輸入鑑別式模型(如用於圖像分類的CNN)之前,常見的預處理步驟通常不包含哪項?

答案解析

在訓練圖像鑑別式模型(特別是CNN)時,常見的預處理包括:1)

將不同大小的輸入圖像調整為模型要求的固定尺寸。2) 對像素值進行歸一化或標準化,有助於模型訓練穩定。3) 應用數據增強技術來人工擴充訓練數據集,提高模型的泛化能力和穩健性。而圖像轉換為文字描述(Image

Captioning)本身是一個複雜的 AI 任務(通常涉及CNN+RNN/Transformer),是模型的輸出目標之一,而不是輸入前的預處理步驟。

#43

★★

下列哪個鑑別式模型的核心思想是尋找一個最優超平面,使得不同類別的樣本點到該超平面的距離(Margin)最大化?

答案解析

支持向量機(SVM)的基本原理就是最大化間隔(Margin

Maximization)。它尋找一個能夠將不同類別數據點分開的決策邊界(超平面),並且使得距離這個邊界最近的數據點(稱為支持向量,Support

Vectors)到邊界的距離盡可能大。這個最大化的間隔有助於提高模型的泛化能力。邏輯迴歸是基於 Sigmoid 函數預測機率。決策樹是基於一系列規則進行分裂。Naive

Bayes 是基於貝氏定理和獨立性假設。

#44

★★★

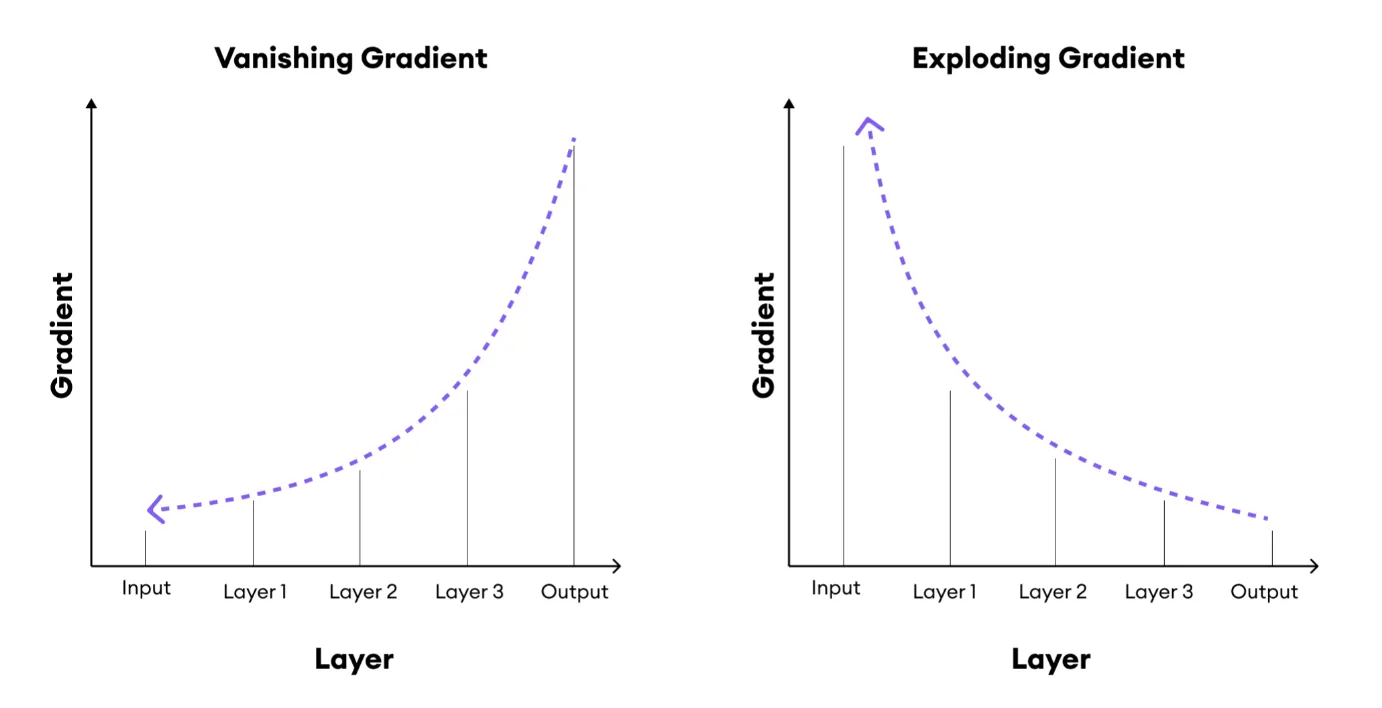

當使用大數據訓練非常深的鑑別式神經網路時,可能會遇到梯度消失(Vanishing Gradients)或梯度爆炸(Exploding

Gradients)的問題。下列哪項技術主要用於緩解這些問題?

答案解析

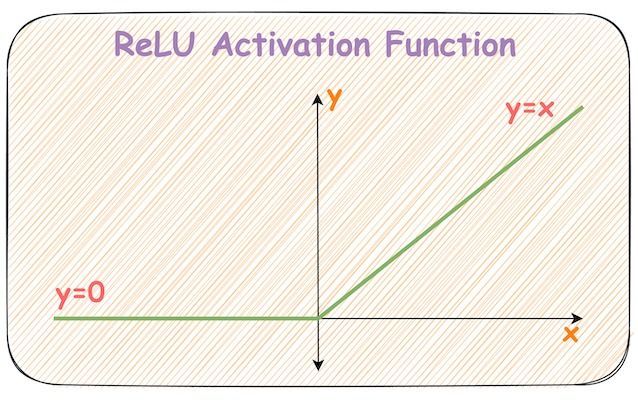

梯度消失/爆炸是在訓練深度神經網路時,梯度在反向傳播過程中變得過小或過大,導致網路難以訓練(權重更新緩慢或不穩定)的問題。解決方法包括:1)

使用如 ReLU(Rectified Linear

Unit)這樣在正區間梯度為1的活化函數,替代容易飽和的 Sigmoid 或 Tanh。2)

引入殘差連接(如 ResNet),允許梯度直接跳層傳播。3) 使用批次正規化,穩定每層輸入的分佈。4) 梯度裁剪(Gradient

Clipping)限制梯度大小。選項 A、B、D 都是數據表示或降維技術,與緩解梯度問題無直接關係。

#45

★★★★

在需要處理極度不平衡的大數據分類任務中(例如,罕見疾病檢測),哪個評估指標對於評估模型找出所有正例(例如,所有患病者)的能力最為關鍵?

答案解析

召回率(Recall)衡量的是所有實際為正例的樣本中,被模型正確預測為正例的比例(Recall = TP / (TP + FN),其中 TP

是真陽性,FN 是偽陰性)。在像罕見疾病檢測這樣的應用中,漏掉一個真正的病例(偽陰性)的代價可能非常高。因此,最大化召回率(即盡可能找出所有真正的正例)通常是首要目標,即使這可能犧牲一些精確率(Precision,即預測為正例的樣本中有多少是真正例,Precision = TP / (TP + FP))。準確率在不平衡數據下有誤導性。特異度衡量找出所有負例的能力。

#46

★★

銀行利用大量交易流水數據訓練鑑別式模型,來識別可能為洗錢的可疑交易模式,這屬於大數據在鑑別式AI的哪個應用領域?

答案解析

反洗錢(AML)是金融機構重要的合規要求。由於交易量巨大,人工審查效率低下。利用機器學習(特別是鑑別式模型,如分類器或異常檢測模型)分析海量交易數據,識別與已知洗錢模式相似或偏離常規的交易行為,可以有效提升可疑交易偵測的效率和準確性,幫助機構滿足監管要求並打擊金融犯罪。

#47

★★

當使用來自網路爬蟲或使用者生成內容的大數據訓練鑑別式模型時,常見的資料品質問題「重複數據」(Duplicate

Data)可能導致什麼後果?

答案解析

數據集中存在大量重複記錄會帶來幾個問題。首先,它會不成比例地增加某些樣本在訓練中的權重,可能導致模型過度擬合這些重複樣本的特性,降低泛化能力。其次,如果在劃分訓練集和測試集時沒有妥善處理,可能導致同一樣本同時出現在兩者中,使得模型評估結果(如測試集準確率)過於樂觀,無法真實反映模型在新數據上的表現。因此,在數據前處理階段進行去重是一個重要的步驟。

#48

★★★

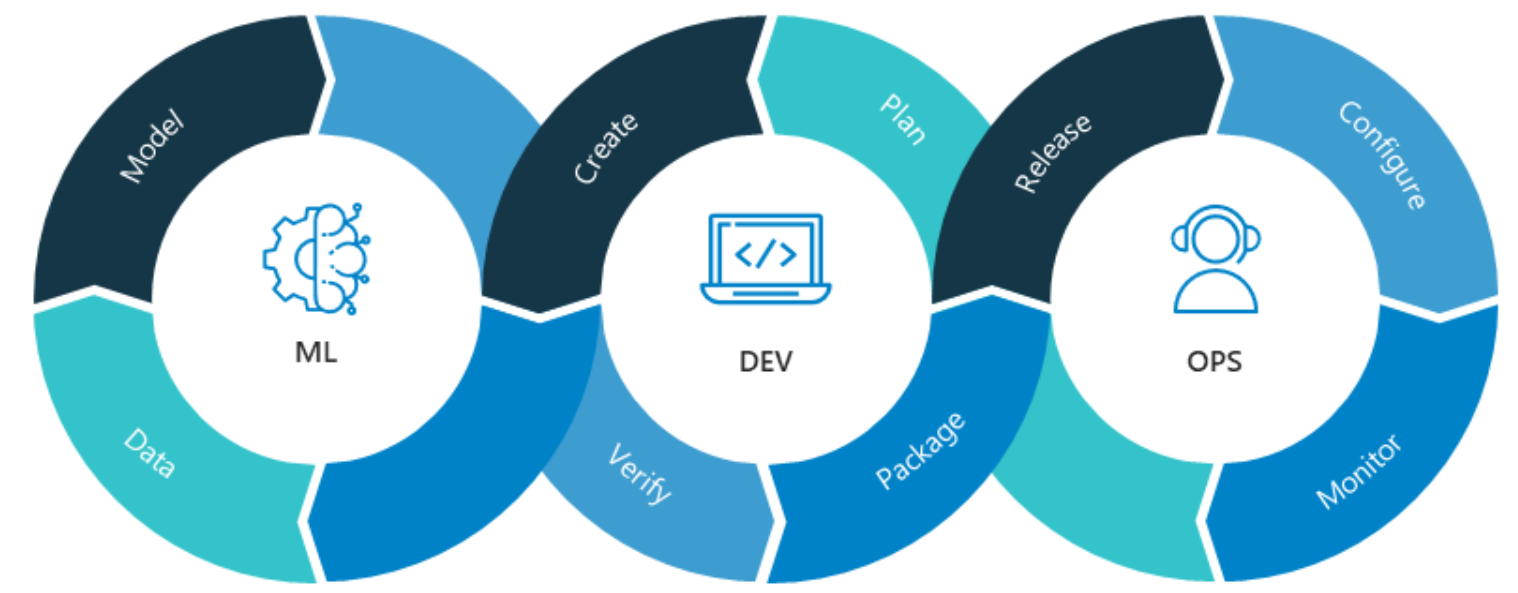

MLOps(Machine Learning Operations)的概念對於管理大數據驅動的鑑別式AI應用生命週期至關重要,它主要關注的是?

答案解析

MLOps 借鑒了軟體工程中 DevOps 的思想,旨在將機器學習模型的開發、測試、部署、監控和管理流程化、自動化和標準化。在大數據和動態環境下,模型需要持續監控效能、處理數據漂移、進行再訓練和重新部署。MLOps

強調開發團隊和維運團隊的協作,利用工具和實踐來管理整個機器學習生命週期,確保模型的可靠性、可擴展性和可維護性,而非僅僅關注模型開發本身。

#49

★

相較於傳統的資料分析方法,使用鑑別式 AI 處理大數據的主要動機通常是為了?

答案解析

傳統的資料分析方法(如統計分析、商業智慧 BI)可能難以應對大數據的規模(Volume)、多樣性(Variety)和速度(Velocity),並且可能需要大量手動規則定義或特徵工程。鑑別式 AI

模型,特別是深度學習等方法,能夠自動從原始大數據中學習複雜的模式和高階特徵,進行準確的預測和分類,處理非結構化數據,並能透過分散式計算進行擴展。其主要動機是利用 AI

的學習能力來應對大數據的挑戰並發掘其價值。AI 主要發現關聯性,不保證找到因果關係。

#50

★★

當鑑別式模型在大數據上訓練完成並部署後,為何需要持續監控其在實際應用中的效能?

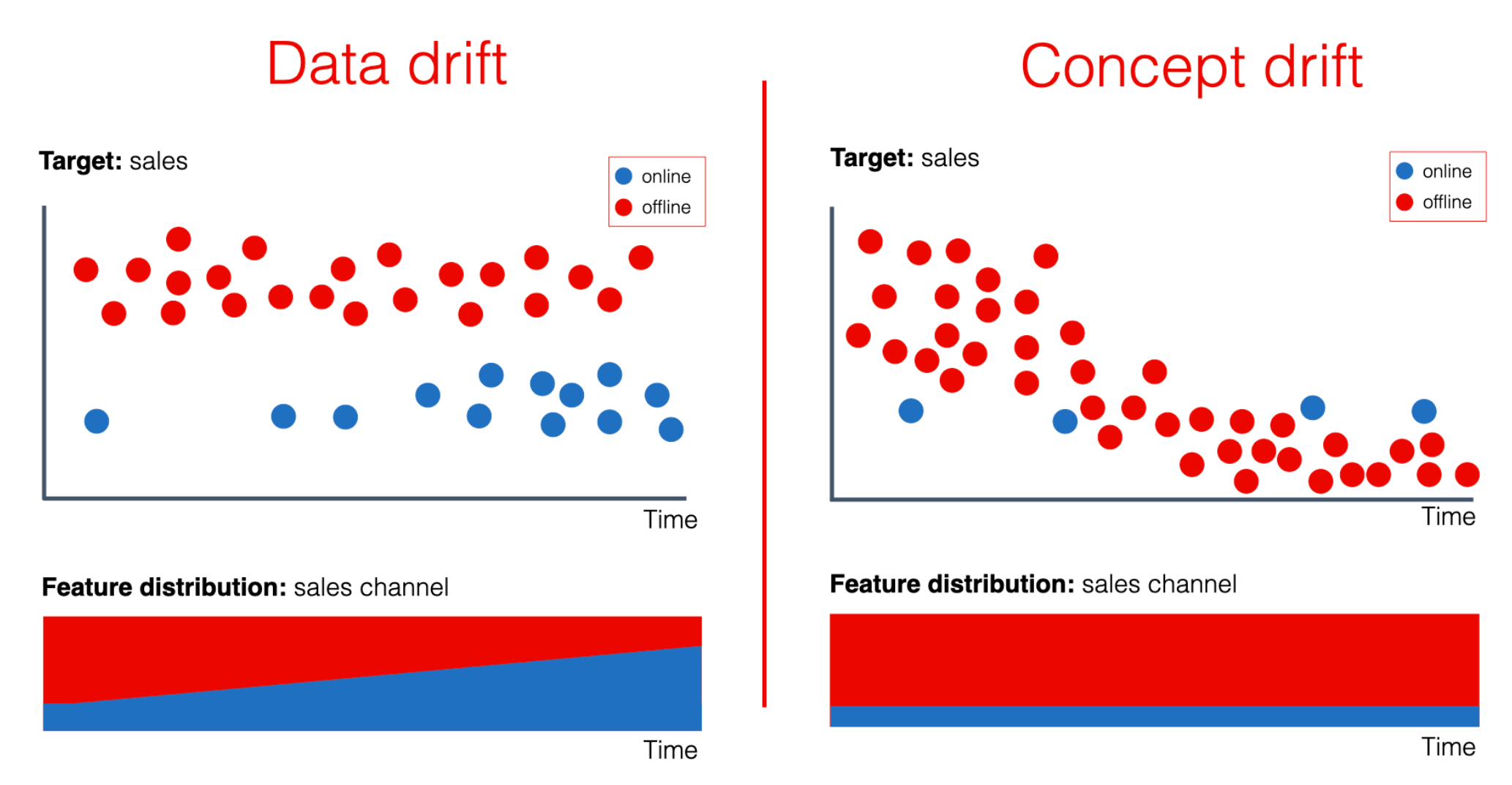

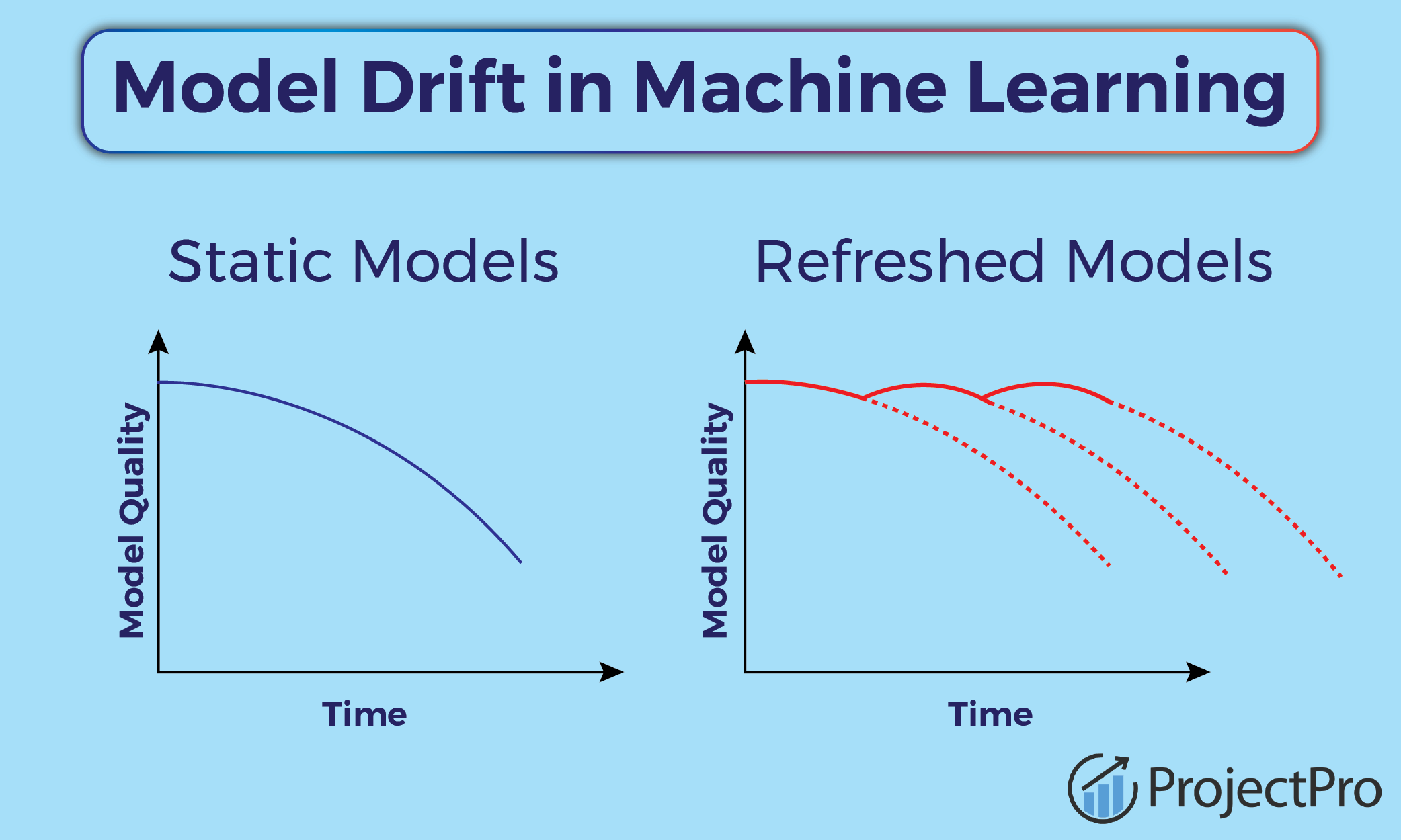

答案解析

模型在訓練時所用的數據是過去某個時間點的快照。然而,真實世界的環境是動態變化的,使用者行為、市場趨勢、外部事件等都可能導致輸入數據的統計特性隨時間發生變化,這種現象稱為「資料漂移」(Data

Drift)或「概念漂移」(Concept Drift)。當實際應用的數據分佈與訓練數據分佈不再一致時,原本表現良好的模型效能可能會逐漸下降。因此,需要持續監控模型在生產環境中的關鍵效能指標(如準確率、AUC、延遲等)以及數據分佈的變化,以便及時發現問題並觸發模型的再訓練或更新。

↑