iPAS AI應用規劃師 經典題庫

L21104 多模態人工智慧應用

出題方向

1

多模態人工智慧基本概念與定義

2

常見的多模態資料類型與特性

3

多模態資料融合技術

4

多模態表徵學習

5

跨模態生成與轉換

6

常見的多模態模型架構

7

多模態人工智慧的應用場景

8

多模態人工智慧的挑戰與未來趨勢

#1

★★★★★

下列關於多模態人工智慧(Multi-Modal AI)的描述,何者最為正確?

答案解析

多模態人工智慧的核心特徵是其處理和整合多源異質數據的能力。「模態」指的是數據的類型或來源,例如文字(Text)、圖像(Image)、音訊(Audio)、影片(Video)、生理訊號(Physiological Signals)、感測器數據(Sensor Data)等。其目標是讓AI更接近人類透過多種感官(模態)感知世界的方式,從而做出更全面、更準確的判斷或生成更豐富的內容。選項A描述的是單模態AI。選項C描述的是一種學習範式,多模態AI可應用於多種範式。選項D描述的是傳統AI方法,與現代基於機器學習的多模態AI不同。

#2

★★★★

以下何者是多模態資料最典型的範例?

答案解析

多模態資料的定義是包含至少兩種不同形式或來源的數據。選項A是單一的文字模態。選項B是單一的時間序列模態。選項D是單一的圖像模態(雖然數據量大,但類型單一)。選項C則明顯包含多種模態:視覺(畫面內容)、聽覺(人物對話、背景音樂)以及可能隱含的文字模態(如字幕或劇本)。因此,電影片段是多模態資料的典型範例。

#3

★★★★

在多模態資料融合策略中,「晚期融合」(Late Fusion)的主要操作方式為何?

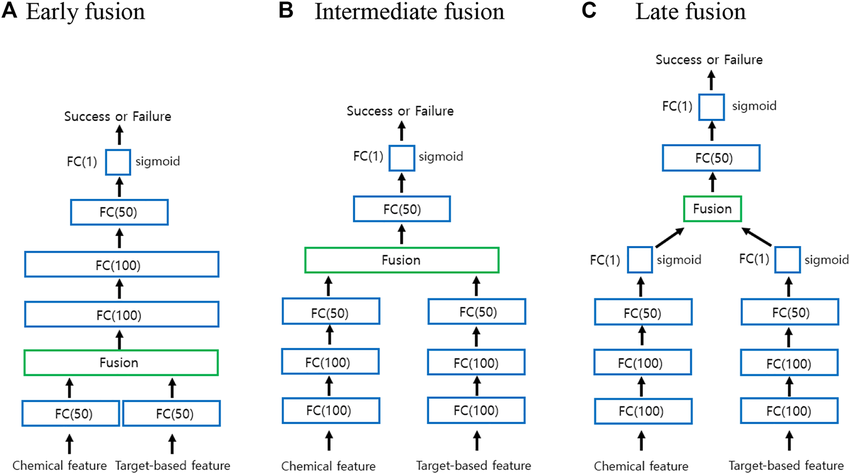

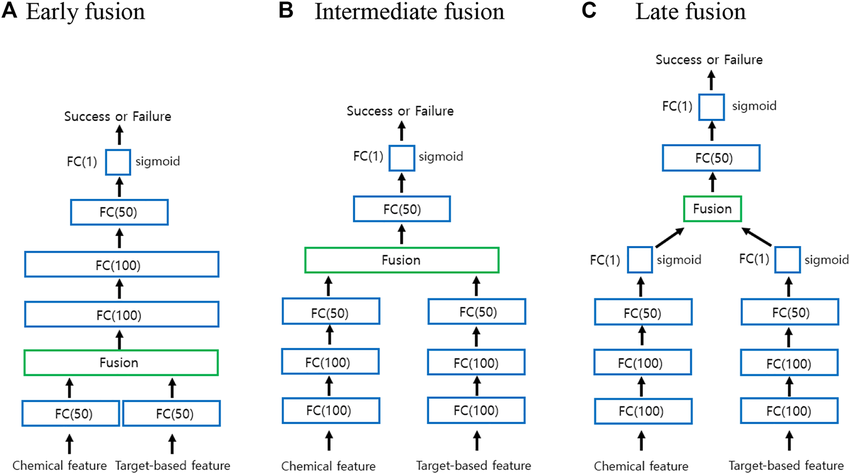

答案解析

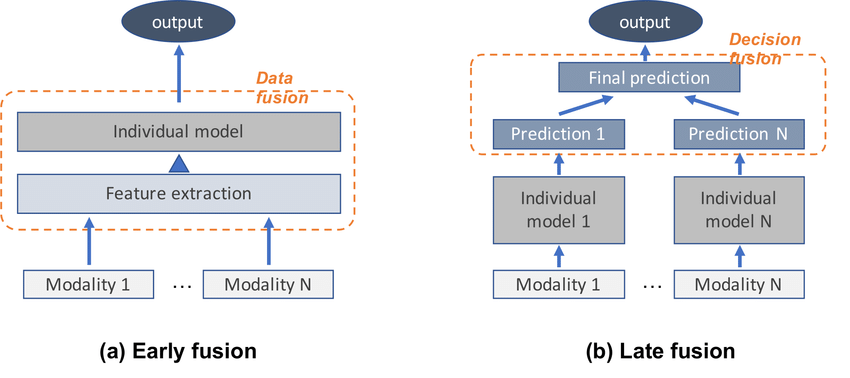

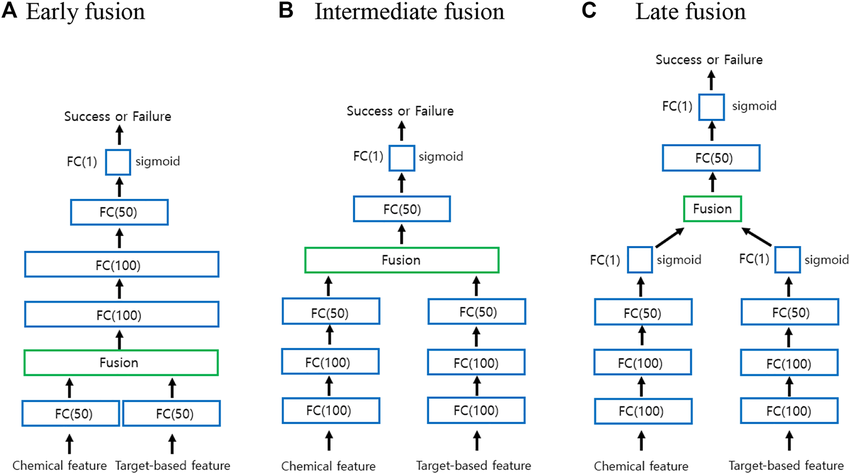

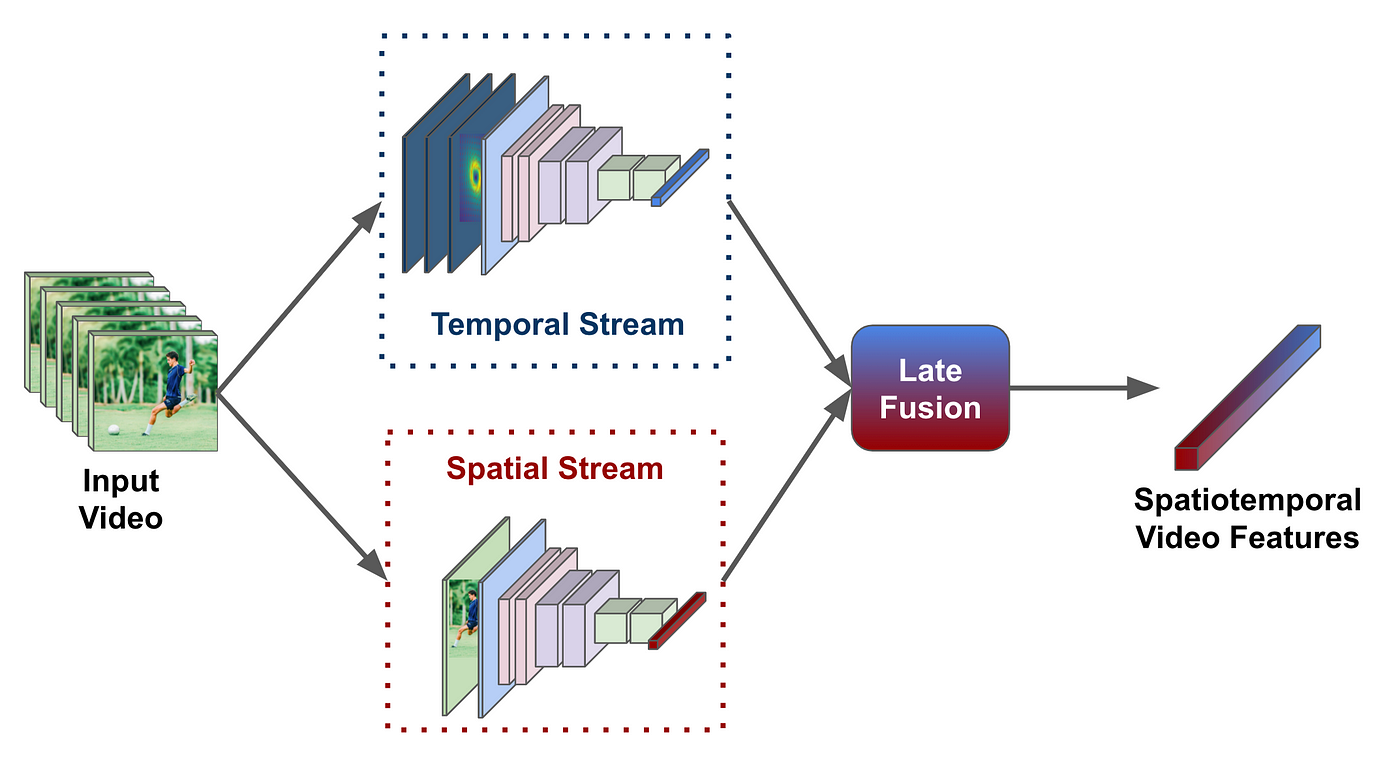

晚期融合,也稱為決策層融合(Decision-level Fusion),其核心思想是先讓各個模態「獨立思考」(訓練獨立模型),最後再匯總意見(整合預測結果)。常見的整合方式包括投票(voting)、取平均(averaging)、加權平均(weighted averaging)或使用另一個元學習器(meta-learner)來結合預測。這種方法的優點是實現簡單,對模態間的同步性要求不高,且容易處理模態缺失。缺點是可能忽略了模態間在早期或中期的交互資訊。選項A描述的是早期融合(Early Fusion)。選項C描述的是中間/混合融合(Intermediate/Hybrid Fusion)。選項D描述的是一種常用於融合的技術,但不是晚期融合的定義。

#4

★★★★★

多模態表徵學習(Multi-Modal Representation Learning)的核心目標是?

答案解析

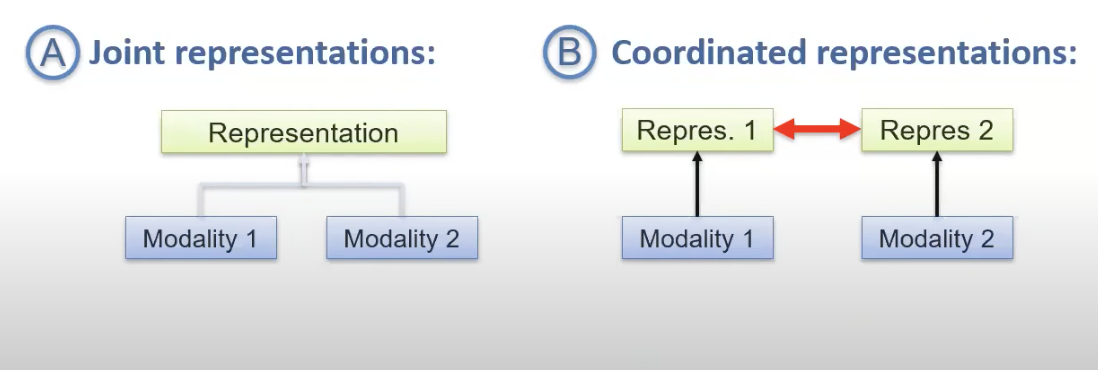

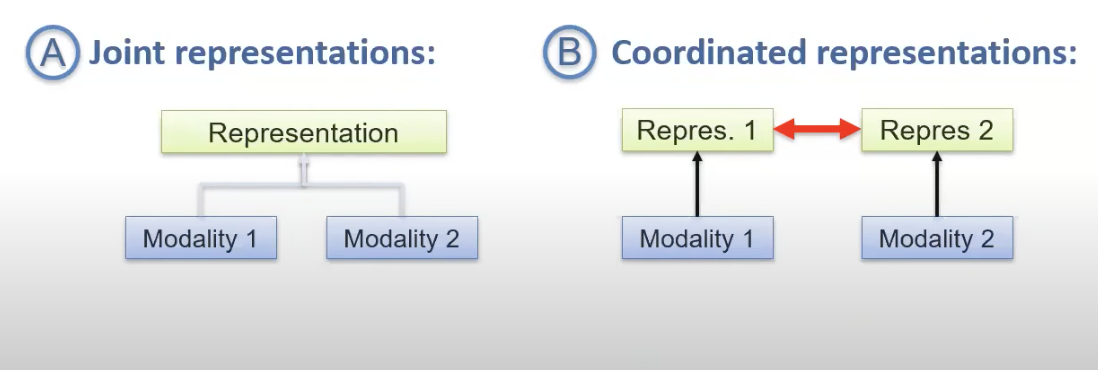

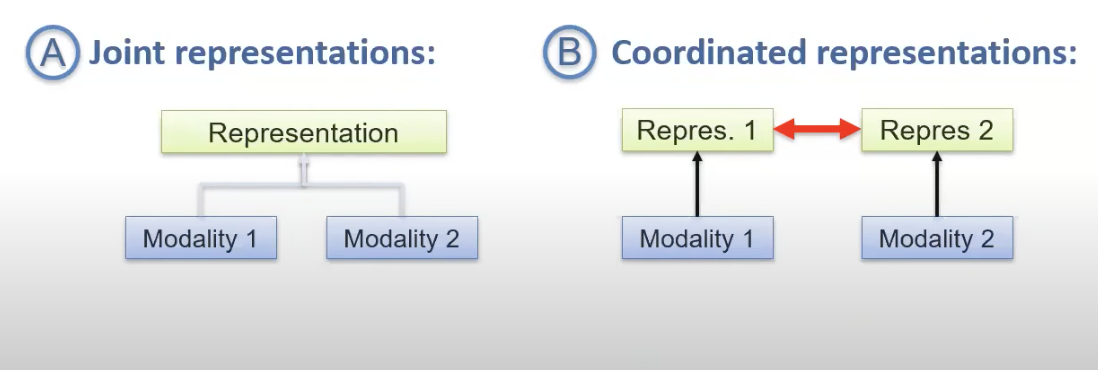

多模態表徵學習的目的是將來自不同模態的原始數據,映射到一個或多個潛在的向量空間中,使得這些向量(表徵)能夠有效地捕捉各模態自身以及模態之間的關聯性和互補性資訊。理想的表徵空間應該有助於下游任務(如分類、檢索、生成等)。這通常涉及學習一個共享的空間(Shared Space),讓語意相關的不同模態數據點在該空間中彼此靠近;或是學習協調的空間(Coordinated Spaces),使得不同模態的表徵之間存在明確的對應或轉換關係。其核心在於「整合跨模態資訊」。

#5

★★★★

下列哪項任務最能直接體現多模態人工智慧的應用價值?

答案解析

多模態AI的價值在於整合不同來源的資訊以達成單一模態難以完成或效果不佳的任務。選項A(醫學影像分析)主要是單一圖像模態。選項B(語音翻譯)雖然涉及語音和文字,但更側重於序列轉換。選項D(音樂情感分析)主要是單一音訊模態。選項C(基於圖文的商品推薦)則需要同時理解圖像內容和文字描述,並將兩者結合起來才能做出精準的推薦,是典型的需要融合圖像和文字兩種模態資訊的多模態應用。

#6

★★★★

目前流行的文字生成圖像(Text-to-Image Generation)模型(如DALL-E, Midjourney)主要屬於多模態AI中的哪一個研究方向?

答案解析

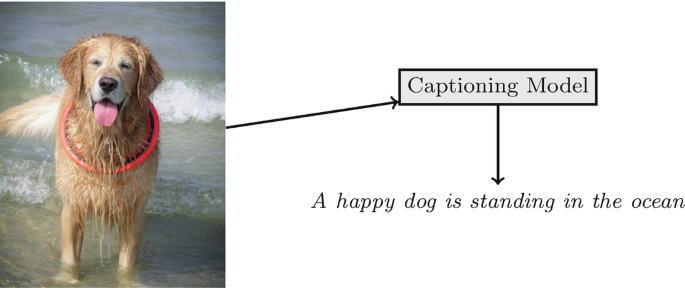

跨模態生成(或稱跨模態翻譯、跨模態轉換)指的是利用一種或多種模態的資訊來生成另一種模態的數據。文字生成圖像任務接收文字描述作為輸入,生成符合描述的圖像作為輸出,是典型的從文字模態生成圖像模態的跨模態生成任務。反之,圖像描述生成(Image Captioning)則是從圖像模態生成文字模態。

#7

★★★★★

近年來在視覺-語言(Vision-Language)任務上取得突破性進展,很大程度上得益於哪種深度學習模型架構的引入與改進?

答案解析

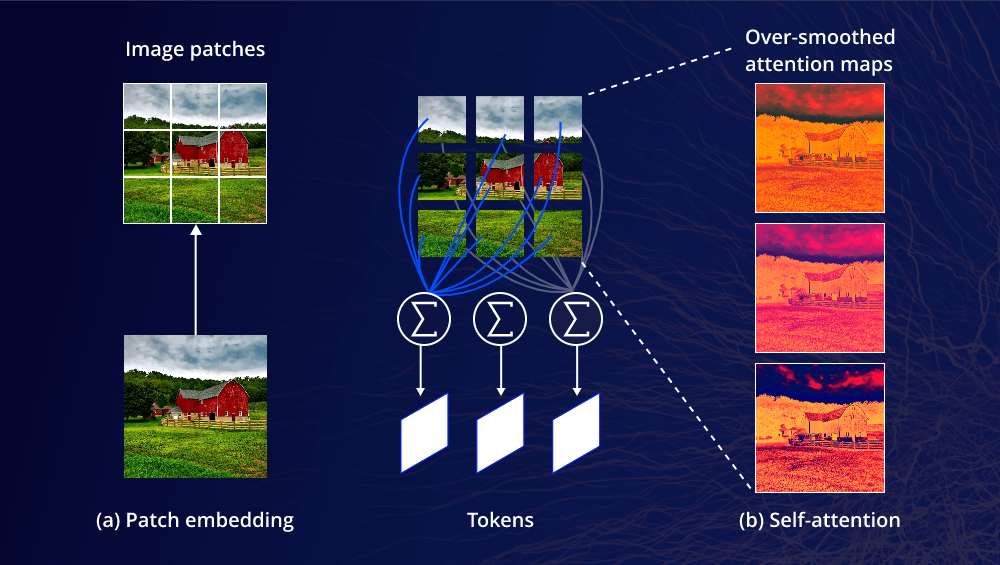

Transformer模型最初在自然語言處理(Natural Language Processing, NLP)領域取得巨大成功,其核心的自注意力機制(Self-Attention)能夠有效捕捉序列內的長距離依賴關係。研究人員很快發現,這種架構同樣適用於處理多模態數據,特別是視覺和語言的結合。透過設計不同的注意力機制(如交叉注意力 Cross-Attention)來實現模態間的資訊交互,基於Transformer的模型(如BERT之後的ViLBERT, LXMERT, UNITER, VisualBERT, 以及CLIP, DALL-E等)在視覺問答(VQA)、圖像描述生成、視覺推理、跨模態檢索等任務上都取得了顯著優於先前基於CNN+RNN組合架構的成果。

#8

★★★

多模態人工智慧研究與應用中,普遍面臨的一大挑戰是?

答案解析

異質性是多模態數據的核心特性與挑戰。不同模態的數據在以下方面可能存在巨大差異:(1) 數據結構(如圖像的網格結構 vs. 文字的序列結構 vs. 音訊的時頻結構);(2) 統計特性與分佈;(3) 時間/空間尺度與解析度;(4) 資訊密度與雜訊模式;(5) 數據維度。如何有效地處理這些異質性,實現跨模態的資訊對齊、融合與協同學習,是多模態AI領域的核心難題。

#9

★★★

與晚期融合(Late Fusion)相比,早期融合(Early Fusion)的主要潛在優勢是?

答案解析

早期融合(或稱特徵層融合 Feature-level Fusion)通常在模型的輸入層或靠近輸入層的地方,將不同模態提取出的特徵向量進行結合(如串接、加總、元素乘積等),然後一起送入後續的共享處理層。這樣做的主要優勢在於,模型從一開始就能接觸到所有模態的資訊,有機會學習到模態之間在較低抽象層次上的細微關聯和交互作用,這對於某些需要緊密模態協同的任務可能是有利的。然而,其缺點是對數據同步性、維度匹配要求高,且不易處理模態缺失,融合方式也相對簡單直接。

#10

★★★★

在多模態學習中,「對齊」(Alignment)這個概念通常指的是什麼?

答案解析

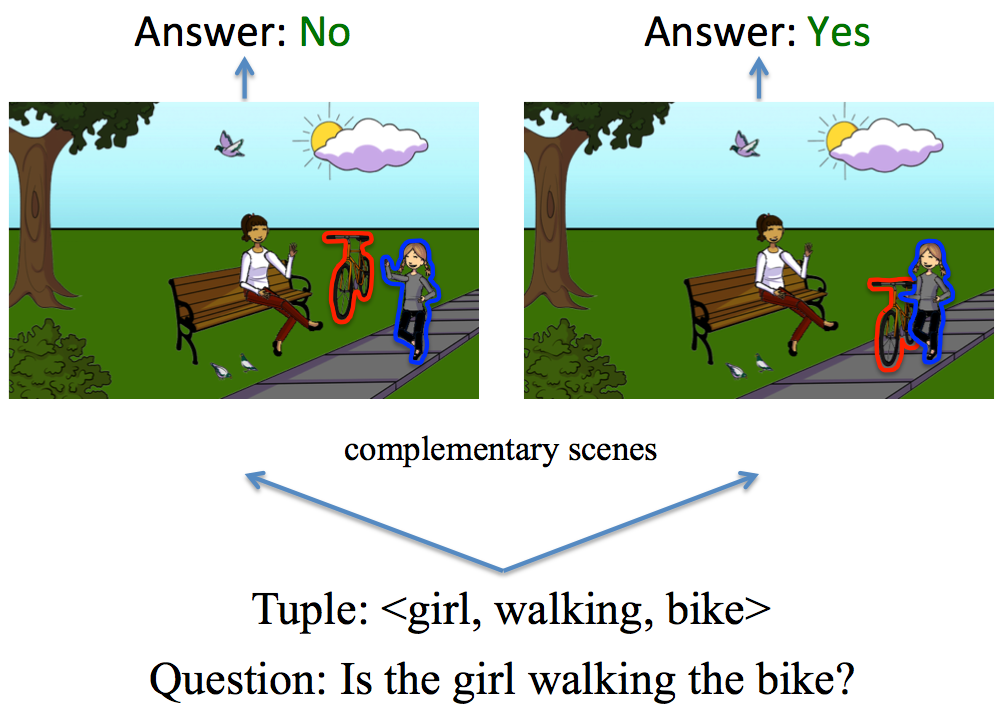

多模態對齊旨在建立不同模態數據之間的聯繫。這可以是在實例層面(Instance-level),例如判斷一張圖片和一段文字是否描述同一件事物;也可以是在更細粒度的子元件層面(Sub-component-level),例如將食譜中的一個步驟文字與教學影片中對應的操作畫面片段對應起來,或者將圖片中的某個物體區域與描述該物體的詞語對應起來。對齊是實現更深層次多模態理解和融合的基礎。

#11

★★★

除了常見的文字、圖像、音訊、影片外,以下何者也可能在特定應用中被視為一種獨立的「模態」?

答案解析

「模態」指的是數據的來源、形式或感官通道。生理訊號(如心電圖ECG、腦電圖EEG、心率HRV等)是獨立於傳統視聽模態的一種重要數據來源,尤其在健康照護、人機互動等領域。它們提供了關於個體生理狀態的獨特資訊,可以與其他模態(如影片中的表情、語音中的聲調)結合進行分析。選項A、C、D描述的是模型訓練過程中的超參數、元數據或模型本身的參數,而非輸入數據的模態。

#12

★★★★

在自動駕駛汽車的感知系統中,融合光學雷達(LiDAR)點雲數據、攝影機影像和雷達(RADAR)信號來偵測和追蹤周圍物體,是利用了多模態AI的哪項優勢?

答案解析

不同的感測器(模態)各有優缺點。例如,攝影機提供豐富的顏色和紋理資訊,但在惡劣天氣或光照條件下性能下降;LiDAR能提供精確的3D距離和形狀資訊,但可能受雨霧影響且成本較高;RADAR對距離和速度測量較準確,且不易受天氣影響,但解析度較低。多模態融合的目的就是結合這些不同感測器的優勢,彌補各自的不足(互補性),從而在各種環境下都能獲得更可靠、更全面的環境感知結果,提高自動駕駛系統的安全性與穩定性(穩健性)。

#13

★★★★

OpenAI的CLIP(Contrastive Language–Image Pre-training)模型,其核心訓練思想是利用什麼樣的學習方法?

答案解析

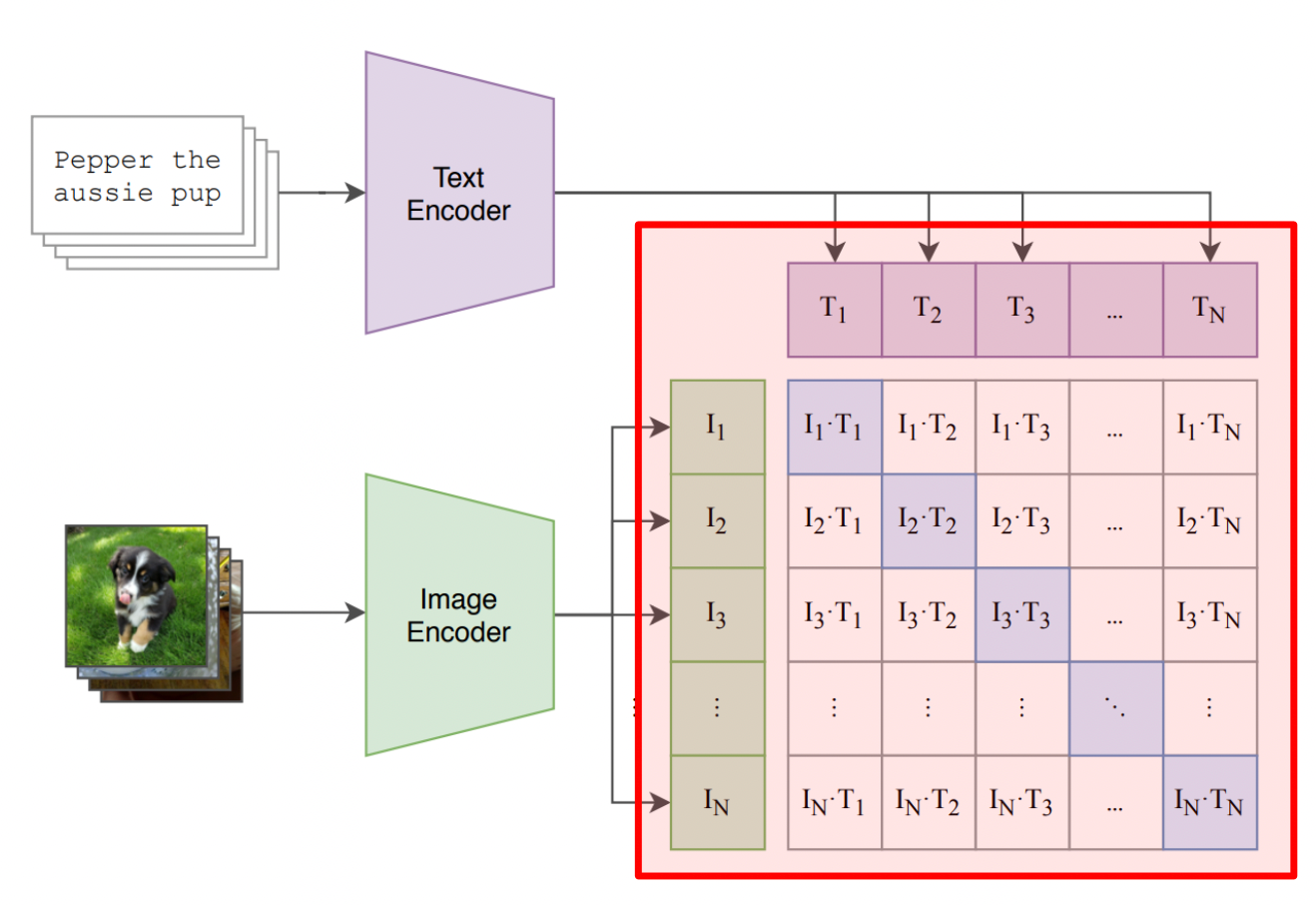

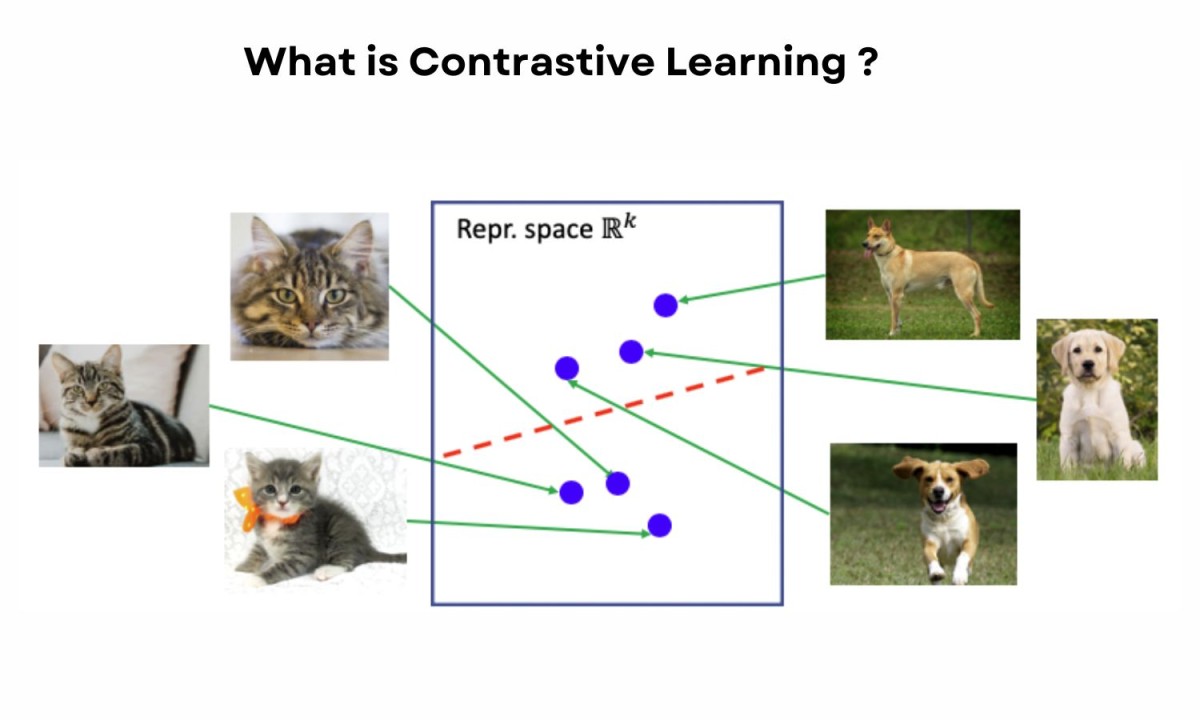

CLIP模型通過在網路上收集的大量(圖像,文字描述)配對數據進行預訓練。其核心目標是學習一個共享的嵌入空間,使得在這個空間中,相互匹配的圖像和文字的嵌入向量之間的相似度(如餘弦相似度)最大化,而不匹配的圖像和文字的嵌入向量之間的相似度則最小化。這種「拉近正樣本,推開負樣本」的學習策略就是對比學習。透過這種方式,CLIP學會了圖像和文字之間豐富的語意關聯,使其在零樣本(zero-shot)圖像分類等任務上表現出色。

#14

★★★

「圖像描述生成」(Image Captioning)任務的輸入和輸出分別是什麼模態?

答案解析

圖像描述生成(Image Captioning)的目標是讓模型「看圖說話」。模型的輸入是一張圖像,模型需要理解圖像中的內容(物體、場景、動作、關係等),然後生成一段通順且語意準確的自然語言文字來描述這張圖像。因此,輸入是圖像模態,輸出是文字模態。選項A描述的是文字生成圖像。選項C描述的是視覺問答(VQA)。選項D描述的是影片摘要。

#15

★★★

在真實世界的多模態數據收集中,經常遇到「模態缺失」(Missing Modalities)問題,這指的是?

答案解析

模態缺失是指在多模態數據集中,並非所有樣本都擁有完整的模態資訊。例如,一個包含影片、音訊和文字的數據集,可能有些樣本只有影片和音訊,缺少文字;有些只有文字;有些則三者皆有。這種數據不完整性在現實場景中非常普遍(例如,用戶上傳的社群媒體內容)。如何設計能夠有效處理甚至利用這種模態缺失情況的模型,是多模態學習的一個重要研究方向。

#16

★★★★

多模態人工智慧與傳統單模態人工智慧最根本的區別在於?

答案解析

區分單模態和多模態AI的核心標準在於其處理的數據類型數量。「模態」即數據的類型或形式。單模態AI專注於處理單一類型的數據,例如僅處理文字的NLP模型,或僅處理圖像的電腦視覺模型。而多模態AI則設計用來同時處理、理解、整合來自至少兩種不同模態的資訊。雖然模型複雜度、數據量和應用領域可能因此產生差異,但最根本的區別在於處理數據的模態數量。

#17

★★★★

在多模態融合技術中,像Transformer這樣利用注意力機制(Attention Mechanism)在模型內部進行多層次模態交互的策略,通常被歸類為哪種融合方式?

答案解析

基於Transformer的多模態模型(如ViLBERT, LXMERT等)通常採用在模型的不同層級(通常是中間的隱藏層)透過特定機制(如交叉注意力Cross-Attention)來實現不同模態特徵之間的深度交互和資訊融合。這種既非在最開始(輸入層)融合,也非在最後(決策層)融合,而是在模型內部進行多步驟、漸進式融合的策略,通常被稱為混合融合或中間融合。它試圖結合早期融合捕捉低階交互和晚期融合處理異質性的優點。

#18

★★★★

學習一個良好的多模態聯合表示(Joint Representation)的主要目的是什麼?

答案解析

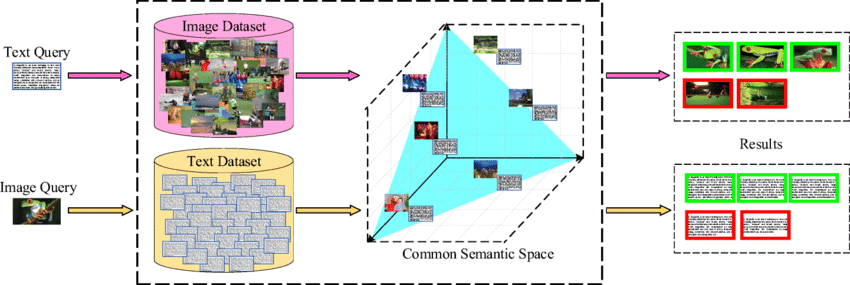

多模態聯合表示(通常在一個共享的潛在空間中)的目標是學習一種能夠同時捕捉來自不同模態資訊的向量表示。在這個共享空間裡,語意相似但來源模態不同的數據點(例如,一張狗的圖片和描述這張圖片的文字"一隻狗在草地上玩耍")應該被映射到相近的位置。這種聯合表示使得模型能夠理解跨模態的關聯,便於執行需要整合多模態資訊的任務,如跨模態檢索(用文字搜圖片)、視覺問答、多模態情感分析等。

#19

★★★

將口語語音直接轉換為另一種語言的口語語音(Speech-to-Speech Translation),涉及到哪幾種模態之間的轉換?

答案解析

語音到語音翻譯(S2ST)的目標是直接將源語言的語音訊號轉換為目標語言的語音訊號,理想情況下是端到端(end-to-end)的轉換,不經過中間的文字表示。因此,這個任務直接涉及從輸入的語音模態到輸出的語音模態的跨模態(也是跨語言)生成。雖然傳統級聯系統(cascaded system)會採用選項A(語音轉文字ASR -> 文字翻譯MT -> 文字轉語音TTS)的方式,但現代S2ST研究趨勢是實現端到端的直接轉換。

#20

★★★★

結合分析一個人的面部表情(視覺)、語音語調(聽覺)和所說的文字內容(文字)來判斷其情緒狀態,屬於多模態AI的哪個應用領域?

答案解析

人類的情感表達是多面向的,會透過臉部表情、聲音語調、肢體語言、以及使用的詞彙等多種管道(模態)流露出來。多模態情感分析旨在利用來自這些不同模態的線索,進行更全面、更準確的情感狀態判斷(如開心、悲傷、憤怒、中性等)。相比只分析文字或只分析表情的單模態方法,多模態方法通常能達到更好的效果,因為不同模態可以提供互補或驗證的資訊。

#21

★★★

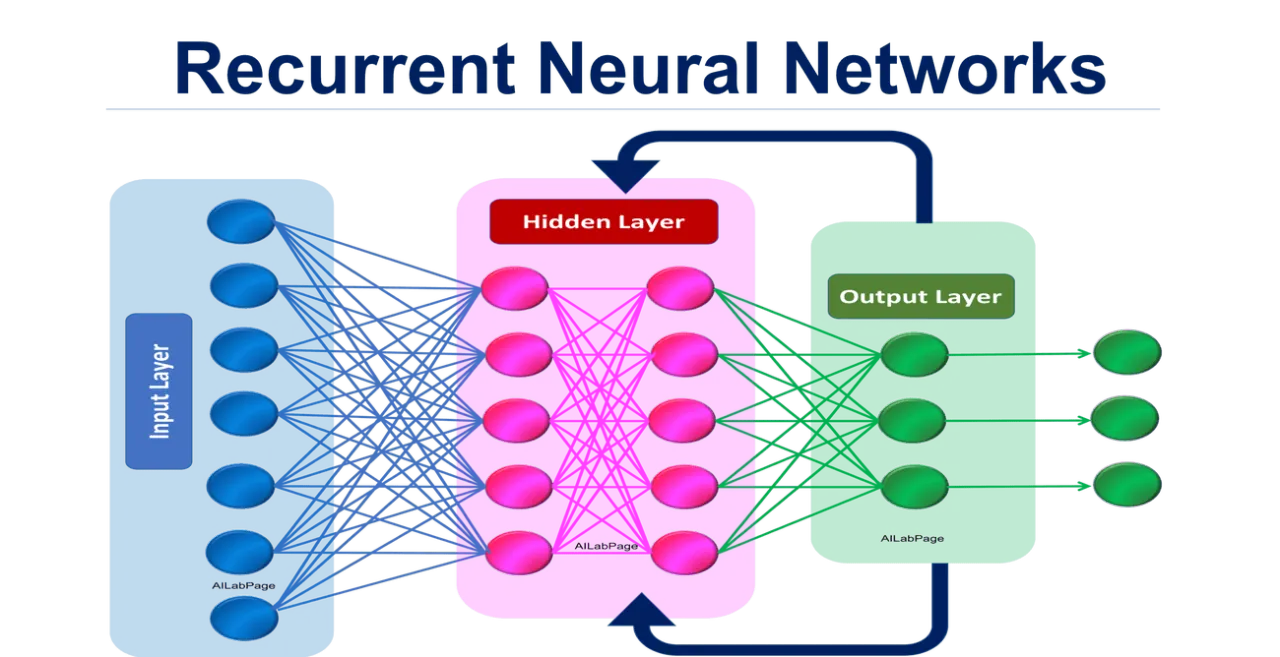

在多模態模型中,常用於提取圖像特徵的基礎網路結構是?

答案解析

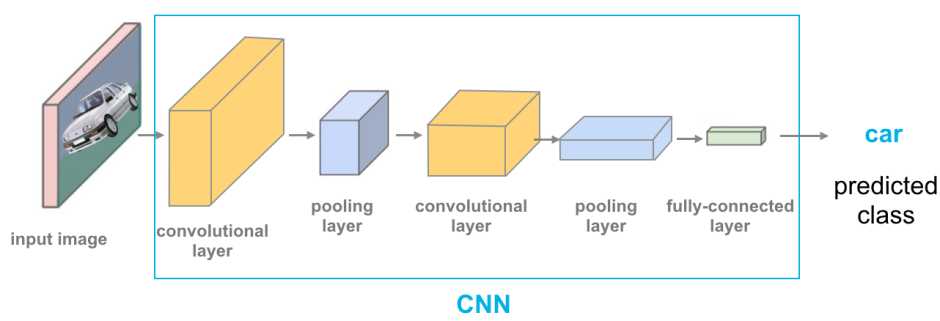

CNN由於其卷積核能夠有效捕捉圖像的局部空間特徵(如邊緣、紋理)並具有權重共享和平移不變性,長期以來一直是電腦視覺領域用於提取圖像表示的主流模型(例如AlexNet, VGG, ResNet, EfficientNet等)。在多模態模型中,通常會先使用預訓練好的CNN(或其變體如Vision Transformer)作為圖像編碼器(Image Encoder)來提取圖像的深層特徵向量,然後再將這些特徵與其他模態的特徵進行融合。RNN主要用於處理序列數據,GNN用於處理圖結構數據。自注意力機制是Transformer的核心,但通常作用於序列或一組特徵之上,而非直接作為圖像特徵提取的基礎結構(Vision Transformer除外,但其內部也借鑒了卷積的思想)。

#22

★★★

相較於結構化數據(如表格數據),圖像、文字、音訊等非結構化數據的主要特性是什麼?

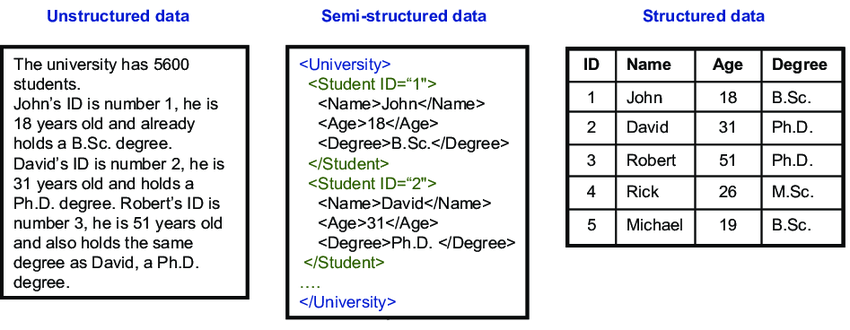

答案解析

結構化數據(Structured Data)通常指存儲在關聯式資料庫表格中的數據,具有固定的欄位和資料類型。而非結構化數據(Unstructured Data)則沒有預先定義的格式或組織結構,例如自由格式的文字文件、圖像像素、音訊波形等。這類數據佔據了現實世界數據總量的大部分,其處理和分析通常需要更複雜的技術(如深度學習)來提取有意義的模式和特徵。多模態AI主要處理的就是這類非結構化或半結構化的數據。

#23

★★★★

多模態人工智慧的發展趨勢之一是朝向「更大、更通用」的模型發展,這主要是為了達成什麼目標?

答案解析

近年來,類似於大型語言模型(Large Language Models, LLMs)的發展,多模態領域也出現了訓練超大規模預訓練模型(Large-scale Pre-trained Models)的趨勢(如CLIP, ALIGN, DALL-E 2, Flamingo, GPT-4等)。這些模型在極其龐大的多模態數據集上進行訓練,學習通用的跨模態知識和表示。其主要目標是獲得強大的泛化能力,使得單一模型無需或只需少量針對性微調(fine-tuning)就能在多種不同的下游多模態任務上取得良好表現,即提升零樣本(zero-shot)或少樣本(few-shot)學習能力。雖然這通常伴隨著高昂的訓練成本和部署挑戰,以及可解釋性問題。

#24

★★★

在多模態研究中,"模態間隙" (Modality Gap) 通常指什麼現象?

答案解析

模態間隙是指由於不同模態數據固有的特性差異(如前述的異質性),導致它們在原始數據空間或經過特徵提取後的表示空間中,其數據分佈存在顯著的差異或「間隔」。例如,圖像特徵向量的分佈可能與文字特徵向量的分佈很不一樣。這個間隙給學習跨模態的共享表示或進行有效的模態融合帶來了挑戰。許多多模態學習方法(如對抗學習、正則化約束等)都在試圖縮小或橋接這個模態間隙。

#25

★★★

將醫學影像(如MRI)與對應的放射科報告文字結合,訓練模型自動生成報告或輔助診斷,是多模態AI在哪個領域的應用?

答案解析

智慧醫療是多模態AI應用的重要場景之一。醫療數據本身就具有多模態特性,包括醫學影像(X光、CT、MRI、超音波等)、病理報告(文字)、電子病歷(文字、結構化數據)、基因序列數據、生理監測信號(時間序列)等。整合這些來自不同模態的資訊,可以幫助AI更全面地理解病情,從而應用於疾病篩檢、輔助診斷、治療效果評估、預後預測、醫學報告自動生成等多方面,提升醫療服務的效率和質量。

#26

★★★

相較於早期和晚期融合,中間融合(Intermediate Fusion)的主要優勢可能在於?

答案解析

中間融合(或混合融合)試圖結合早期融合和晚期融合的優點。它允許在模型的不同深度或抽象層次上進行模態間的資訊交互和融合。例如,可以在淺層融合一些低階特徵,在深層融合更抽象的語意特徵。這種分層次的融合方式被認為可能更靈活,能夠捕捉到不同層次上的模態交互關係,從而可能獲得比單純的早期或晚期融合更好的性能。然而,其設計通常更為複雜。

#27

★★★

在多模態表示學習中,除了學習聯合表示(Joint Representation),另一種常見的策略是學習協調表示(Coordinated Representation),其特點是?

答案解析

與聯合表示(通常追求一個共享空間)不同,協調表示允許不同模態擁有各自獨立的表示空間,但強調這些空間必須是「協調」的,即它們之間存在某種已定義的約束或關係。例如,可以學習一個映射函數,將一個模態的表示轉換到另一個模態的表示空間(如跨模態翻譯);或者要求不同模態表示之間的某種度量(如距離、相似度)滿足特定屬性(如語意相似的對象距離近)。這種策略在處理模態間差異較大或需要保留模態特定資訊時可能更為合適。

#28

★★★★

多模態機器翻譯(Multimodal Machine Translation, MMT)相比傳統的純文字機器翻譯,其主要優勢可能來自於?

答案解析

語言本身常常存在歧義(Ambiguity),即同一個詞語或句子在不同上下文中可能有不同的含義。例如,英文單詞 "bank" 可以指銀行,也可以指河岸。多模態機器翻譯試圖利用與待翻譯文字相關聯的其他模態資訊(主要是圖像),來幫助模型更好地理解文字的真實語意,從而生成更準確、更符合上下文的翻譯。例如,如果句子 "I went to the bank" 配有一張河邊的圖片,模型就應該將 "bank" 翻譯成「河岸」而非「銀行」。這種利用視覺資訊輔助消歧是MMT的核心思想。

#29

★★★

在處理序列性數據(如文字、語音、時間序列)時,除了Transformer,哪類神經網路模型也常被用作多模態模型中的序列編碼器?

答案解析

RNN及其改進版本長短期記憶網路(Long Short-Term Memory, LSTM)和門控循環單元(Gated Recurrent Unit, GRU)被設計用來處理序列數據,因為它們具有內部記憶狀態,能夠捕捉序列中的時間依賴關係。在Transformer流行之前,RNN/LSTM/GRU是處理文字、語音等序列模態的主流編碼器選擇,常與CNN(用於圖像)結合構成多模態模型。雖然Transformer在許多任務上表現更優,但RNN及其變體在某些場景下仍然有其應用價值,或者作為模型的一部分。MLP是基本的前饋網路。RBFN和SVM是其他類型的機器學習模型。

#30

★★

多模態人工智慧模型的可解釋性(Interpretability)通常比單模態模型更具挑戰性,主要原因可能包括?

答案解析

多模態模型由於需要同時處理來自不同模態的資訊,並學習它們之間複雜的交互和融合模式,其內部運作機制往往比只處理單一模態的模型更加複雜和難以理解。例如,要知道模型最終的決策是基於哪個模態的哪個部分,以及不同模態是如何相互影響的,通常需要更專門的可解釋性分析技術(如多模態注意力圖、跨模態影響分析等)。因此,理解和解釋多模態模型的決策過程是一個重要的研究挑戰。

#31

★★

“模態”(Modality)一詞在人工智慧領域,最貼切的比喻是人類的什麼?

答案解析

多模態AI的發展很大程度上受到人類如何感知世界的啟發。人類透過不同的感官通道(視覺、聽覺、觸覺、嗅覺、味覺)接收來自外界的不同形式的資訊,並在大腦中進行整合以形成對世界的全面認知。在AI中,「模態」就類似於這些感官通道,指的是數據的特定類型或來源,如圖像(對應視覺)、音訊(對應聽覺)、文字(對應語言理解)等。多模態AI的目標就是模仿人類整合多感官資訊的能力。

#32

★★

在處理影片數據時,除了視覺畫面本身,通常還包含哪種重要的時間序列模態?

答案解析

影片數據本質上就是多模態的。它主要包含隨時間變化的視覺畫面序列(視覺模態),同時幾乎所有影片都伴隨著音訊軌道(聽覺模態),其中可能包含語音、音樂、環境音效等。此外,影片還可能包含文字模態(如字幕、標題)。因此,音訊是影片數據中除視覺外最常見且重要的伴隨模態。

#33

★★

如果一個多模態系統在缺乏某個模態輸入時,仍然能夠利用其餘模態產生合理的輸出,這體現了該系統在哪方面的優勢?

答案解析

模態缺失是實際應用中常見的問題。一個設計良好的多模態系統應該能夠在部分模態數據不可用時,依然能夠穩定地工作,並利用剩餘的模態資訊盡可能地完成任務。這種在輸入數據不完整情況下仍能保持一定性能的能力,稱為對模態缺失的穩健性。不同的融合策略對模態缺失的穩健性不同,例如晚期融合通常比早期融合更容易處理模態缺失。

#34

★★★

在多模態表示學習中,使用如Triplet Loss或Contrastive Loss等損失函數的主要目的是?

答案解析

對比學習(Contrastive Learning)是多模態表示學習中常用的自監督或弱監督學習方法。其核心思想是學習一個度量空間(metric space),使得在這個空間中,來自不同模態但語意相關(正樣本對,positive pairs)的數據點的表示向量距離更近,而語意不相關(負樣本對,negative pairs)的數據點的表示向量距離更遠。Triplet Loss(三元組損失)和Contrastive Loss(對比損失)等就是為實現這一目標而設計的損失函數,它們通過懲罰正樣本對距離過遠或負樣本對距離過近的情況來引導模型學習有意義的跨模態表示。

#35

★★

將一段文字描述(如“一隻貓坐在窗台上”)轉換為對應的3D模型,這屬於哪一類的跨模態任務?

答案解析

跨模態生成任務的核心是從一種模態生成另一種模態。在這個例子中,輸入是文字模態(描述),輸出是3D模型(一種視覺/幾何模態)。因此,這是一個典型的文字到3D模型生成的跨模態任務。隨著3D內容需求的增加(如元宇宙、遊戲、設計等),Text-to-3D也成為一個新興且活躍的研究方向。

#36

★★★★

像Google的LaMDA或OpenAI的GPT-4這類大型語言模型(LLM)開始展現出處理圖像等多模態輸入的能力,這表明了模型架構正在朝哪個方向發展?

答案解析

最初的大型語言模型主要處理純文字輸入和輸出。然而,近期的發展(如GPT-4可以接受圖文混合輸入)顯示,這些強大的基礎模型正在被擴展以處理和理解多種模態。這意味著AI模型架構正在從專精於單一模態向著能夠理解和生成多種模態內容的「多模態通用模型」或「大型多模態模型」(Large Multimodal Models, LMMs)的方向發展,這被認為是通向更通用人工智能(AGI)的重要一步。

#37

★★★

在人機互動(Human-Computer Interaction, HCI)領域,利用多模態AI分析使用者的語音指令、手勢和眼動追蹤數據,可以實現什麼目標?

答案解析

傳統的人機互動主要依賴鍵盤、滑鼠等單一或有限的輸入方式。多模態互動(Multimodal Interaction)則允許使用者同時使用多種自然的溝通管道(如語音、手勢、眼神、表情等)與電腦系統互動。透過多模態AI分析和理解這些來自不同模態的輸入信號,系統可以更準確地把握使用者的意圖,提供更靈活、更符合人類自然交流習慣的互動方式,從而提升互動的效率和使用者體驗。

#38

★★★★

訓練大型多模態模型需要海量的標註數據,例如(圖像,文字描述)配對。獲取這些數據的主要挑戰是什麼?

答案解析

雖然大型多模態模型在性能上取得了巨大進步,但其成功很大程度上依賴於大規模、高質量的標註數據。然而,創建這樣數據集的成本非常高。例如,為數十億張圖片提供精確的文字描述,需要大量的人力投入和時間成本。此外,從網路爬取的數據往往帶有噪音(如不準確的描述、錯誤的配對),並且可能繼承了網路數據中存在的社會偏見(Social Bias)。如何高效地獲取高質量、大規模、多樣化且偏差較小的多模態數據,是該領域持續面臨的一大挑戰。這也推動了自監督學習(Self-supervised Learning)和弱監督學習(Weakly-supervised Learning)等技術的發展。

#39

★

「單峰」(Unimodal)是相對於「多模態」(Multimodal)而言,它指的是?

答案解析

在多模態AI的語境下,「單峰」或「單模態」(Unimodal)是指系統或任務只涉及一種數據類型或來源。例如,一個只做圖像分類的模型是單模態(視覺)模型,一個只做語音辨識的系統是單模態(聽覺)系統。這個術語是用來與處理多種數據類型的「多模態」系統進行對比。

#40

★★★

以下哪種數據類型本質上不直接表示物理世界的感官訊息,但在多模態分析中常與感官模態結合使用?

答案解析

模態通常指感官通道(視、聽、觸等)或數據的固有形式(文字、圖像)。用戶的個人資料,如年齡、性別、職業、地點等,屬於結構化或半結構化的元數據(Metadata),本身不直接是感官訊息。然而,在許多應用中(如個性化推薦、用戶行為分析),這些元數據常被視為一種額外的「模態」或輔助訊息,與感官模態(如用戶觀看的影片、聽的音樂、瀏覽的圖片)結合起來,以提供更全面的用戶畫像和預測。熱成像、觸覺和文字都更接近傳統意義上的模態。

#41

★★★★

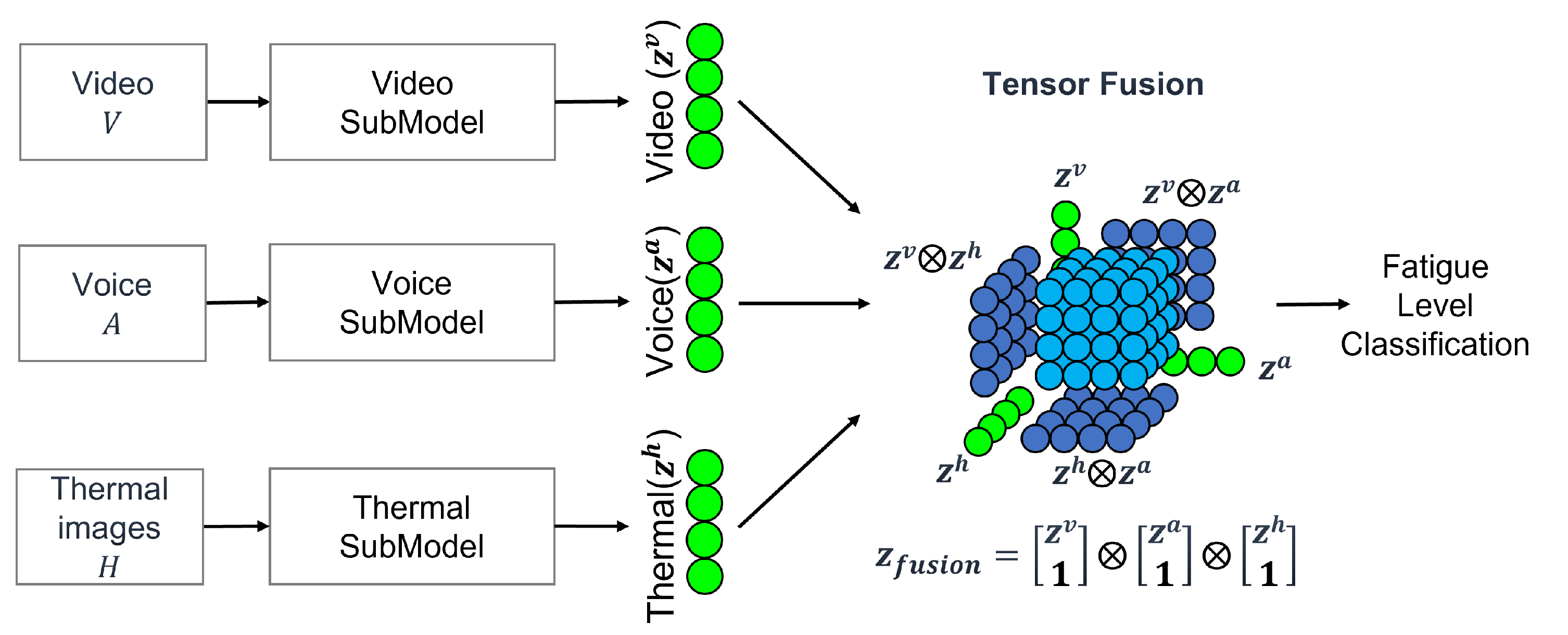

Tensor Fusion(張量融合)是一種多模態融合技術,它主要透過什麼數學運算來捕捉模態間的高階交互?

答案解析

簡單的融合方法如串接、加總或元素乘積只能捕捉模態間的線性或低階交互。Tensor Fusion(如 Low-rank Multimodal Fusion, LMF)等方法則利用張量外積(Tensor Outer Product)來顯式地建模不同模態特徵向量之間的所有成對(甚至更高階)的交互關係。外積操作會產生一個更高維度的張量,其中包含了模態間豐富的乘性交互資訊。雖然計算成本較高,但理論上能捕捉更複雜的模態依賴關係。後續通常會使用低秩分解等技術來降低計算複雜度。

#42

★★★★★

多模態表示學習中的「解耦」(Disentanglement)目標是指什麼?

答案解析

解耦表示學習(Disentangled Representation Learning)旨在學習一種表示,其中表示向量的不同部分能夠捕捉到數據生成過程中潛在的、相互獨立的變異因素(Factors of Variation)。例如,在人臉圖像中,可能希望表示向量的某些維度對應身份,另一些維度對應表情,還有一些對應光照條件。在多模態場景下,解耦可能意味著學習到的表示能夠區分哪些資訊是模態共享的(modality-shared),哪些是模態特定的(modality-specific)。這種解耦的表示通常被認為具有更好的泛化性、可解釋性和可控性。

#43

★★★

在進行跨模態生成任務(如文字生成圖像)時,常用來評估生成結果質量和多樣性的指標是?

答案解析

評估生成模型(尤其是圖像生成)的質量是一個挑戰。Inception Score (IS) 和 Fréchet Inception Distance (FID) 是兩種常用的評估指標。IS試圖同時衡量生成圖像的清晰度(單張圖像的可識別度)和多樣性(生成圖像類別的分佈)。FID則通過比較生成圖像的特徵向量分佈與真實圖像的特徵向量分佈之間的距離(通常使用預訓練的Inception網路提取特徵)來評估生成圖像的真實性和多樣性,FID 分數越低通常表示生成質量越好,與人類感知更一致。Accuracy, F1, MSE, AUC 主要用於分類或回歸任務,不直接適用於評估生成圖像的質量。

#44

★★★★

與單純將圖像和文字特徵串接後輸入Transformer不同,像ViLBERT或LXMERT這類模型的關鍵設計在於引入了什麼機制來實現更深層次的模態交互?

答案解析

早期的視覺-語言模型可能只是簡單地將提取的圖像特徵和文字特徵拼接起來送入一個共享的處理器。而像ViLBERT, LXMERT, UNITER等基於Transformer的雙流(two-stream)或單流(single-stream)架構,其核心創新在於引入了交叉注意力(Cross-Attention)或共同注意力(Co-Attention)機制。這些機制允許多個模態的表示序列在Transformer的層級中進行顯式的交互:例如,文字的表示可以關注(attend to)圖像的相關區域,反之亦然。這種深度交互使得模型能夠學習到更細粒度、更複雜的跨模態關聯,從而在各種視覺-語言任務上取得更好的性能。

#45

★★

利用穿戴式感測器收集的生理訊號(如心率、皮電反應)結合臉部表情來監測駕駛員的疲勞狀態,屬於多模態AI的哪個應用方向?

答案解析

駕駛員監控系統(DMS)是智慧汽車和自動駕駛領域的重要組成部分,旨在監測駕駛員的狀態(如注意力、疲勞度、情緒等)以提高行車安全。由於單一線索(如僅看臉部)可能不夠可靠,DMS常常利用多模態AI,結合來自攝影機的視覺資訊(臉部表情、眼睛開合度、頭部姿態)和來自其他感測器的生理訊號(心率、呼吸率、皮電活動等),甚至車輛本身的駕駛行為數據,來更準確地判斷駕駛員是否處於疲勞、分心或其他不安全狀態。

#46

★★★

多模態AI模型可能繼承訓練數據中的社會偏見(Social Bias),例如在圖像描述生成中對不同性別或膚色的人產生刻板印象的描述。應對這個挑戰的策略不包含?

答案解析

演算法偏見是AI倫理中的一個重要議題,多模態AI也不例外。由於訓練數據來源於充滿偏見的現實世界(尤其是網路數據),模型很可能學習並放大這些偏見。應對策略通常包括:(1) 數據層面:努力收集或構建更多元、更平衡、代表性更廣的數據集,並進行數據審計;(2) 演算法層面:設計能夠減輕偏見影響的模型架構、損失函數或訓練策略;(3) 後處理層面:在模型輸出後進行檢測和修正。完全避免使用真實世界數據是不現實的,因為模型需要從真實數據中學習知識。關鍵在於如何負責任地收集、處理數據和設計模型。

#47

★★★

研究多模態互動(Multimodal Interaction)的主要動機是?

答案解析

人類之間的溝通本身就是多模態的,我們會同時使用語言、語氣、表情、手勢、眼神等多種方式來傳達和理解訊息。多模態互動的研究目標就是讓電腦系統也能夠理解和使用這些多種溝通管道,從而讓人機互動變得更自然、更直觀、更靈活、更有效率,就像人與人之間的交流一樣,而不是受限於傳統的、較為單一和刻板的互動方式(如僅限鍵盤輸入)。

#48

★

在多模態數據中,文字數據通常被表示為什麼形式輸入到深度學習模型中?

答案解析

深度學習模型通常無法直接處理原始的文字字符串。標準做法是先將文字進行分詞(tokenization),然後將每個詞(或子詞)映射到一個低維、稠密的實數向量,稱為詞嵌入(word embedding),例如使用Word2Vec, GloVe或BERT等方法獲得。這樣,一段文字就轉換成了一個詞嵌入向量的序列,這個序列可以被RNN, CNN或Transformer等模型處理。選項A是圖像表示,C是音頻表示,D是3D數據表示。

#49

★★★

哪種多模態融合策略在理論上最有可能丟失模態間的細粒度交互資訊?

答案解析

晚期融合(決策層融合)的特點是先獨立處理每種模態,直到最後的預測階段才進行整合。這意味著在模型的大部分處理過程中,不同模態的資訊是分開的,沒有機會進行交互。因此,模態之間在較低層次或中間層次的細微關聯和交互作用很可能在這個過程中丟失了,模型只能利用每個模態獨立得出的高層次預測結果進行融合。相比之下,早期融合、中間融合(如注意力機制、張量融合)都允許在模型的更早或內部階段進行模態交互。

#50

★★

多模態表示學習是為了讓模型學習到數據的某種「表示」,這種表示通常是什麼形式?

答案解析

在現代深度學習中,表示學習(Representation Learning)通常指將原始的、高維的、異質的輸入數據(如圖像像素、文字序列)轉換為低維、稠密、包含豐富語意資訊的數值向量(也稱為嵌入向量 Embedding Vector 或特徵向量 Feature Vector)。這些向量捕捉了數據的關鍵特徵,並且更容易被後續的機器學習模型(如分類器、回歸器)處理。多模態表示學習的目標就是為多種模態數據學習到這樣有效的向量表示,無論是在共享空間還是協調空間中。

#51

★★★★

跨模態檢索(Cross-modal Retrieval)任務,例如用一段文字描述來搜尋最相關的圖片,其核心挑戰在於?

答案解析

跨模態檢索的目標是根據一種模態的查詢(Query),在包含另一種或多種模態的數據庫中找到最相關的項目。例如,輸入文字「紅色跑車」,希望找到資料庫中紅色跑車的圖片。要實現這一點,模型需要能夠理解不同模態數據的語意內容,並將它們映射到一個共同的表示空間或學習一個跨模態的相似度度量,使得在這個空間或度量下,語意相關的跨模態數據(如文字描述和對應的圖片)能夠被匹配起來(例如,它們的表示向量距離近或相似度高)。因此,核心挑戰在於如何有效地學習和衡量跨模態的語意相似度。

#52

★★★

在設計多模態模型架構時,「雙流」(Two-Stream)架構通常指的是?

答案解析

在多模態學習中,雙流架構(或更一般的多流架構 Multi-Stream Architecture)是一種常見的設計模式。它為不同的輸入模態(例如,一個流處理視覺,另一個流處理語言)設計各自獨立的特徵提取或編碼網路分支。這些獨立的流可以在處理到一定深度後,通過特定的融合機制(如串接、注意力、張量積等)將它們的資訊結合起來,進行聯合處理或預測。這種架構允許針對不同模態的特性使用專門的處理方式,然後再進行交互。與之相對的是單流架構(Single-Stream Architecture),即從一開始就將不同模態的輸入(或其早期表示)混合在一起,在一個共享的網路中處理。

#53

★★★★

視覺問答(Visual Question Answering, VQA)系統需要具備哪些核心能力?

答案解析

VQA是一個典型的需要深度融合視覺和語言資訊的多模態任務。一個成功的VQA系統必須:(1) 能夠深入理解輸入圖像的內容,包括物體識別、屬性判斷、場景理解、物體間關係等;(2) 能夠準確理解以自然語言提出的問題的語意和意圖;(3) 最關鍵的是,能夠將從圖像中提取的視覺資訊和從問題中提取的語意資訊進行有效的關聯和推理(跨模態推理),最終生成(或選擇)一個準確的答案。這通常需要模型具備複雜的注意力機制和推理能力。

#54

★★

目前多模態AI在處理需要精確物理常識或複雜因果推理的任務時,仍面臨挑戰,這反映了當前模型在哪方面可能存在不足?

答案解析

雖然現代多模態模型在感知(如看懂圖像、聽懂語音)和模式匹配方面取得了巨大進步,但在更高層次的認知能力,如結合物理世界常識進行推理(例如,預測一個物體掉落後的狀態)或理解事件之間的因果關係方面,仍然相對薄弱。目前的模型主要依賴從大量數據中學習到的統計關聯,而非真正理解背後的物理定律或因果機制。如何將常識知識和因果推理能力有效地整合到多模態模型中,是未來發展的重要方向和挑戰。

#55

★★★★

多模態學習中的五大核心挑戰(根據Baltrušaitis等人2018年的綜述),不包含以下哪一項?

答案解析

根據該領域的經典綜述文章 "Multimodal Machine Learning: A Survey and Taxonomy" (Baltrušaitis, Ahuja, and Morency, 2018),多模態機器學習面臨五個核心技術挑戰:(1) 表示(Representation):如何學習有效的多模態表示;(2) 對齊(Alignment):如何找到不同模態數據間的對應關係;(3) 融合(Fusion):如何結合來自多個模態的資訊;(4) 翻譯/生成(Translation/Generation):如何將資訊從一個模態轉換到另一個模態;(5) 協同學習(Co-learning):如何利用一個模態的資訊來輔助另一個模態的學習。雖然模型部署是工程上的重要問題,但它不屬於該綜述中定義的核心技術挑戰。

#56

★★★

哪種融合策略最適合用於不同模態數據在時間上可能嚴重不同步(asynchronous)的情況?

答案解析

早期融合通常需要不同模態的特徵在輸入層面對齊(例如時間上同步),以便進行串接或簡單運算。需要嚴格時間對齊的注意力機制也對同步性有要求。晚期融合則先獨立處理每個模態,可以在各自的時間尺度上進行分析和預測,最後再整合結果。因此,它對模態間的時間同步性要求最低,最適合處理時間上可能嚴重不同步的多模態數據流。

#57

★★

將圖像特徵和文字特徵都映射到一個高維的共享向量空間,這種做法屬於多模態表示學習中的哪種類型?

答案解析

聯合表示學習的目標是將來自不同模態的數據映射到同一個共享的潛在表示空間。在這個空間中,可以直接比較和整合不同模態的資訊。例如,CLIP模型就是學習一個聯合的圖文表示空間。協調表示則是學習不同但相關聯的空間。

#58

★★★

Vision Transformer (ViT) 將圖像分割成小塊(patches)並視為序列輸入到Transformer中,這種處理方式對後續的視覺-語言融合有何影響?

答案解析

ViT的關鍵思想是將圖像轉換為一個個patch嵌入的序列,再加上位置編碼,使其能夠像處理文字序列一樣被標準的Transformer架構處理。這種範式轉變使得視覺和語言兩種模態在輸入表示層面就具有了相似的序列結構。這極大地促進了視覺-語言統一模型(如單流架構)的發展,因為同一個Transformer編碼器可以更自然地同時處理來自兩種模態的序列表示,並透過自注意力和交叉注意力機制學習它們之間的深度交互。

#59

★★★★

為一段無聲影片自動配上合理的音效(如腳步聲、關門聲、環境音),這項技術屬於多模態AI的哪個應用方向?

答案解析

這項任務需要模型理解影片的視覺內容(例如,有人在走路、門被關上、場景在戶外),並根據這些視覺線索生成或選擇對應的、聽起來自然的音效。輸入是視覺模態(無聲影片),輸出是聽覺模態(音效)。這是一個典型的從視覺模態到聽覺模態的跨模態生成任務,有時也被稱為視覺引導的音訊生成(Visually-Guided Audio Generation)或視覺音效合成(Visual Sound Synthesis)。

#60

★★★

關於多模態AI的未來發展,哪項描述相對最不可能是主要趨勢?

答案解析

多模態AI的發展趨勢包括:(A) 拓展到更多模態,更全面地模擬人類感知;(B) 關注AI倫理,提升模型的可信賴度;(D) 增強模型的認知能力,使其不僅能感知,還能理解和推理。然而,(C) 雖然模型效率和輕量化是研究方向之一(例如為了邊緣運算),但從目前大型多模態模型的發展來看,為了追求更強的能力,模型的複雜度和參數量在短期內更可能繼續增長而非大幅降低。通用大模型和專用輕量化模型可能會並存發展,但「大幅降低」複雜度可能不是最主要或最普遍的趨勢,尤其對於前沿研究而言。

沒有找到符合條件的題目。

↑